Research on trajectory recognition and control technology of structured light vision-assisted welding

-

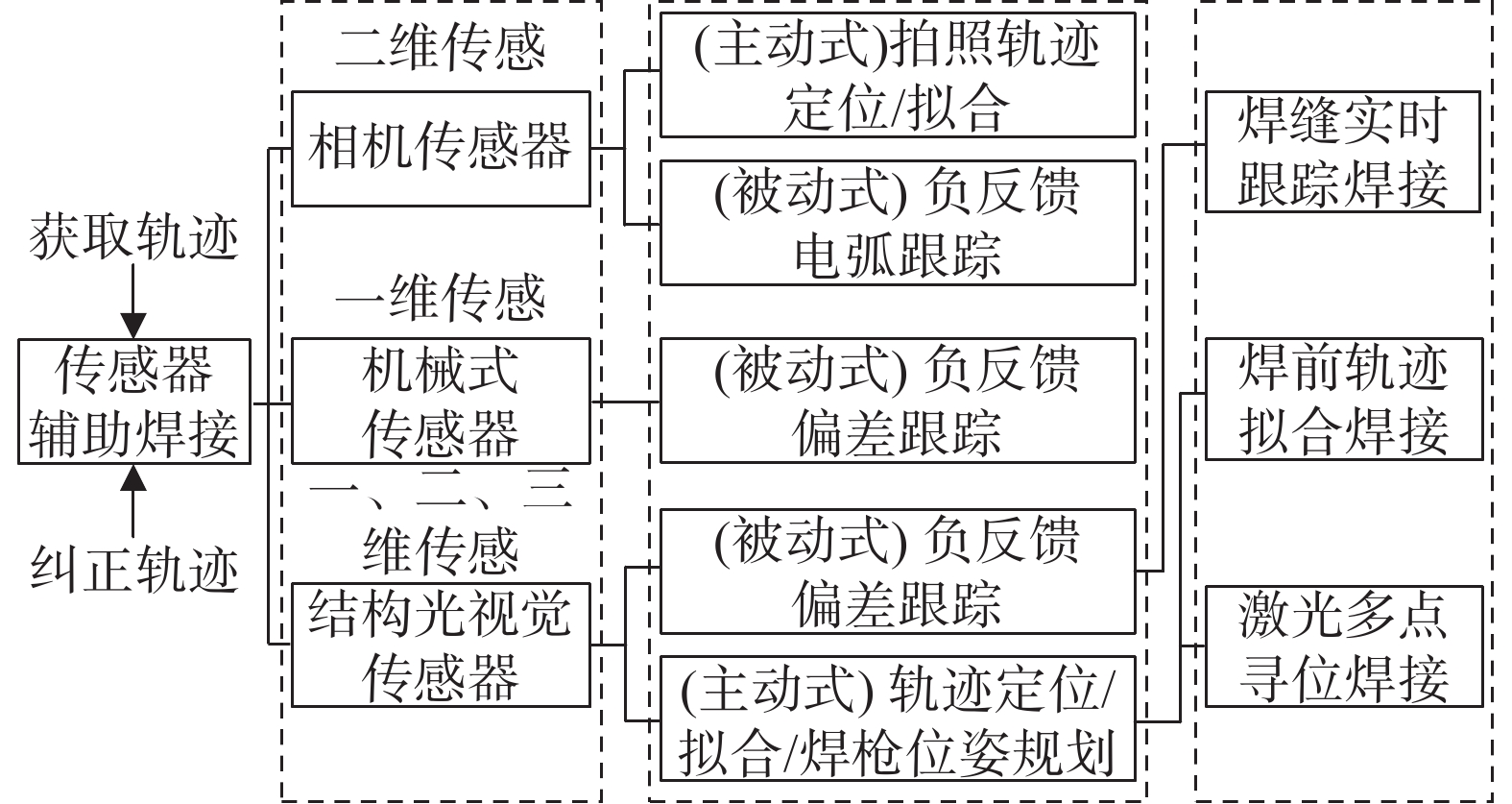

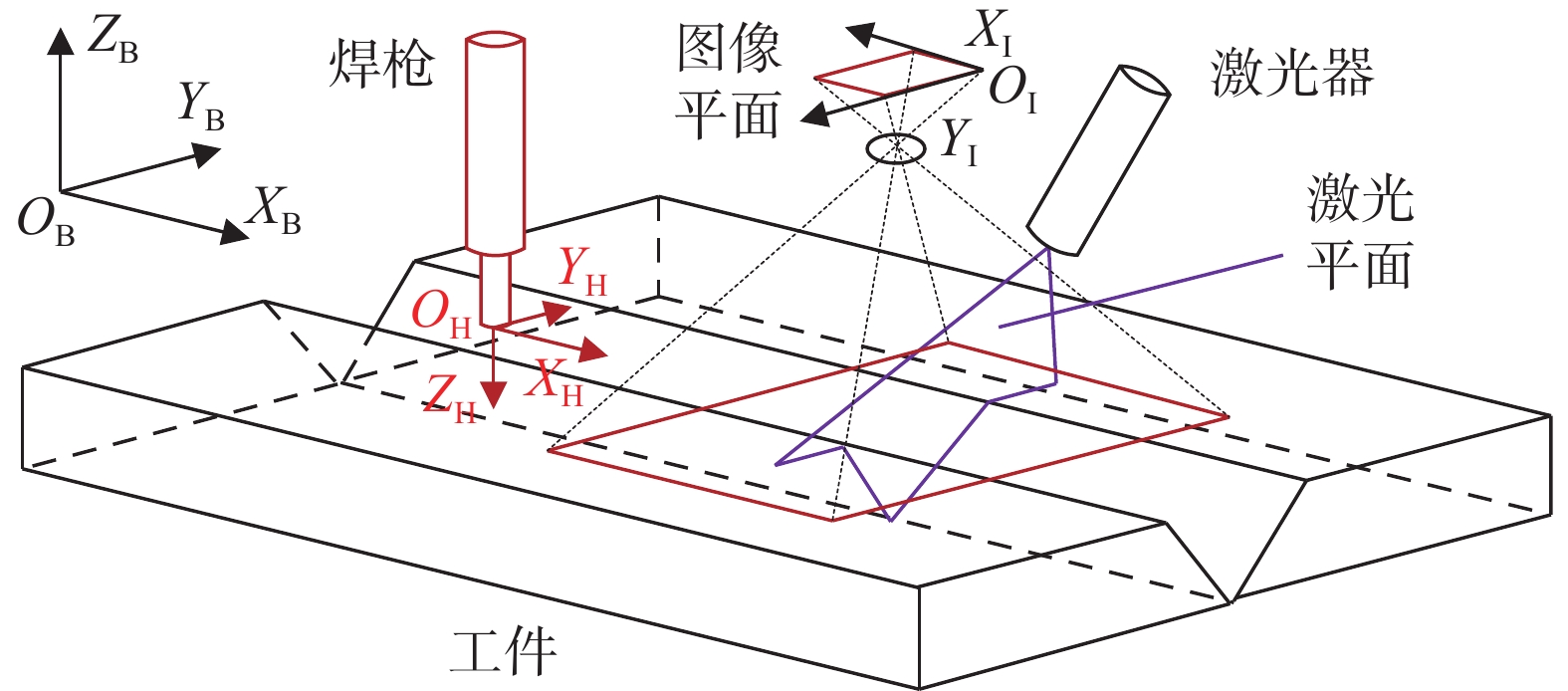

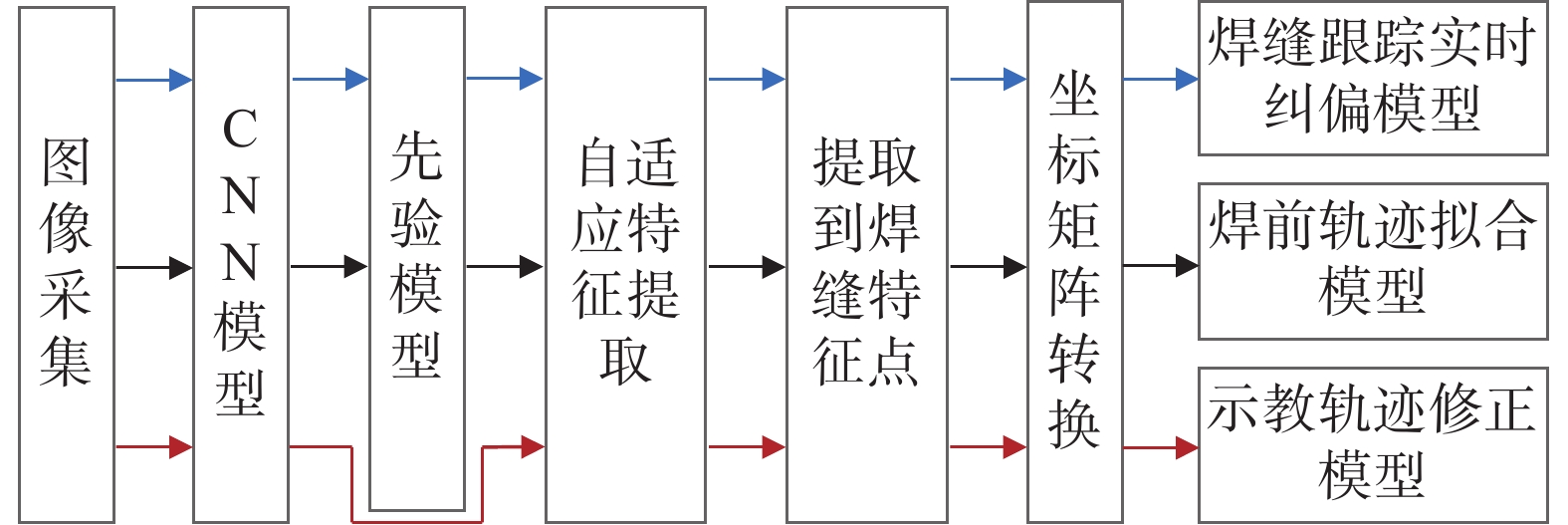

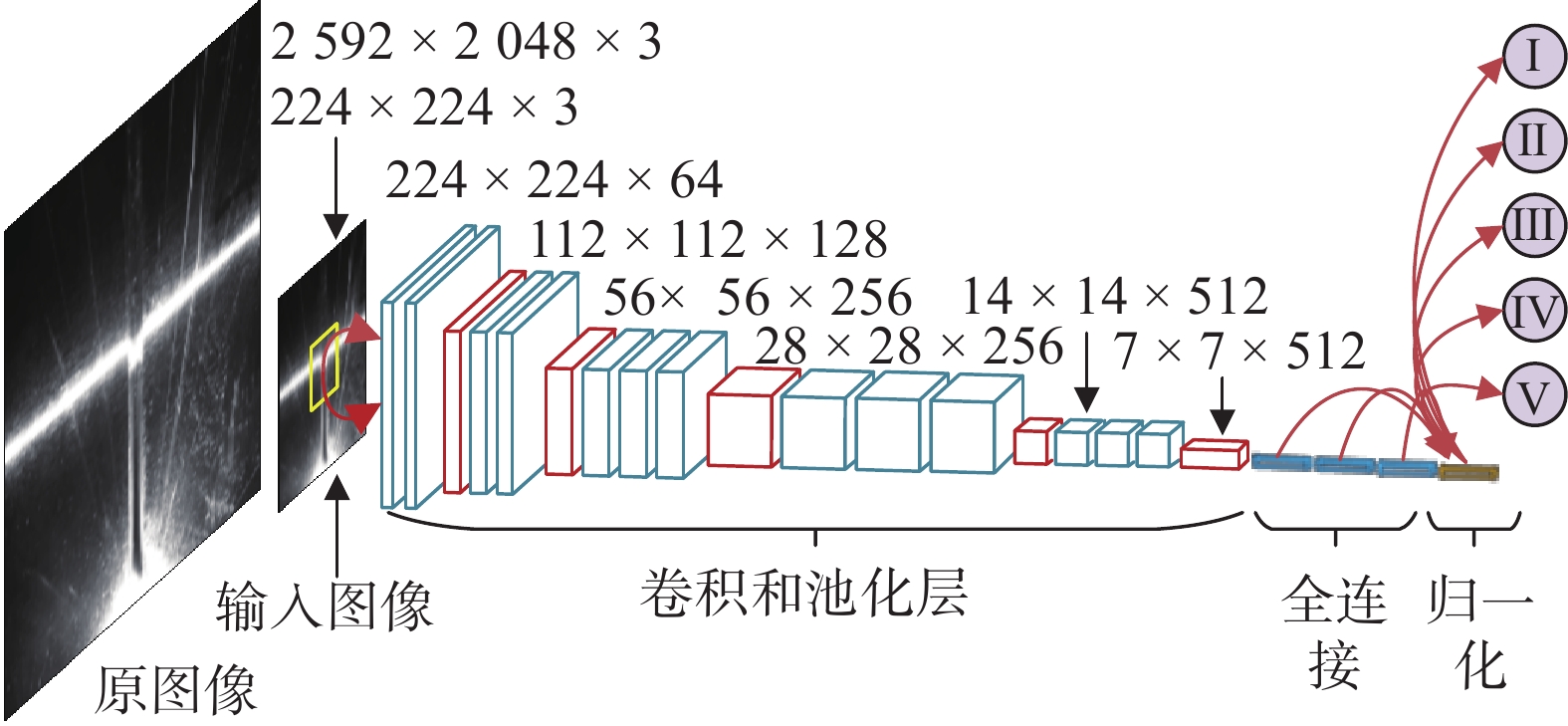

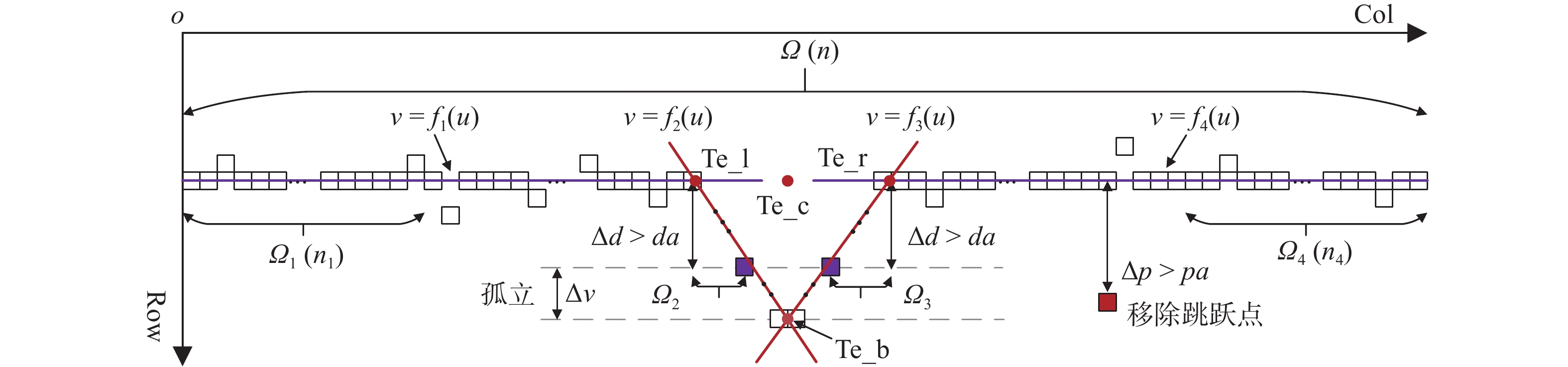

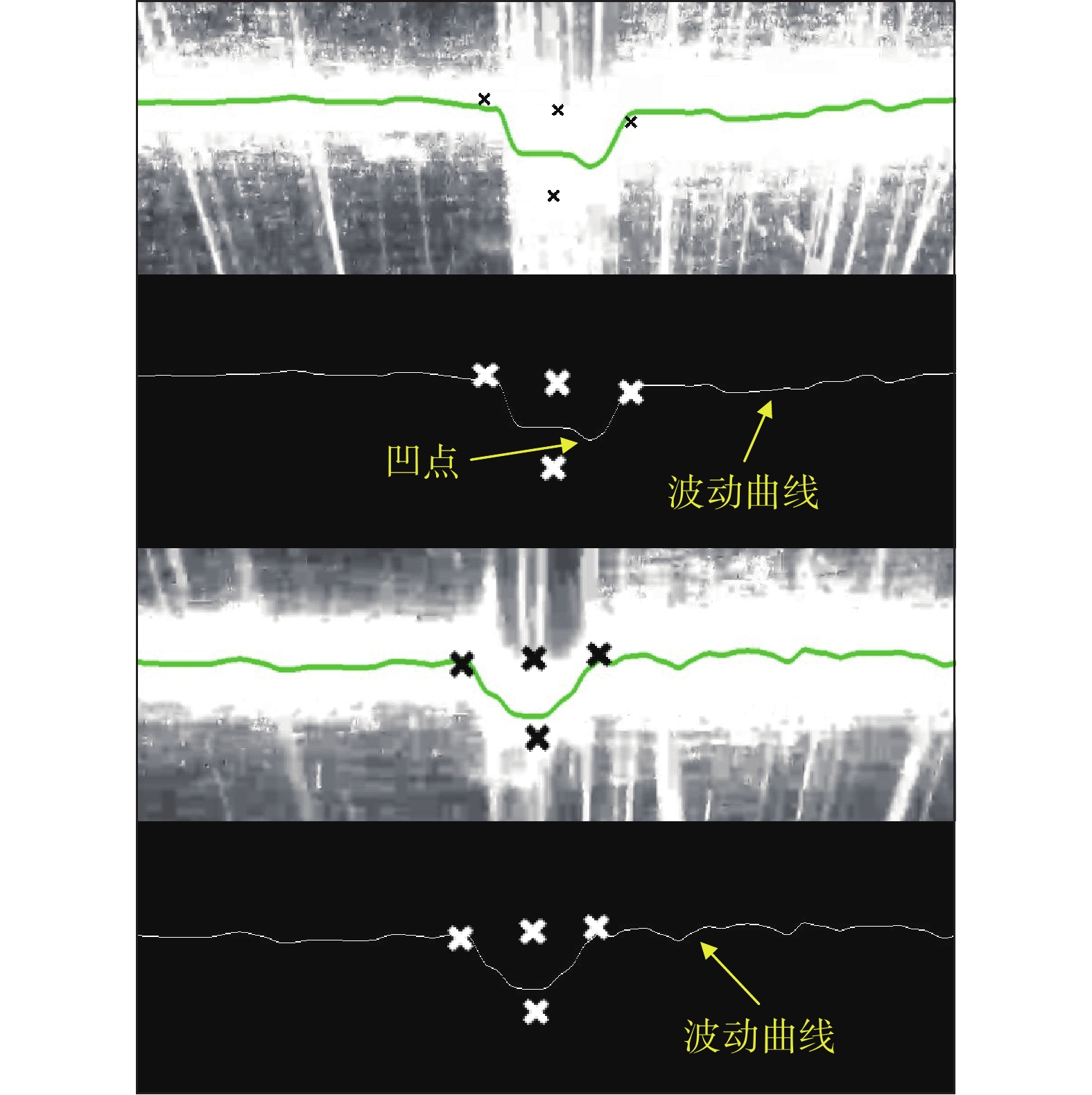

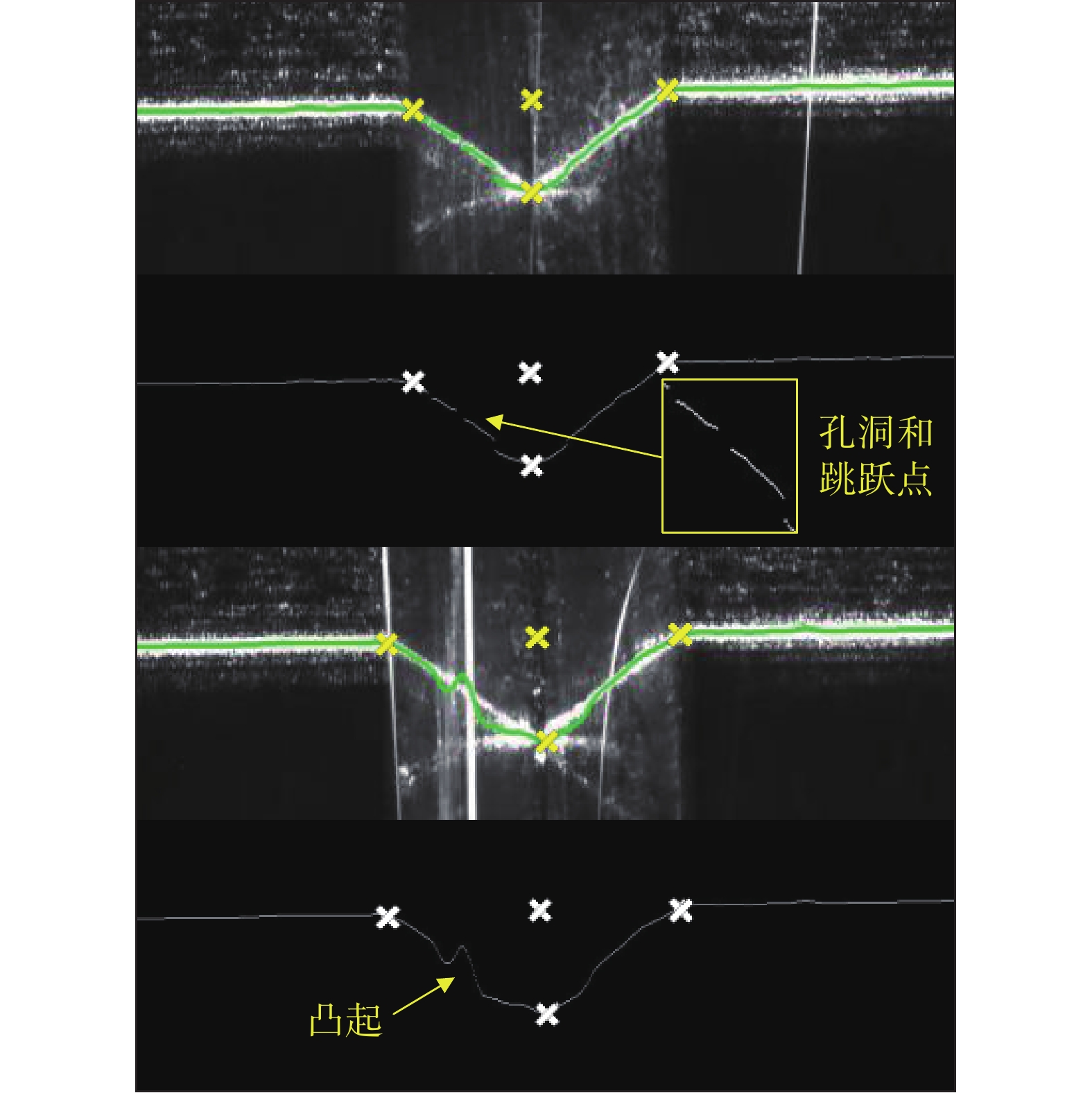

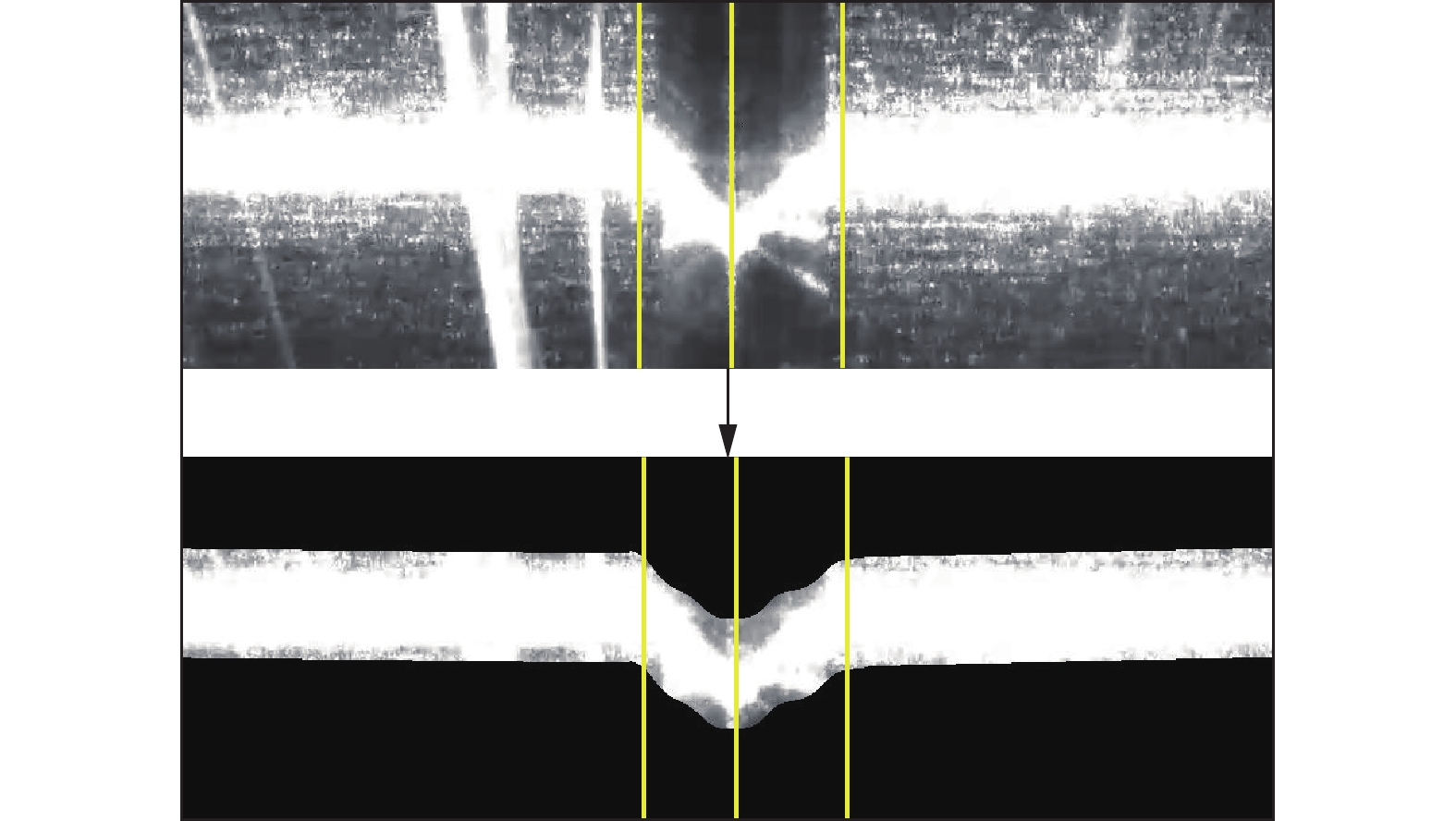

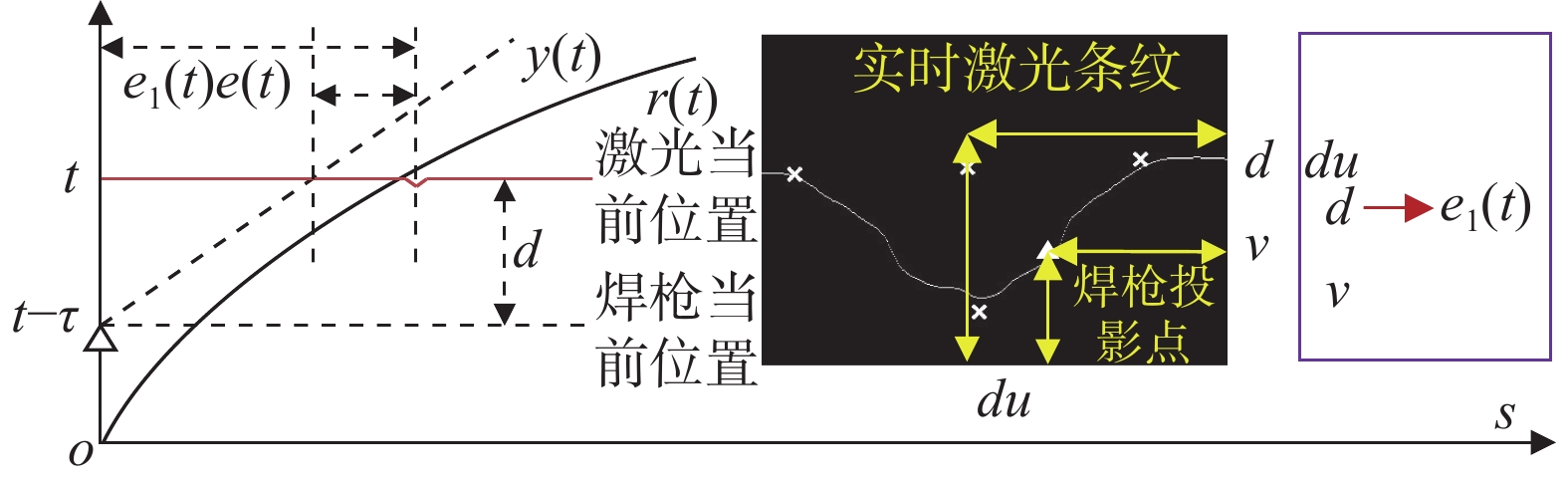

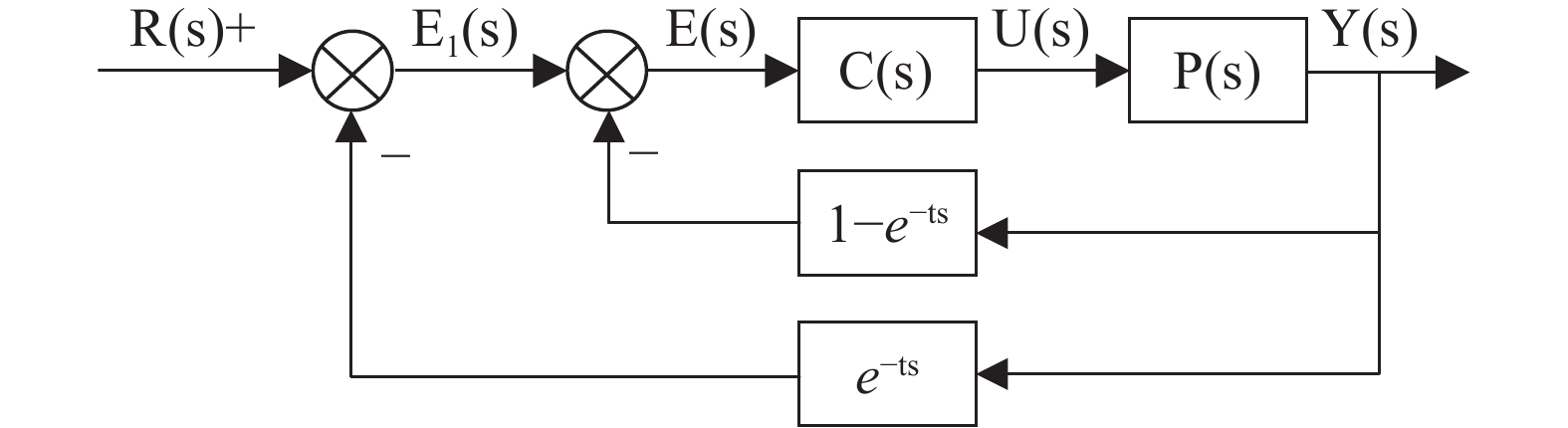

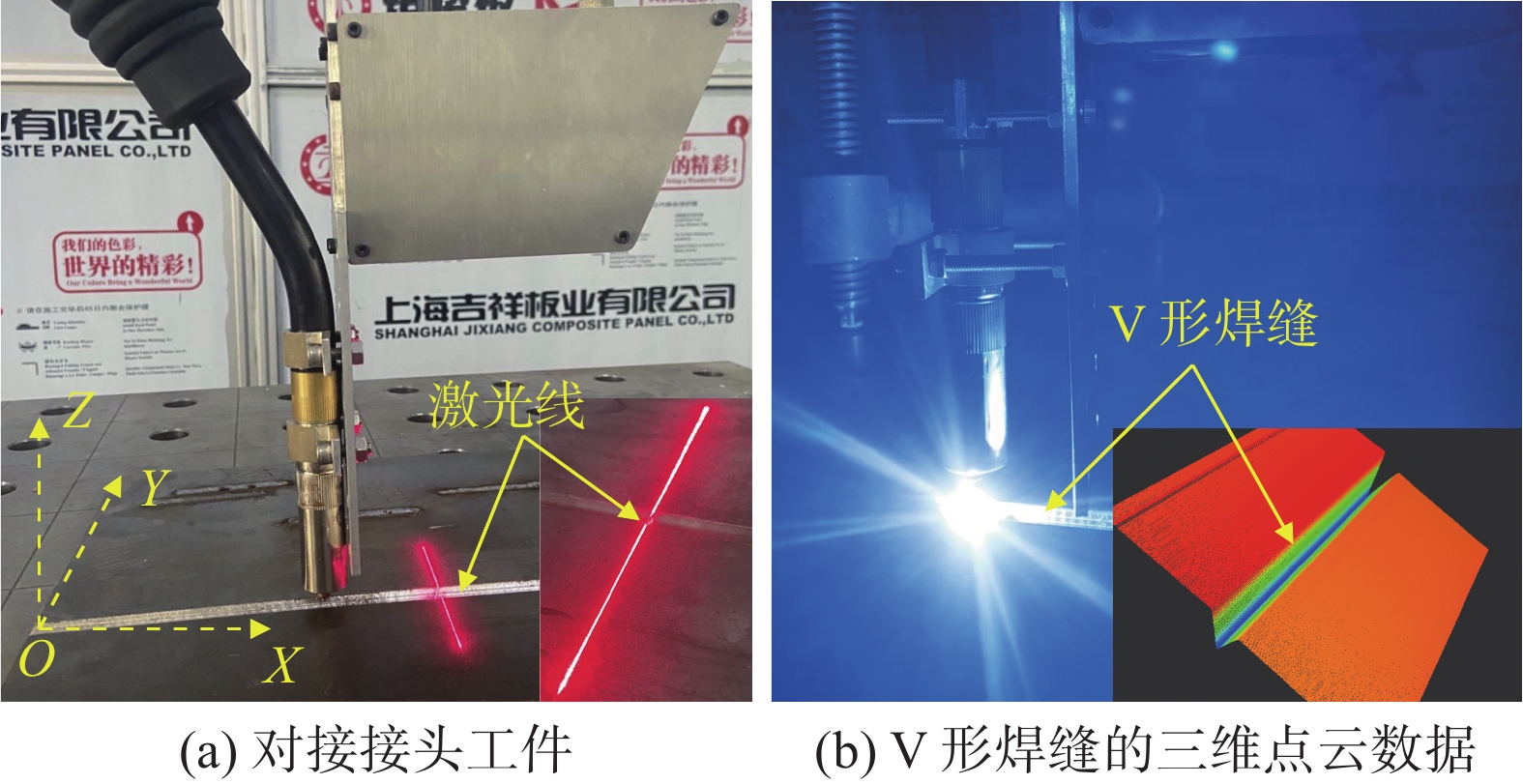

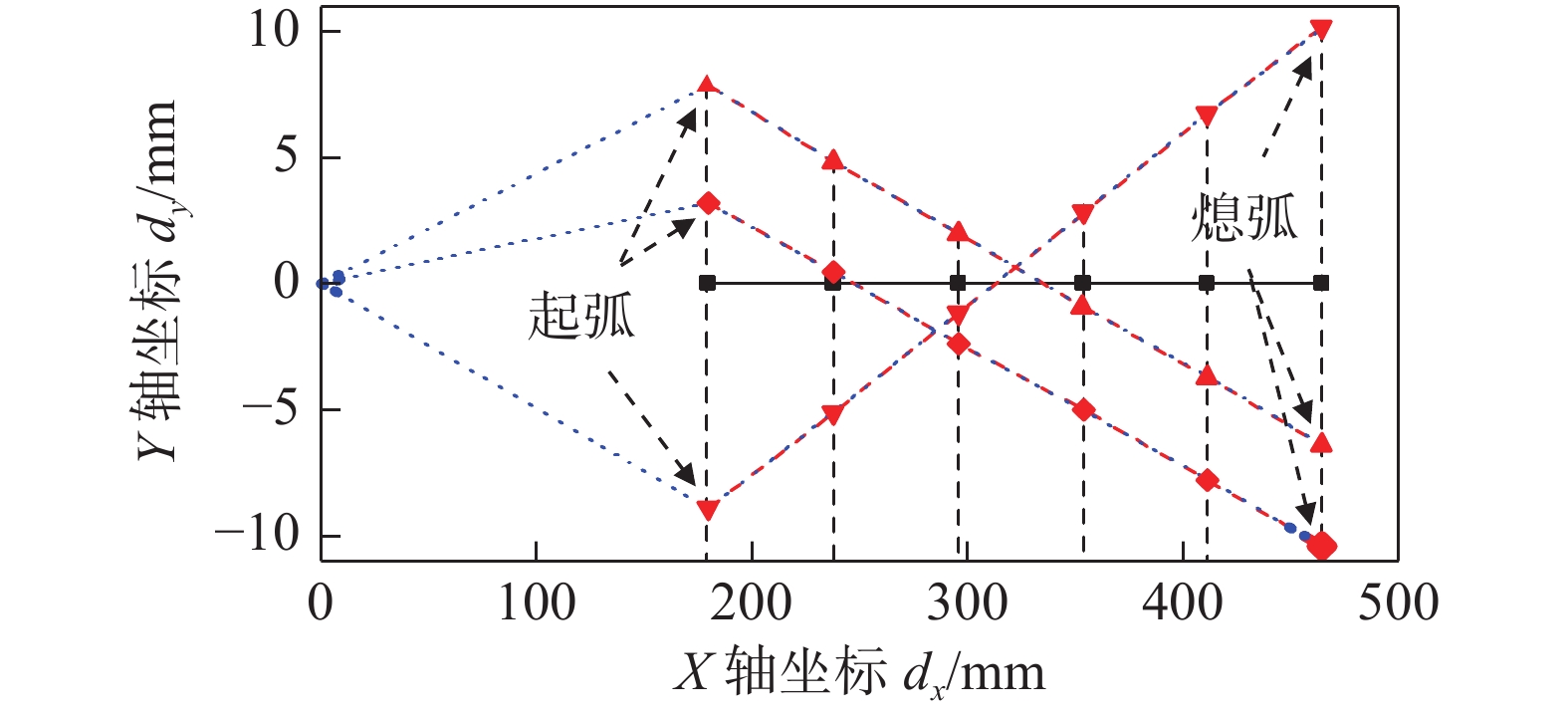

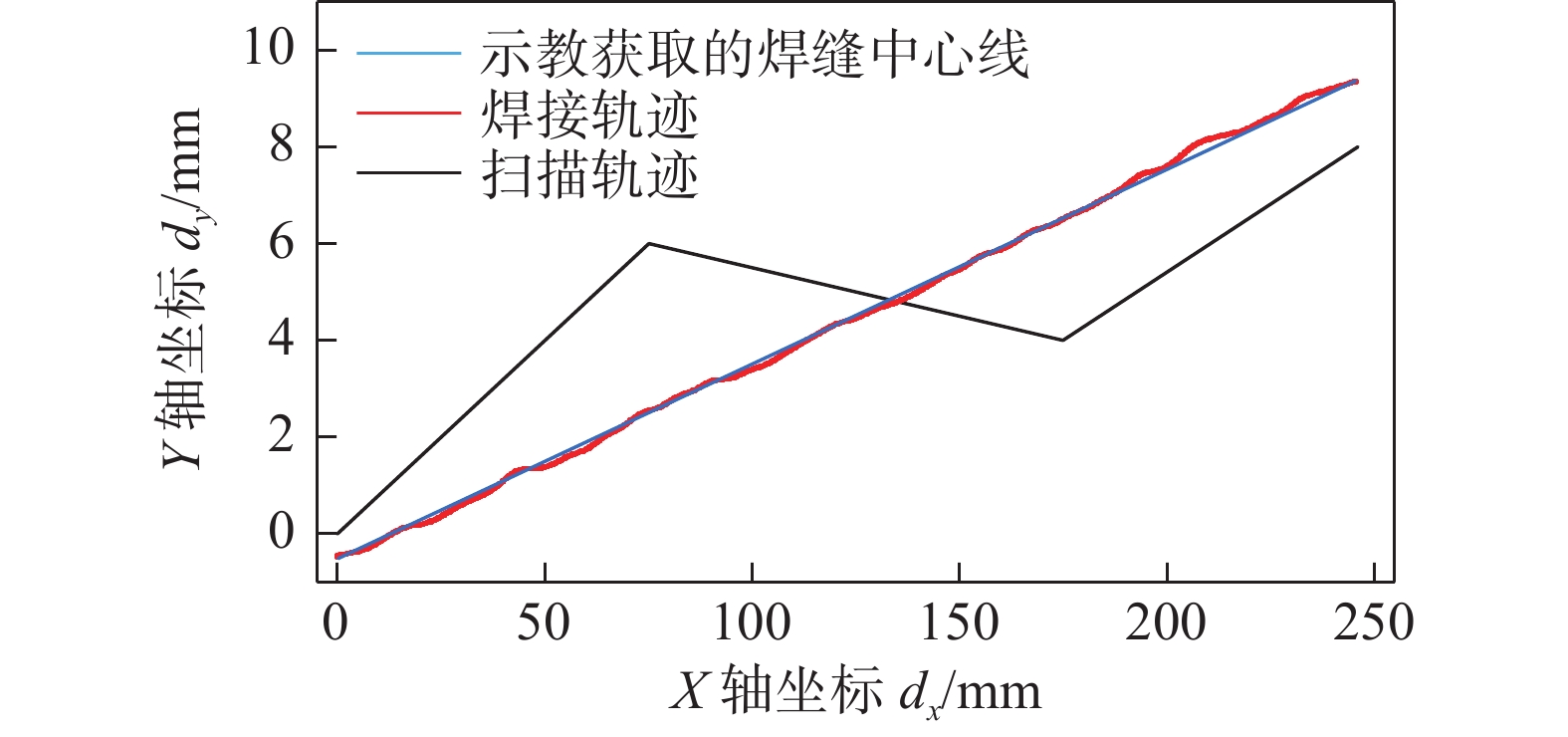

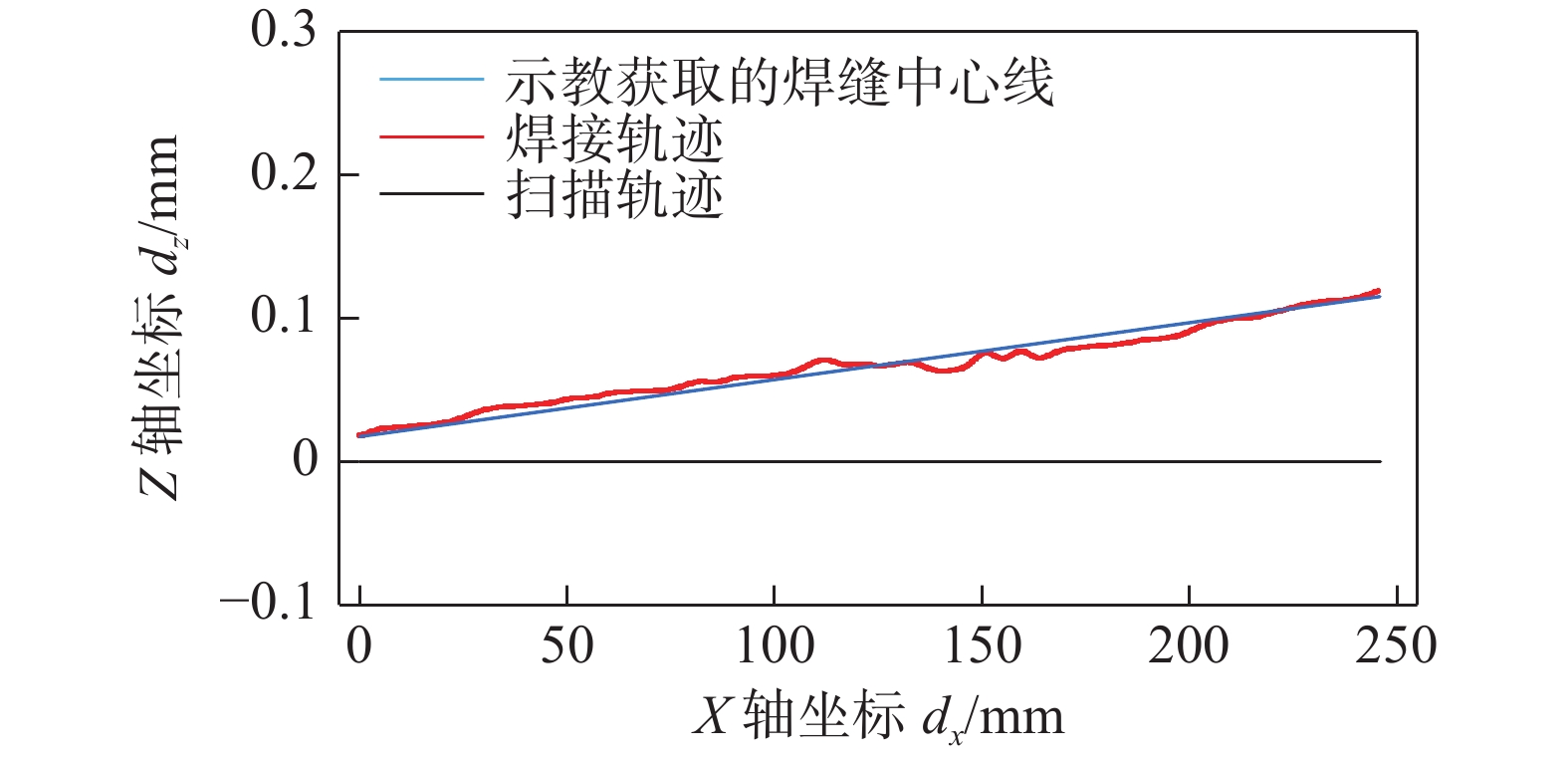

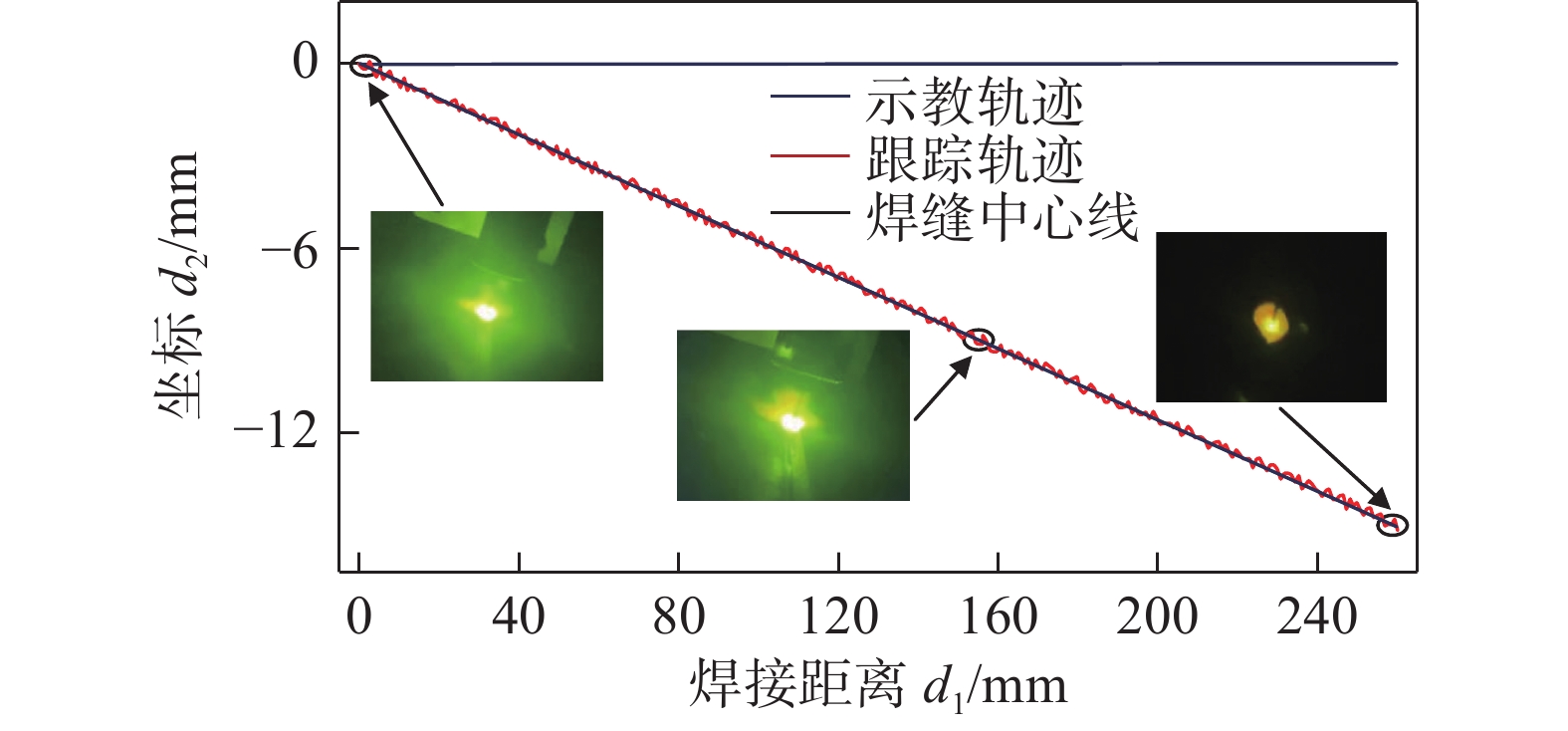

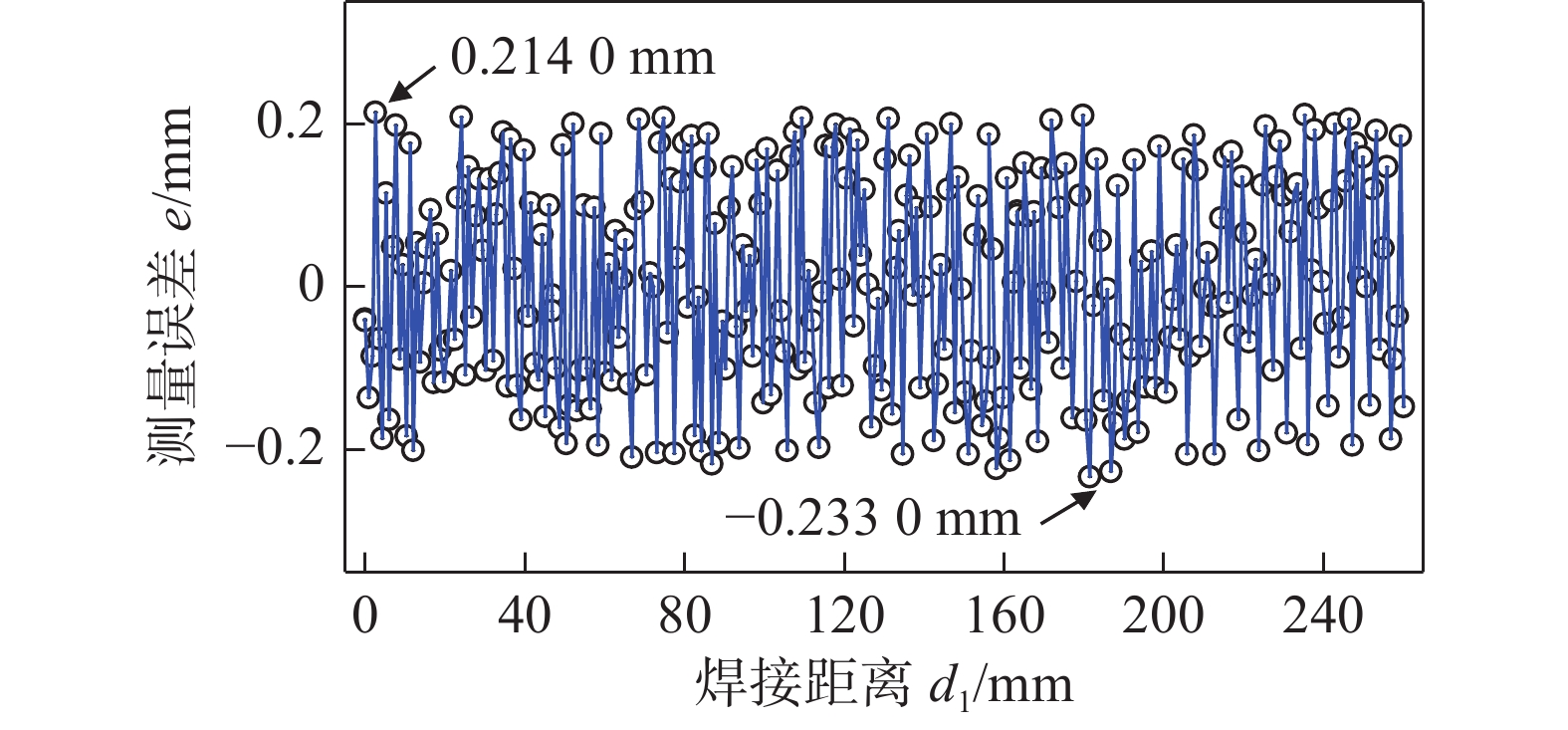

摘要: 对激光多点寻位、焊前轨迹拟合、焊缝实时跟踪的3种结构光视觉辅助焊接的轨迹识别与控制技术进行了研究.提出了适用于上述三者的以CNN模型、自适应特征提取算法、先验模型、坐标矩阵转换为核心的焊接轨迹识别流程.提出了分别对应上述三者的焊接轨迹控制模型:示教轨迹修正模型、焊前轨迹拟合模型、焊缝跟踪实时纠偏模型. 结果表明,激光多点寻位、焊前轨迹拟合模式焊接时,能够在焊前高效地识别出焊接轨迹曲线,焊接轨迹与焊缝中心线基本重合;焊缝实时跟踪模式焊接时,系统能够实时矫正焊枪的偏差.文中提到的焊接轨迹识别流程与轨迹控制模型足以保证结构光视觉辅助焊接的稳定运行.Abstract: Three trajectory recognition and control techniques for laser multi-point positioning, pre-welding trajectory fitting, and seam real-time tracking for structured light vision-assisted welding are investigated. A CNN model, adaptive feature extraction algorithm, a priori model, and coordinate matrix conversion are proposed as the core of the welding trajectory recognition process for these three. Welding trajectory control models are proposed for each of the above three, which including a taught trajectory correction model, a pre-welding trajectory fitting model, and a real-time deflection correction model for seam tracking. The experiments prove that laser multi-point positioning, pre-welding trajectory fitting model can efficiently identify the weld trajectory curve before welding, and the welding trajectory basically coincides with the centerline of the seam; when welding in the real-time seam tracking model, the real-time deviation is mainly controlled within ± 0.2 mm, with an average deviation of 0.1160 mm. The results show that the welding trajectory identification process and trajectory control model mentioned in this paper are sufficient to ensure stable operation of structured light vision-assisted welding.

-

Keywords:

- structured light vision /

- trajectory recognition and control /

- welding

-

0. 序言

焊接质量在线监测是智能化焊接的关键技术之一[1],其中,焊接熔透状态的在线识别/预测作为一种不可或缺的焊接质量监测手段,能够为焊接工艺参数的在线控制提供实时反馈,对提升焊缝质量稳定性与生产效率具有重要意义.

熔池形态与焊缝成形质量密切相关.目前,光谱传感[2]、电弧声信号[3]和视觉传感[4–6]等多种传感技术已广泛用于获取智能机器人弧焊过程中的瞬态信息. 与其他传感技术相比,视觉传感器具有抗干扰能力强、成本低、信息量大、非接触式等突出优点,因此,许多研究者倾向于使用视觉传感器实现焊接熔透的评估和控制. 此外,视觉传感器与机器学习方法的结合已成为焊接质量监测发展的新趋势. CHEN等人[7] 基于主动外观模型(AAM)的熔池视觉特征提取和随机森林(RF)算法实现脉冲GTAW熔透状态预测;洪宇翔等人[8] 提出一种新的熔池特征“平直度特征”,在单一特征输入条件下支持向量机(SVM)模型TIG缺陷分类准确率达95.94%. 然而,传统机器学习方法的监测性能严重依赖人工定义和提取的显式特征,需要全面的专家知识.

近年来,以卷积神经网络(CNN)为代表的深度学习算法因其出色的高级特征学习和非线性信息处理能力在焊接监测任务中表现突出,显著优于传统机器视觉算法.例如,马晓峰等人[9] 提出一种结合生成对抗网络(GAN )与改进 PSPNet 的熔池深度学习监测方法,实现对熔池的动态跟踪与精准检测;CAI等人[10] 采用U-Net语义分割模型精准提取熔池和锁孔轮廓,并构建CNN模型用于预测四种激光熔透状态;李春凯等人[11] 构建深度卷积神经网络建立了熔池表面激光反射条纹与脉冲钨极气体保护焊(P-GTAW)不同熔透状态的映射关系. 然而,焊接是一个具有不确定性的非线性时变过程[12],虽然深度学习可以很好地处理数据,但由于动态焊接过程的复杂性[13],有效的熔池动态建模仍然是一个难题. 基于正面熔池和匙孔图像提取的时序几何特征信息,刘秀航等人[14] 提出的WPD-LSTM 算法对激光—熔化极惰性气体复合焊过程中出现的根部驼峰预测准确率达到97.85%;JIAO等人[15] 通过CNN将焊缝熔透状态与多帧熔池图像融合后的复合图像相关联,该方法有效提高了GTAW的熔透状态预测精度. 尽管上述方法能够自适应地提取复杂、抽象的高级特征,但它们都属于黑箱建模方法,模型的可解释性较差. 此外,在实际焊接生产中,采集大量不同熔透状态的数据样本用于训练深度学习模型成本高昂.

通过利用先验知识降低深度学习对大规模标注数据的依赖,成为当前焊接熔透状态智能预测领域的一支新兴研究方向. GAO 等人[16]利用激光线图像提取坡口槽角作为人工先验知识,并结合DenseNet模型提取的深度特征用于熔化极气体保护焊(GMAW)的背部熔宽预测;WU等人[17] 将基于人类焊工先验知识提取的锁孔几何特征和CNN提取的高级判别特征相结合,开发了一种焊工智能增强深度随机森林融合(WI-DRFF)方法准确预测四种典型变极性等离子弧焊(VPPAW)焊缝熔透状态;LIU 等人[18] 提出了一种新的知识和数据混合驱动模式激光焊熔透状态识别方法. 具体来说,设计了一种标签语义注意机制(LSA)建模人类先验知识,从而利用标签语义特征指导CNN学习判别性的视觉特征. 可以看出,知识增强的深度学习方法可以同时利用知识和数据两者的优势,从而有效提高目标任务的完成效果. 然而,上述文献主要侧重于对静态熔池几何形态特征专家知识的利用,未考虑熔池在焊接过程中的动态演变信息,可能丢失能反映熔透状态的重要时序特征.

文中提出了一种基于熔池动态形变知识增强的深度学习GTAW熔透状态预测框架. 通过语义分割和多帧图像的熔池轮廓融合方法,提取熔池动态形变特征作为专家先验知识,将动态熔池轮廓图像和单帧原始熔池图像合成,学习同一位置熔池轮廓像素变化,指导CNN模型预测熔透状态. 该方法有效缓解了经典卷积神经网络对训练数据的高要求,在提高识别精度的同时增强了模型的可解释性. 与未融合熔池动态形变特征专家知识的深度学习方法相比,模型预测性能更优.

1. 试验系统与分析

如图1所示,焊接试验系统包括焊枪、焊接电源、冷却水箱、保护气体、机械臂及执行机构、工控机、工业计算机和视觉传感系统. 焊接电源的工作模式为直流正接(DCEN),焊接材料为2219 铝合金. 视觉传感系统由Photonfocus 高速摄像机CMOS和一个窄带滤光片(660 nm + 10 nm)组成,该滤光片置于高速摄像机前方,抑制弧光辐射.摄像机帧率为250 帧/s,获取的熔池图像如图2 所示,主要包含钨极、钨极倒影和熔池区域3个部分.将高速摄像机采集的熔池图像传输到工业计算机,在工业计算机上进行图像处理、模型训练和熔透状态预测,焊接试验参数见表1.

表 1 焊接试验参数Table 1. Welding experiment paraments焊件尺寸

(L × W × H)/mm氦气流量

q/(L·min−1)焊接电流

I/A焊接速度

v/(mm·s−1)钨极直径

d/mm300 × 150 × 5 12 155 ~ 175 270 5.0 为了预测GTAW典型熔透状态,在不同的焊接电流下进行了一系列焊接试验,文中将熔透状态分为三类,即部分熔透、适度熔透和过度熔透,如图3所示.

2. 基于知识增强CNN熔透预测方法

2.1 DeepLabv3 + 语义分割模型

文中基于MobileNetv2 和ASSP 构建模型DeepLabv3 + ,如图4所示.在编码器阶段,使用MobileNetv2 骨干网络进行特征提取,该网格在使用深度可分离卷积的基础上引入了倒转残差模块和线性瓶颈层结构,大大减少了模型参数的数量,使网络收敛速度更快. 对于倒转残差模块,首先采用1 × 1卷积对输入特征进行升维,随后深度卷积进行过滤并提取特征图,并使用ReLU6 作为激活函数,最后使用1 × 1卷积对特征进行降维处理以获得特征信息. ASPP 是由空洞卷积与空间金字塔池化融合组成,将基于骨干网络MobileNetv2提取的特征图送入ASPP模块. 在ASPP模块中,首先进行1 × 1卷积操作,随后进行不同扩张率的3 × 3卷积操作,最后进行池化处理对特征图进行降维,将每个分支得到的特征映射进行连接,最后使用1 × 1的卷积对特征进行压缩和整合.

在解码器阶段,采用双线性插值对融合深度特征图进行4倍上采样,然后将其与MobileNetv2提取的底层特征图进行拼接融合,最后通过3 × 3卷积和4倍上采样双线性插值恢复到原始图像的大小,得到最终的输出图像.

2.2 多帧熔池轮廓图像融合方法

对语义分割得到的熔池区域进行阈值分割和边缘轮廓检测图像处理算法提取熔池轮廓,熔池轮廓可以反应熔池动态变化,通过多帧熔池轮廓图像融合提取熔池动态形变,可以有效提供焊接过程中的动态演变信息,为GTAW熔透状态预测提供先验知识,如图5所示.

为了提取熔池动态形变特征,建立熔池轮廓图像序列,进行加权图像融合,即

$$ R = \sum_{i = 1}^N {{w_i}} {F_i} $$ (1) 式中:$ R $为融合后图像; $ {F_i} $为待融合图像; $ {w_i} $为加权系数,文中采用3帧熔池轮廓图像融合,所以$ N = 3 $, 算法流程如下.

(1)将连续3帧熔池图像作为一个序列,通过遍历序列中图像,从序列中选取第一帧(t + 0 ms),第二帧(t + 4 ms),第三帧(t + 8 ms)图象, 3帧的熔池轮廓图分别为$ {F_1} $,$ {F_2} $和$ {F_3} $.

(2)计算相关系数,对于图像$ {F_1} $,$ {F_2} $和$ {F_3} $,相关系数可以表示为

$$ C\left({F}_{1},{F}_{2}\right) = \frac{{\displaystyle {\sum }_{m-1}{\displaystyle {\sum }_{n-1}\left({F}_{1}\left(m,n\right)-\overline{{F}_{1}}\right)\cdot \left({F}_{2}\left(m,n\right)-\overline{{F}_{2}}\right)}}}{\sqrt{{\displaystyle {\sum }_{m-1}{\displaystyle {\sum }_{n-1}{\left({F}_{1}\left(m,n\right)-\overline{{F}_{1}}\right)}^{2}\cdot {\displaystyle {\sum }_{m-1}{\displaystyle {\sum }_{n-1}{\left({F}_{2}\left(m,n\right)-\overline{{F}_{2}}\right)}^{2}}}}}}} $$ (2) 式中: $ \overline {{F_1}} $和$ \overline {{F_2}} $分别是图像$ {F_1} $和$ {F_2} $的均值;$ m $ 代表图像像素行号; $ \boldsymbol{n} $代表图像像素列号. 类似也可以计算$ C\left( {{F_1},{F_3}} \right) $,$ C\left( {{F_2},{F_3}} \right) $.

(3)计算加权系数w,由于相关系数衡量了两幅图像之间的相似度,根据相关系数的不同,每个图像的权重也不同. 这些权重表示每个源图像在融合过程中的贡献程度,为了保证融合后的图像能够正确地反映源图像的特征,需要确保计算得到的权重之和为1,即

$$\left\{\begin{gathered} {w_1} = \frac{1}{3}\left( {1 - C\left( {{F_2},{F_3}} \right)} \right) \\ {w_2} = \frac{1}{3}\left( {1 - C\left( {{F_1},{F_3}} \right)} \right) \\ {w_3} = 1 - {w_1} - {w_2} \\ \end{gathered} \right.$$ (3) (4)计算最终融合图像R,即

$$ R\left(m,n\right)\; = \;{w}_{1}\cdot {F}_{1}\left(m,n\right) \;+ \;{w}_{2}\cdot {F}_{2}\left(m,n\right) \;+\; {w}_{3}\cdot {F}_{3}\left(m,n\right) $$ (4) 为了更直观表现熔池形变特性,通过不同颜色的熔池轮廓序列表示熔池动态形变,以表现时间和空间的连续性.

2.3 构建知识增强的CNN熔透状态预测模型

通过上述语义分割和熔池轮廓融合提取熔池动态形变,通过熔池动态形变在各个局部区域表现出动态变化,因此,熔池动态形变可以为CNN模型提供先验知识. 如图6所示,将融合后的动态熔池轮廓图像和其图像序列中对应的第二帧原始熔池图像一起输入CNN模型,并通过相同感受野提取同一位置的像素变化.合成图像不仅包含比单幅图像更多的信息,而且蕴含了焊接过程中的时序信息,有效融合专家先验知识,因此该方法能更全面的预测熔透状态.

基于先验知识提取的熔池轮廓有效剔除了图像冗余信息,而且基于多帧熔池轮廓图像融合方法获得的图像能够在一定程度上反映熔池动态形变,因此,通过缩小输入图像尺寸和减小卷积核大小可以降低计算复杂度,同时避免模型过拟合. 文中建立卷积神经网络,以合成图像作为输入,输出三种熔透状态,这些模型由卷积层、池化层和全连接层组成. 所有模型的第一卷积层核大小为[7 × 7],第二层卷积层的核大小为[5 × 5],第三层和第四层为[3 × 3],卷积运算的步长是1,下采样使用最大池化方法,核大小为[2 × 2],步长为2. 特征图像每经过池化层一次,图像大小就会减少一半. 在CNN模型对图像进行处理的过程中,输入图像越大,模型学习到的图像细节越多,如果输入图像太小,模型将无法学习到足够的细节,模型可能拟合不足. 而较小的卷积核通常能够捕获更细粒度的特征,较大的卷积核可以捕获更广阔的空间信息,有助于学习到更大尺度的特征. 因此,选择适当的输入图像大小和卷积核大小可以提高模型精度,有效缩短延迟. 文中设置了4个CNN模型,用于探究输入图像大小与卷积核规模对模型性能的影响,见表2. 其中,CNN-1作为基准对照组,采用360 × 360输入尺寸和逐级递增的卷积核配置;CNN-2在保持相同卷积核规模的前提下,将输入尺寸压缩至224 × 224,全连接层对应调整为[14 × 14 × 128,3];CNN-3在CNN-2基础上将各层卷积核数量翻倍;CNN-4则进一步将输入尺寸缩减至128 × 128,全连接层结构变为[8 × 8 × 256,3].通过这四种模型可以系统验证输入图像尺寸大小与特征提取能力之间的平衡关系.

表 2 CNN架构Table 2. Architecture of the proposed CNN模型 输入大小 卷积核1 卷积核2 卷积核3 卷积核4 全连接层 CNN-1 360 × 360 16 32 64 128 [23 × 23 × 128,3] CNN-2 224 × 224 16 32 64 128 [14 × 14 × 128,3] CNN-3 224 × 224 32 64 128 256 [14 × 14 × 256,3] CNN-4 128 × 128 32 64 128 256 [8 × 8 × 256,3] 3. 试验结果与分析

3.1 熔池图像分割结果

在焊接过程中,通过视觉传感获得了5 463张熔池图像. 将512 × 512像素熔池图像裁剪为360 × 360像素,只保留熔池区域,有效地去除冗余信息并降低了计算成本. 将数据集按7∶3分成训练集和测试集,并使用标注软件Labelme对训练数据集进行标注. DeepLabv3 + 模型训练完成后,输入图像中的像素将被划分为熔池区域和背景. 为验证模型的有效性,采用联合平均交集(mean intersection over union, MIoU)和平均像素精度(mean pixel accuracy, MPA)评估语义分割模型的性能,即

$$ M_{{\mathrm{MIoU}}} = \frac{1}{{{{k + }}1}}\displaystyle\sum_{{\text{i}} = 0}^k {\frac{{{p_{ij}}}}{{\displaystyle\sum_{j = 0}^k {{p_{ij}} + \displaystyle\sum_{j = 0}^k {{p_{ji}} - {p_{ii}}} } }}} $$ (5) $$ M_{\mathrm{MPA}} = \frac{1}{{{{k + }}1}}\sum_{{{i}} = 0}^k {\frac{{{p_{ii}}}}{{\sum{j = 0}^k {{p_{ij}}} }}} $$ (6) 式中: $ k + 1 $表示目标类别;$ {p_{ij}} $表示属于类别i 但被预测为类别j 的像素的总数. 具体为$ {p_{ii}} $,$ {p_{ij}} $和$ {p_{ji}} $表示真阳性、假阳性和假阴性.

为了验证所提出DeepLabv3 + 模型优越性,对比了FCN,SegNet和U-Net三种分割网络,性能指标见表3. 由于DeepLabv3 + 以MobileNetv2网络作为主干特征提取器,训练时间比FCN,SegNet和U-net短,模型具有较高效率. 熔池区域分割平均交并比达81.2%,平均像素精度83.6%,在处理速度方面达到19帧/s,均优于其他三种网络. 将DeepLabv3 + 与其他模型熔池动态分割的结果对比,如图7 所示,DeepLabv3 + 因其引入空间金字塔结构并且缩小了空洞卷积膨胀率,可以关注到轮廓边缘细节信息,有效提高分割准确率.

表 3 不同分割网络性能对比Table 3. Quantifying the performance of different segmented networks方法 平均交并比 平均像素精度 检测速度

v/(帧·s−1)FNC 0.722 0.791 22 SegNet 0.754 0.786 25 U-Net 0.783 0.824 24 DeepLabv3 + 0.812 0.836 19 3.2 多帧熔池轮廓图像融合结果

如图8所示,对熔池轮廓图像序列进行加权平均融合,可以看出,在三种熔透状态下,熔池轮廓在时间和空间上的动态变化. 对于部分熔透状态,熔池尺寸较小且轮廓变化剧烈,对于适度熔透状态,熔池轮廓逐渐增大并且趋于稳定,整体变化不明显,对于过度熔透状态,熔池轮廓变化明显,在空间上轮廓逐渐变大,在时间上轮廓边缘变化剧烈.

通过观察融合后的熔池轮廓图像,可以发现熔池轮廓形态变化不仅具有时间连续性,还在空间的各个局部区域表现出差异性,可以有效表征动态焊接信息. 因此,设计融合后的轮廓图像序列数据集丰富了熔池图像的信息,并且在视觉上突出不同轮廓的变化,为深度学习模型提供更稳定和更丰富先验知识的输入.

3.3 基于知识增强的CNN熔透状态预测结果

为了评估模型的性能,将数据分为训练集和测试集,为了保留焊接的时序性,使用每个熔透状态下数据的前70%作为训练集,剩下的30%作为测试集,训练集和测试集的数量分别为1 274和547,见表4. 此外,采用Adam优化器降低计算成本,提高收敛速度,批次大小设置为32,学习率设置0.001,训练轮次设为10(epoch = 10). 所有训练运行在英特尔酷睿i5-11400U CPU,2.70 GHz 和16 GB RAM. 该模型在pytorch 框架下使用python 构建,并在GPU (RTX3050) 上进行训练. 采用准确率(A)、精度(P)、召回率(R)、F1 指数值(F1)4个评价指标,进一步定量评价模型在熔透状态预测中的分类性能.

表 4 数据集分布(个)Table 4. Distribution of dataset数据集 部分熔透 适度熔透 过度熔透 总计 训练集 301 623 350 1 274 测试集 129 268 150 547 总计 430 891 500 1 821 如图9所示,显示4个CNN模型的训练损失和训练准确率,随着训练开始,训练损失函数逐渐减小,利用合成图像序列数据对模型的训练精度在前4个训练轮次期间波动较大,然后缓慢稳定,在第9个轮次达到最佳值,训练准确率达到99.9%,训练损失小于0.01,此时对模型进行测试. CNN-2收敛速度最快,说明该模型学习效果最好,CNN-4收敛速度最慢,可能是由于输入图像尺寸最小,导致模型学习有效特征的速度较慢.

为了深入分析文中提出的CNN模型的性能,对训练模型的预测精度和预测时间(单个样本在CNN模型上的运行时间)进行了详细的比较. 图10为四种CNN模型的性能对比结果,模型预测时间随着模型参数和输入图像尺寸的减小而减小. 模型的单帧预测时间范围为0.72 ~ 0.97 ms,表明所构建的4个CNN模型满足实时监控的要求. 其中,CNN-2的预测准确率最高,达到97.1%;CNN-3 的预测时间最短,达到0.81 ms. 尽管CNN-3 的预测时间(0.81 ms)略快于CNN-2 的预测时间(0.86 ms),但CNN-2的预测准确率(97.1%)高于CNN-3(95.6%),考虑到应用场景对准确率要求较高,故选择CNN-2作为熔透状态预测模型.

训练完成后将测试集的合成图像按时序输入到训练好模型中(CNN-2). 为了更直观的得出焊接状态的预测结果,将熔透状态预测结果与真实标签进行对比,如图11所示,所提出的基于知识增强的CNN预测模型能够可靠地识别出三种熔透状态,预测误差主要发生在状态转换时,可以看出在部分熔透中,预测错误的样本非常少且分布分散,在过度熔透时预测误差主要集中在由适度熔透到过度熔透转变时.

3.4 不同输入图像预测结果对比

为了探索CNN熔透状态预测效果,分析了熔透预测过程.首先,对不同输入图像熔透预测结果进行分析见表5,基于多帧熔池轮廓图像融合知识增强输入下,分类准确率和F1 指标最高,分别达到97.1%和97.3%,相较于单帧原始熔池图像、多帧原始熔池图像融合和单帧熔池轮廓图像知识增强输入情况下,各项评价指标均有所提升,可见文中方法能更好预测不同熔透状态.

表 5 CNN测试结果Table 5. CNN test results输入图像 准确率

A(%)精度

P(%)召回率

R(%)F1值

F1(%)单帧原始熔池图像 83.5 81.4 83.3 83.8 多帧原始熔池图像融合 90.4 91.5 90.4 90.5 单帧熔池轮廓图像知识增强 93.2 93.4 93.2 93.2 多帧熔池轮廓图像融合知识增强 97.1 98.5 97.4 97.3 为了验证CNN在不同输入图像下熔透状态预测过程,文中采用t-SNE降维算法对最后一层测试集的特征进行可视化处理,如图12所示. 将高维特征简化为二维空间,可以更直观地了解这些特征在高维空间中是否可分,其中不同颜色的散点代表不同的熔透状态,可以清晰地观察到三种熔透状态的区别. 其中,四种不同图像输入下部分熔透状态类型很容易从散点图中区分出来. 在单帧原始熔池图像和多帧原始熔池图像融合输入下,很多适度熔透和过度熔透状态样本混合在一起,在单帧熔池轮廓图像知识增强和多帧熔池轮廓图像融合知识增强输入情况下,可以有效的辨识适度熔透和过度熔透焊接状态,其中,多帧熔池轮廓图像融合知识增强聚类中心分开更加明显,可见融合熔池动态形变时序信息和专家知识使焊接熔透状态识别准确率和泛化性得到有效提高.

![]() 图 12 不同输入下t-SNE可视化Figure 12. Visualization of t-SNE with different inputs. (a) single-frame raw molten pool image; (b) multi-frame raw molten pool image fusion; (c) knowledge enhancement for single-frame molten pool contour image; (d) knowledge enhancement for multi-frame molten pool contour image fusion

图 12 不同输入下t-SNE可视化Figure 12. Visualization of t-SNE with different inputs. (a) single-frame raw molten pool image; (b) multi-frame raw molten pool image fusion; (c) knowledge enhancement for single-frame molten pool contour image; (d) knowledge enhancement for multi-frame molten pool contour image fusion4. 结论

(1)提出一种基于知识增强深度学习的GTAW熔透状态预测方法,有效缓解了经典卷积神经网络对训练数据的高要求,在提高识别精度的同时增强了模型的可解释性.结果表明,对部分熔透、适度熔透和过度熔透三种典型焊接状态的分类准确率达97.1%,单帧预测时间0.86 ms.

(2) 提出一种基于熔池动态形变知识增强CNN的焊接熔透状态预测框架. 可视化结果表明,熔池动态形变有效为预测过程提供时序特征信息和专家先验知识.与未融合熔池动态形变特征专家知识的深度学习方法相比,有效提高了少样本数据输入下模型预测性能.

(3)结合熔池语义分割和多帧图像融合算法,能够一定程度上描述焊接过程中的熔池动态变化.

-

-

[1] Zou Y, Li J, Chen X. Seam tracking investigation via striped line laser sensor[J]. Industrial Robot:An International Journal, 2017, 44(5): 609 − 617. doi: 10.1108/IR-11-2016-0294

[2] Zou Y, Chen X, Gong G, et al. A seam tracking system based on a laser vision sensor[J]. Measurement, 2018, 127: 489 − 500. doi: 10.1016/j.measurement.2018.06.020

[3] Zou Y, Zhu M, Chen X. A Robust Detector for Automated Welding Seam Tracking System[J]. Journal of Dynamic Systems, Measurement, and Control, 2021, 143(7): 071001. doi: 10.1115/1.4049547

[4] Zou Y, Wang Y, Zhou W, et al. Real-time seam tracking control system based on line laser visions[J]. Optics & Laser Technology, 2018, 103: 182 − 192.

[5] Zou Y, Chen J, Wei X. Research on a real-time pose estimation method for a seam tracking system[J]. Optics and Lasers in Engineering, 2020, 127: 105947. doi: 10.1016/j.optlaseng.2019.105947

[6] Zhao Z, Luo J, Wang Y, et al. Additive seam tracking technology based on laser vision[J]. The International Journal of Advanced Manufacturing Technology, 2021, 116(1): 197 − 211.

[7] Xiao R, Xu Y, Hou Z, et al. An adaptive feature extraction algorithm for multiple typical seam tracking based on vision sensor in robotic arc welding[J]. Sensors and Actuators A:Physical, 2019, 297: 111533. doi: 10.1016/j.sna.2019.111533

[8] Zhang G, Yun T-J, Oh W-B, et al. A study on seam tracking in robotic GMA welding process[J]. Materials Today:Proceedings, 2020, 22: 1771 − 1777. doi: 10.1016/j.matpr.2020.03.010

[9] Xue B, Chang B, Peng G, et al. A Vision Based Detection Method for Narrow Butt Joints and a Robotic Seam Tracking System[J]. Sensors, 2019, 19(5): 1144. doi: 10.3390/s19051144

[10] Wu Q Q, Lee J P, Park M H, et al. A study on the modified Hough algorithm for image processing in weld seam tracking[J]. Journal of Mechanical Science and Technology, 2015, 29(11): 4859 − 4865. doi: 10.1007/s12206-015-1033-x

[11] Muhammad J, Altun H, Abo-Serie E. A robust butt welding seam finding technique for intelligent robotic welding system using active laser vision[J]. The International Journal of Advanced Manufacturing Technology, 2018, 94(1): 13 − 29.

[12] Fan J, Jing F, Yang L, et al. A precise seam tracking method for narrow butt seams based on structured light vision sensor[J]. Optics & Laser Technology, 2019, 109: 616 − 626.

下载:

下载: