Weld identification and robot path planning algorithm based on stereo vision and YOLO deep learning framework

-

摘要:

为了实现机器人焊接的免示教路径规划,结合深度学习与点云处理技术,开发了一种高效、稳定的焊缝智能识别算法. 首先,采用ETH(Eye-to-hand)构型的工业级3D相机获取焊件周围的二维图像和3D点云模型,利用预先训练的YOLOv8目标检测模型识别焊件所在的ROI区域(region of interest,ROI),模型识别精度为99.5%,从而实现快速剔除背景点云,并基于RANSAC平面拟合、欧式聚类等点云处理算法,对ROI区域的三维点云进行焊缝空间位置的精细识别;最后根据手眼标定结果转化为机器人用户坐标系下的焊接轨迹. 结果表明,文中所开发的算法可实现随机摆放的焊缝自动识别和焊接机器人路径规划,生成的轨迹与人工示教轨迹效果相当,偏差在0.5 mm以内.

Abstract:In order to realize the teaching-free path planning of robot welding, an efficient and stable weld intelligent identification algorithm was developed by combining deep learning and point cloud processing technology. Firstly, an industrial-grade 3D camera with an eye-to-hand identification was used to obtain the two-dimensional image and 3D point cloud model around the weldment, and the pre-trained YOLOv8 target detection model was used to identify the ROI(Region of Interest) area where the weldment is located. The model identification accuracy is 99.5%, thereby realizing the rapid removal of background point clouds. Based on point cloud processing algorithms such as RANSAC plane fitting and Euclidean clustering, the three-dimensional point cloud in the ROI area was finely identified for the spatial position of the weld seam. Finally, the trajectory was converted into welding trajectories in the robotic user coordinate system with the coordinate transformation matrix. The verification experimental results show that the algorithm developed in this paper can realize the automatic identification of randomly placed weld seams and welding robot path planning, and the generated trajectory has a similar effect to the manual teaching trajectory, with a deviation of within 0.5 mm.

-

0. 序言

相比于传统铝合金,SiC颗粒增强铝基复合材料具有耐磨性好、尺寸稳定性好、比强度高等优点,在船舶、航空航天以及汽车制造等领域有着极其广阔的应用前景[1-2]. 但是SiC颗粒的引入加大了材料的连接难度[3],SiC颗粒和铝基体的热膨胀系数存在极大的差异,因此存在一定的焊后残余应力,甚至形成微裂纹扩展源,如何有效地实现SiC/Al基复合材料的连接是当前亟需解决的问题. 搅拌摩擦焊被认为是当前铝基复合材料焊接的首要方法,Bozkurt和Uzun等人[4-5]对SiC/AA2124铝基复合材料进行搅拌摩擦焊试验,在搅拌头的作用下,焊核区的SiC颗粒被进一步破碎,焊接接头的抗拉强度最高可达原母材强度的81%. 但是搅拌摩擦焊往往受限于工件的形状尺寸,且高硬度的SiC颗粒会降低搅拌头的使用寿命,并不适用于大规模的工业生产. 从经济性和实用性角度来看,熔化焊设备简单,适用于对接焊缝、角接焊缝、环焊缝等,是最具有应用潜力的焊接手段. 因此,研究铝基复合材料熔化焊接具有一定的实际应用价值. 但是当采用熔化焊的方式焊接SiC/Al基复合材料时,熔池中SiC颗粒与液态Al会自发的发生反应生成高熔点(2 100 ℃)金属间化合物Al4C3,大幅降低焊接接头的力学性能[6-7]. 研究表明焊缝中的Al4C3多为针状或片状相,一方面降低了熔池的流动性,造成偏析、偏聚等焊接缺陷,另一方面阻碍了气泡的上浮或是为气泡提供附着面,形成气孔[8]. 此外,Al4C3具有一定的吸湿性,能与空气中的水发生反应生成Al(OH)3和甲烷,腐蚀焊缝. 文献[9-10]中提出Ti元素在高温下和C元素发生反应生成TiC,且TiC的自由能低于Al4C3,因此可通过向焊缝中添加金属元素Ti抑制界面反应的发生,反应生成的TiC颗粒可以对焊缝起到补强作用. 但是,熔池中过量的Ti元素可能会与Al元素反应生成片状的Al3Ti,反过来影响焊缝的力学性能. 为了探究焊缝中Ti元素含量对焊缝组织和焊接接头力学性能的影响,在其它工艺参数不变的条件下,分别选用0.01,0.03,0.10 mm的Ti箔作为填充材料与无填充材料的焊接接头进行对比分析.

1. 试验方法

1.1 试验材料

试验所用母材为SiCp/6092铝基复合材料,增强体SiC颗粒体积分数10 %,颗粒平均尺寸为5 μm,6092铝合金化学成分如表1所示,母材微观组织如图1所示.

1.2 试验设备

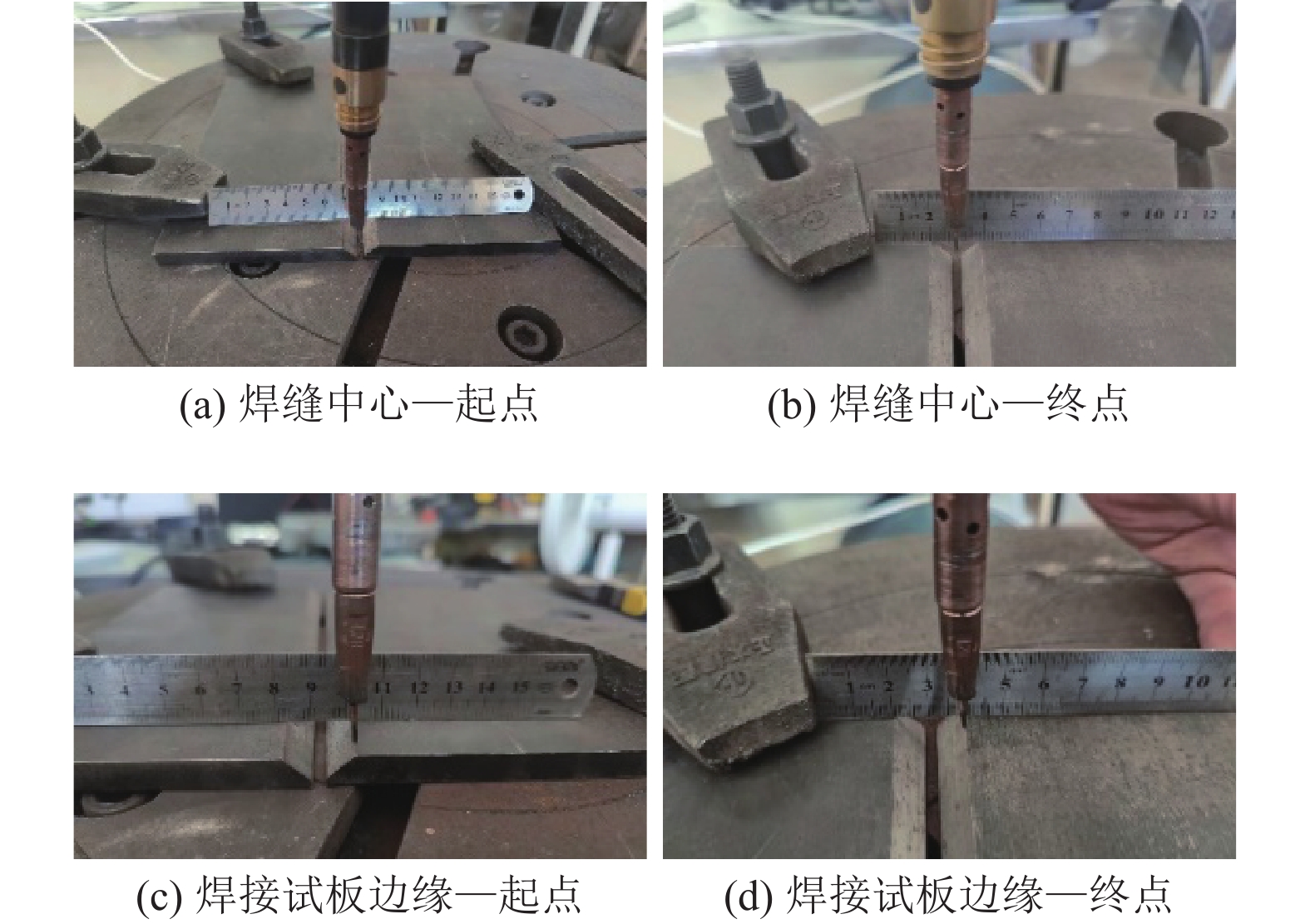

试验所使用的激光器为德国通快公司生产的TruDisk 6002型激光器,激光波长为1.03 µm,最大激光输出功率为6 kW,可输出连续波和脉冲波两种波形. 相较于CO2固体激光器,碟片式YAG固体激光器可以有效地提升Al,Cu等高反材料的激光吸收率. 试验采用连续激光进行激光焊接以便获得更好的焊缝成形效果. 焊前将原材料切成120 mm × 30 mm × 2 mm的板材,用150号砂纸仔细打磨后,丙酮清洗、烘干,并在30 min内使用. 图2为焊接过程示意图,采用激光功率为2 200 W,焊接速度为1.2 m/min. 为避免激光反射损坏光纤,激光入射角度偏离垂直方向13°.

表 1 6092铝合金化学成分(质量分数,%)Table 1. Chemical compositions of 6092 aluminum alloyMg Cu Si O Fe Ti Al 0.9 0.8 0.6 0.05 0.7 0.15 余量 1.3 测试手段

焊件沿垂直焊缝的方向切开制取金相试样,打磨、抛光后在显微镜下观察其微观组织形貌. 使用FM-ARS900全自动显微硬度计测试焊接接头硬度分布,焊缝金属的具体成分可通过配置EDS能谱仪的电子扫描显微镜观察分析. 拉伸试验在DDL100电子万能试验机进行,拉伸速度1 mm/min,拉伸试样为非标准样,具体尺寸如图3所示. 拉伸试验完成后采用FEI NovaNano450场发射扫描电镜观察断口形貌,分析拉伸试样的主要断裂机制.

2. 试验结果及分析

2.1 焊接接头宏观形貌

图4为填加不同厚度Ti箔时焊接接头横截面宏观照片. 从图4可以看出,当填加Ti箔后,焊缝区域的气孔数量明显减少. 图4a为不填加Ti箔时焊接接头的宏观形貌. 从图4a可以看出,焊缝深宽比大,焊缝区和热影响区均存在大量的孔洞,其中,焊接热影响区的孔洞尺寸可达100 μm,严重削弱了接头的力学性能. 图4b为填加了0.01 mm Ti箔时接头横截面宏观形貌. 从图4b可以看出,填加Ti箔后焊接接头的热影响区有所减小,且热影响区的孔洞分布趋于熔合线,这是因为Ti的热导率小,热量主要集中在熔合线附近. 图4c和图4d分别为填加了0.03,0.10 mm Ti箔的焊接接头横截面宏观照片. 可以看出,当Ti箔的厚度达到0.03 mm后,焊缝中心的气孔缺陷基本消失,随着Ti箔厚度进一步增加,焊缝中的Ti元素含量处于过饱和状态,熔合区出现Ti元素的局部偏聚. 此外,由于Ti箔厚度较厚,焊件的加热机制由激光直射逐渐变为热传导,熔池不再呈现规则的左右对称.

2.2 焊接接头微观组织

图5为焊接热影响区气孔微观形貌,气孔内壁光滑、洁净,无明显氧化痕迹,气孔底部为紧密排列的胞状晶端头,在对气孔内壁附着的团簇颗粒进行EDS点扫描分析,结果如表2所示,Mg元素的含量明显高于基体. 由此推测,在激光的作用下热影响区的低熔点元素(主要是Mg)存在一定程度上的熔化甚至气化,从而导致母材制造过程中残留的[H]迅速迁移至液态金属薄膜,累积、长大形成气孔.

表 2 气孔内壁附着物的化学成分(质量分数,%)Table 2. Chemical composition of attachment on pore wallAl Mg Si 余量 87.25 1.71 1.67 9.37 图6为填加不同厚度Ti箔时焊缝的金相组织及其对应的SEM照片. 从图6可以看出,随着熔池中Ti元素含量的增加,针状脆性相尺寸减小直至完全消除. 从图6a可以看出,当不填加Ti箔时,焊缝被粗大的片状相占据. 由图6d的EDS点扫描结果可知,该物相为Al4C3,图6a中的黑色块状物质与金相照片不在同一聚焦平面. 结合图6d的二次电子照片可知,黑色块状区域为气孔,气孔呈不规则的多边形,且气孔内壁粗糙不平. 根据文献[11]推测该气孔的主要形成机制是焊接工艺的不稳定性. 图6b、图6c和图6g分别为填加不同厚度Ti箔时焊缝中心的金相照片. 随着焊缝金属中Ti含量的增加,界面反应产物逐渐发生变化. 当填加0.01 mm Ti箔时,一方面Ti箔熔化带走了一部分热量,减小了焊接热输入,Al4C3尺寸随着热输入的减小而减小[12],另一方面熔池中的C元素优先和Ti元素发生反应生成细小弥散的TiC颗粒,为接下来的结晶提供异质形核点. 因此,Al4C3尺寸明显减小,焊缝中的孔洞缺陷也得到了显著地改善. 图6e表明当Ti箔的厚度为0.01 mm时,尽管焊缝中依然存在针状的Al4C3,但是局部区域出现不规则的多边形块状物质,EDS点扫描结果显示为SiC颗粒,证明Ti元素的加入对于抑制界面反应是有效的. 但是由于熔池快速凝固,Ti元素未能来得及扩散到整个熔池,造成Ti元素局部偏聚. 当填充0.03 mm Ti箔时,焊缝中的Al4C3尺寸已变得十分细小,呈短棒状弥散分布,如图6c所示. 结合图6f及表3的EDS点扫描结果可知,焊缝中生成了TiC颗粒. 在焊缝金属的结晶过程中,TiC颗粒富集在晶界表面并随着晶体的持续长大而不断推移,造成TiC颗粒偏聚. 图6h表明了当焊缝金属中的Ti含量过高时,过量的Ti元素将与铝基体反应生成片状相. 结合表3的EDS点扫描结果以及Al-Ti合金相图可知,该物相为Al3Ti[13].

![]() 图 6 不同参数下焊缝中心微观形貌Figure 6. Microstructure of weld center under different parameters. (a) metallographic of weld without Ti foil; (b) metallographic of weld filled with 0.01 mm Ti foil; (c) metallographic of weld filled with 0.03 mm Ti foil; (d) SEM of weld without Ti foil; (e) SEM of weld filled with 0.01 mm Ti foil; (f) SEM of weld filled with 0.03 mm Ti foil; (g) metallographic of weld filled with 0.10 mm Ti foil; (h) SEM of weld filled with 0.10 mm Ti foil表 3 焊缝中心各物相化学成分(原子分数,%)Table 3. Chemical compositions of each phase in weld center

图 6 不同参数下焊缝中心微观形貌Figure 6. Microstructure of weld center under different parameters. (a) metallographic of weld without Ti foil; (b) metallographic of weld filled with 0.01 mm Ti foil; (c) metallographic of weld filled with 0.03 mm Ti foil; (d) SEM of weld without Ti foil; (e) SEM of weld filled with 0.01 mm Ti foil; (f) SEM of weld filled with 0.03 mm Ti foil; (g) metallographic of weld filled with 0.10 mm Ti foil; (h) SEM of weld filled with 0.10 mm Ti foil表 3 焊缝中心各物相化学成分(原子分数,%)Table 3. Chemical compositions of each phase in weld center位置 Al Si C Ti 余量 A 69.06 5.66 25.28 — — B 3.24 68.18 23.60 1.42 3.56 C 31.19 8.62 29.70 24.20 6.29 D 56.13 1.52 — 22.38 19.97 2.3 焊缝显微硬度

图7为通过五点平均法计算出的焊缝中心显微硬度,从图7可以看出,随着焊缝中Ti元素含量的不断增加,焊缝中心的显微硬度逐渐增加. 相较于母材(124 HV),焊缝区显微硬度有明显上升,这是因为在无填充材料时焊缝中生成了Al4C3,Al4C3提高了焊缝的显微硬度. 当填加了填充材料后,虽然Al4C3逐渐消失,但是新生成的TiC颗粒又对母材起到了弥散强化的作用,焊缝硬化更为显著[14].

2.4 接头抗拉强度及失效分析

文献[15]指出Al4C3的存在严重影响焊接接头的力学性能,因此随着焊缝中Al4C3尺寸和数量的减少,焊接接头力学性能理应得到优化. 图8为填加不同厚度Ti箔时焊接接头的抗拉强度. 从图8可以看出,在一定范围内焊接接头的抗拉强度随着填充Ti箔厚度的增加而增加,验证了Al4C3对焊接接头力学性能的不利影响. 图9为不填加Ti箔和填加0.10 mm Ti箔的焊接接头拉伸断口形貌. 不填加Ti箔时焊接接头的抗拉强度仅为58 MPa,断裂位置位于焊缝,断口平整. 断口微观形貌及其局部放大图如图9a所示,解理初裂纹在扩展到晶界后受到阻碍,在晶界附近造成应力集中,使得相邻晶粒内与初裂纹所在晶面相交的解理面上形成新的裂纹源,即河流花纹形貌. 填加0.10 mm Ti箔时焊接接头的抗拉强度可达206 MPa,约为母材的45 %,断裂位置部分位于熔合线处,部分位于焊缝. 接头断裂的主要原因是熔合线上的气孔提供了微裂纹扩展源,焊接接头承受单向静载拉力时,气孔处最先断开,形成裂纹并迅速扩展至较脆的焊缝,产生断裂.

3. 结论

(1)对于含有低熔点元素的铝基复合材料来说,激光焊的热输入需要得到严格的控制,否则将在热影响区形成大量肉眼可见的孔洞,形成裂纹扩展源,削弱焊接接头的力学性能.

(2) Ti箔的加入,可以有效改善熔池的流动性,减少焊缝内部以及热影响区的气孔,增大焊接接头有效承载面积,从而提高接头的抗拉强度. 当填加厚度为0.10 mm Ti箔时,焊接接头的抗拉强度最高可达206 MPa. 此外,由于焊缝中新生成TiC以及Al3Ti等物相,焊缝金属的显微硬度大幅提升,并延长了焊接接头的使用寿命.

(3)通过向焊缝中填加Ti箔,可以有效抑制SiCp/6092铝基复合材料激光焊时焊缝中出现的Al4C3脆性相,但是过量的Ti元素会与铝基体继续反应生成片状的Al3Ti,过分长大的Al3Ti对焊接接头性能不利.

-

-

[1] 吴明晖, 黄海军, 王先伟, 等. 基于改进蚁群算法的机器人焊接路径规划[J]. 焊接学报, 2018, 39(10): 113 − 118. Wu Minghui, Huang Haijun, Wang Xianwei, et al. Robot welding path planning based on improved ant colony algorithm[J]. Transactions of the China Welding Institution, 2018, 39(10): 113 − 118.

[2] 王斐, 梁宸, 韩晓光, 等. 基于焊件识别与位姿估计的焊接机器人视觉引导[J]. 控制与决策, 2020, 35(8): 1873 − 1878. Wang Fei, Liang Chen, Han Xiaoguang, et al. Visual guidance of welding robot based on weldment recognition and pose estimation[J]. Control and Decision, 2020, 35(8): 1873 − 1878.

[3] 王浩, 赵小辉, 徐龙哲, 等. 结构光视觉辅助焊接的轨迹识别与控制技术[J]. 焊接学报, 2023, 44(6): 50 − 57. doi: 10.12073/j.hjxb.20220715002 Wang Hao, Zhao Xiaohui, Xu Longzhe, et al. Research on trajectory recognition and control technology of structured light vision-assisted welding[J]. Transactions of the China Welding Institution, 2023, 44(6): 50 − 57. doi: 10.12073/j.hjxb.20220715002

[4] Zhou Peng, Peng Rui, Xu M, et al. Path planning with automatic seam extraction over point cloud models for robotic arc welding[J]. IEEE Robotics and Automation Letters, 2021, 6(3): 5002 − 5009. doi: 10.1109/LRA.2021.3070828

[5] 陈思豪, 余震, 王中任, 等. 基于结构光三维视觉角焊缝定位系统的研究[J]. 激光与红外, 2019, 49(3): 303 − 308. Chen Sihao, Yu Zhen, Wang Zhongren, et al. Research on three-dimensional visual fillet weld positioning system based on structured light[J]. Laser & Infrared, 2019, 49(3): 303 − 308.

[6] 方纬华. 基于3D视觉的机器人焊接智能轨迹规划关键技术研究[D]. 济南: 山东大学, 2023. Fang Weihua. Research on key technologies of intelligent trajectory planning for robot welding based on 3D vision[D]. Jinan: Shandong University, 2023.

[7] Zou Yanbiao, Zhan Runqin. Research on 3D curved weld seam trajectory position and orientation detection method[J]. Optics and Lasers in Engineering, 2023, 162: 107435. doi: 10.1016/j.optlaseng.2022.107435

[8] Zhang Yuankai, Geng Yusen, Tian Xincheng, et al. Feature extraction and robot path planning method in 3D vision-guided welding for multi-blade wheel structures[J]. Optics and Lasers in Engineering, 2024, 176: 108066. doi: 10.1016/j.optlaseng.2024.108066

[9] Geng Yusen, Zhang Yuankai, Tian Xincheng, et al. A novel 3D vision-based robotic welding path extraction method for complex intersection curves[J]. Robotics and Computer-Integrated Manufacturing, 2024, 87: 102702. doi: 10.1016/j.rcim.2023.102702

[10] Ma Yunkai, Fan Junfeng, Yang Huizhen, et al. An efficient and robust complex weld seam feature point extraction method for seam tracking and posture adjustment[J]. IEEE Transactions on Industrial Informatics, 2023, 19(11): 10704 − 10715.

-

期刊类型引用(2)

1. 郭顺,王朋坤,顾介仁,彭勇,徐俊强,周琦. 电弧熔炼Ti6Al4V/B_4C复合材料微观组织与力学性能. 机械制造文摘(焊接分册). 2023(06): 19-26 .  百度学术

百度学术

2. 郭顺,王朋坤,顾介仁,彭勇,徐俊强,周琦. 电弧熔炼Ti6Al4V/B_4C复合材料微观组织与力学性能. 焊接学报. 2022(09): 62-68+117 .  本站查看

本站查看

其他类型引用(3)

下载:

下载: