Defect identification algorithm for weld X-ray imagesbased on the CCBFE-RCNN model

-

摘要:

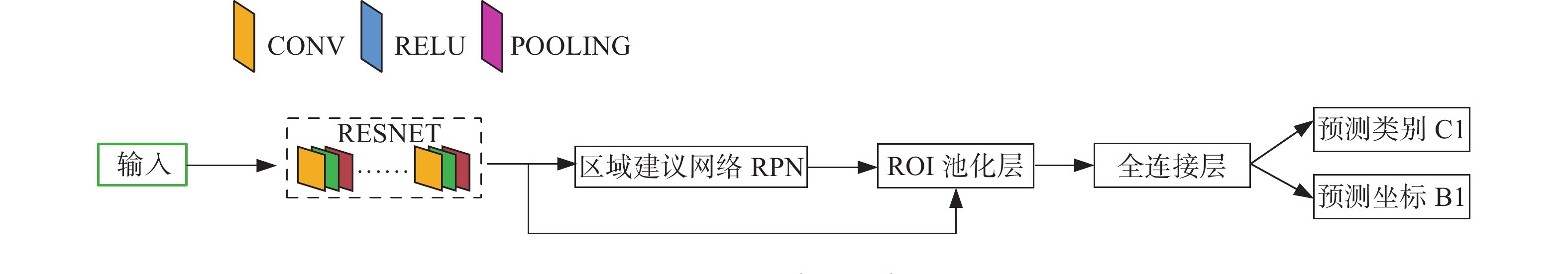

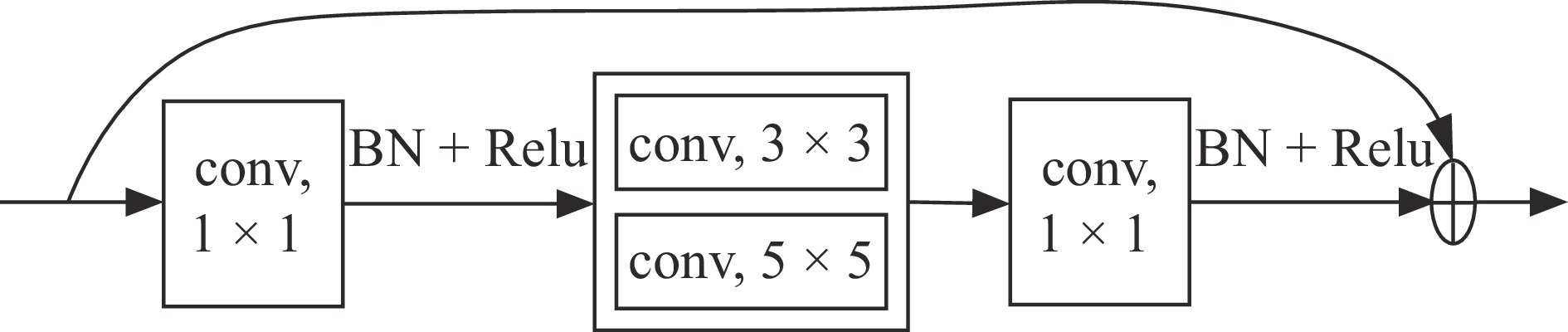

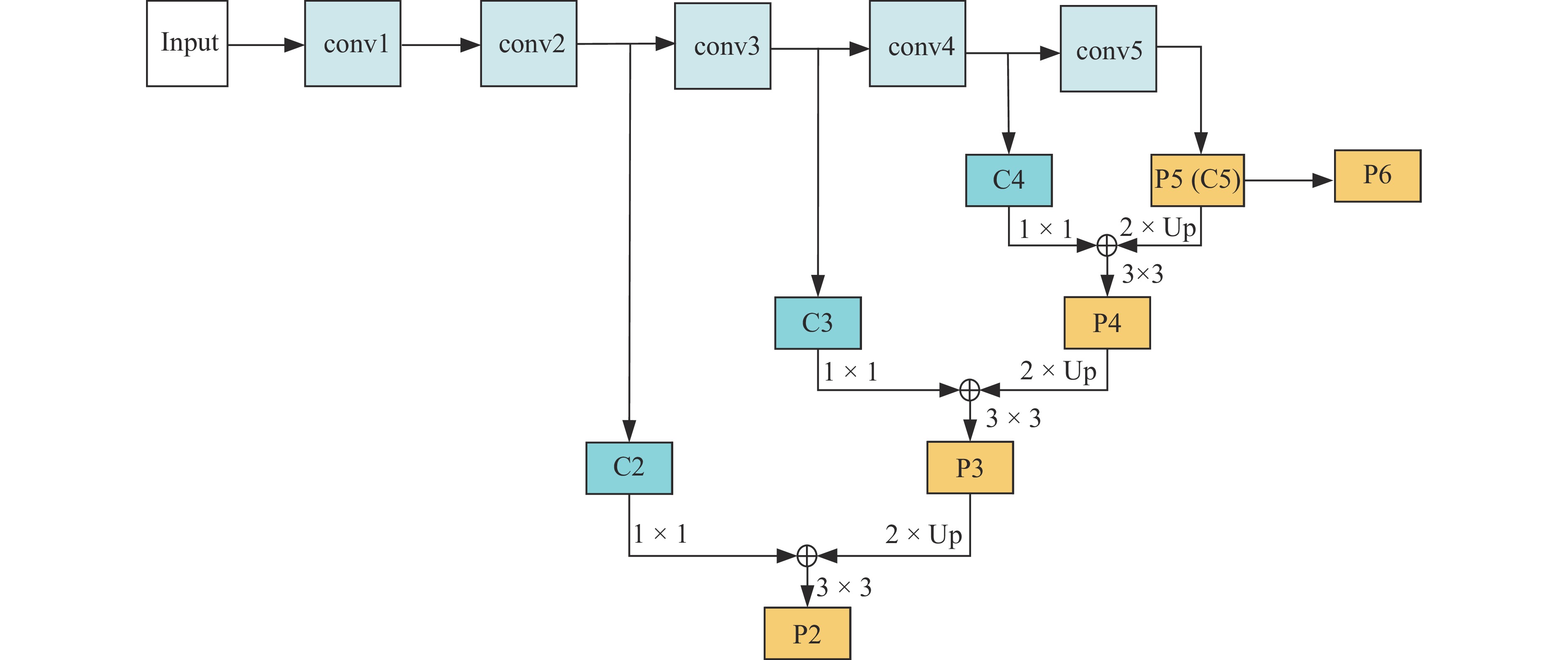

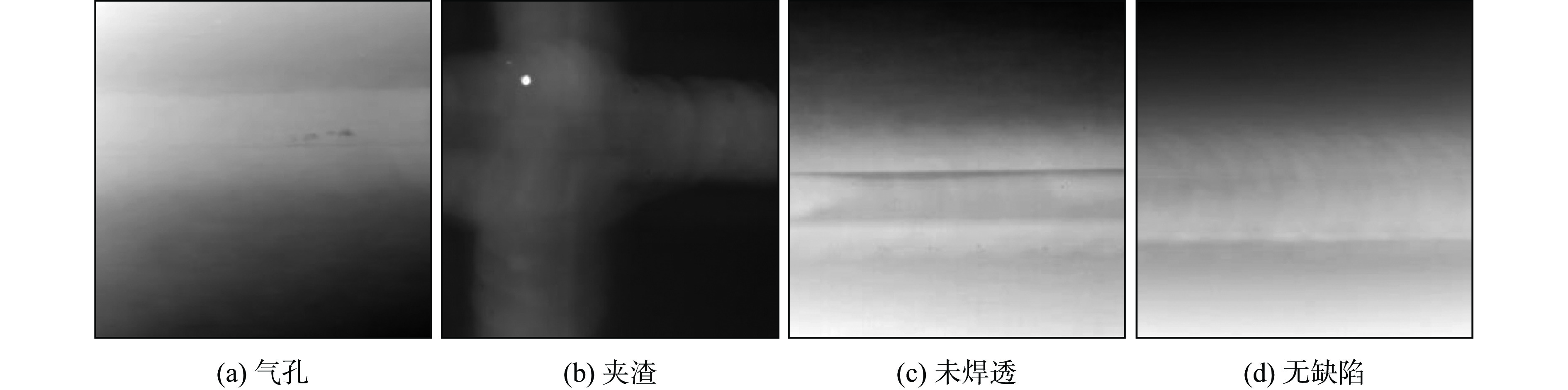

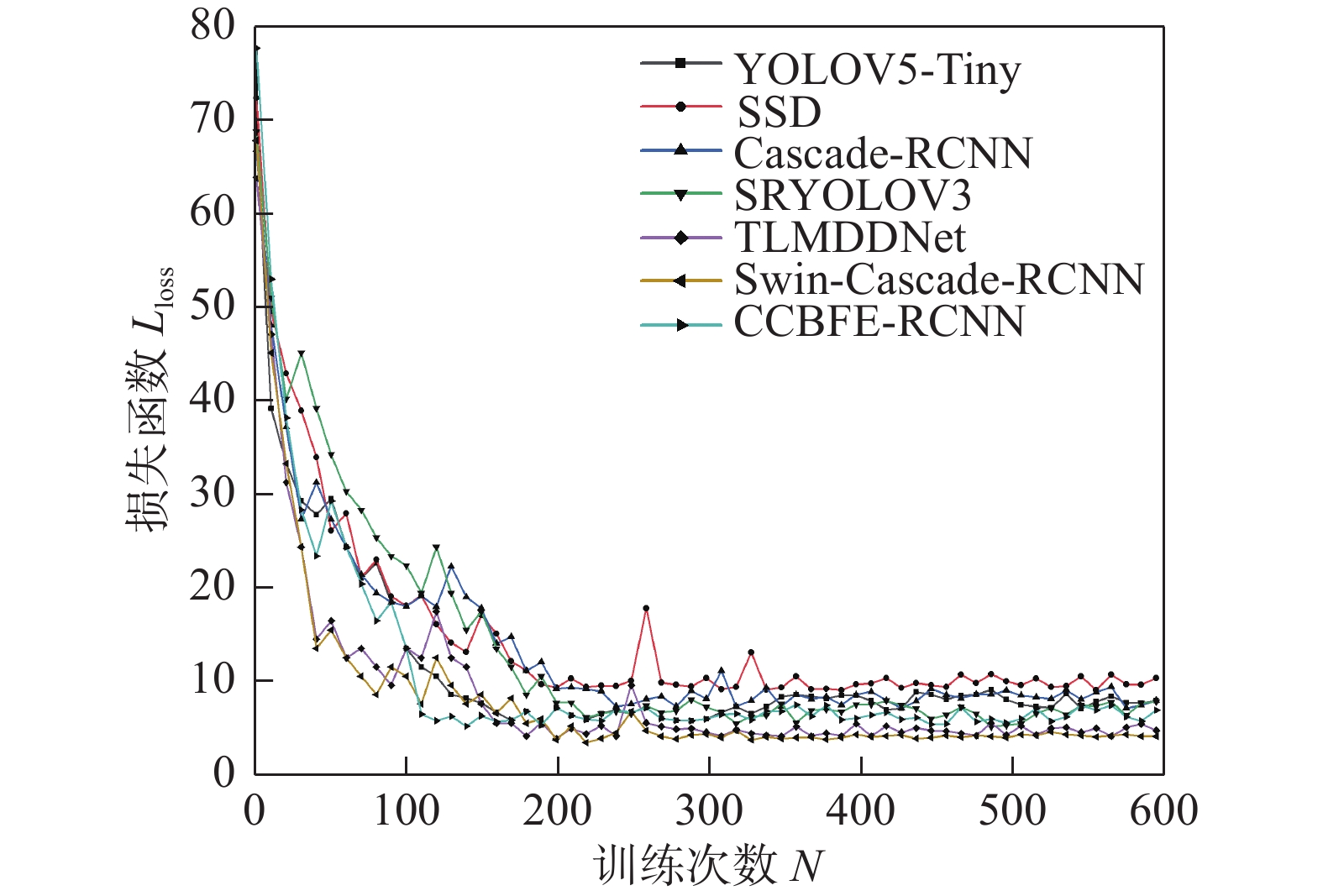

针对X射线图像人工评定过程中存在劳动强度大、检测效率低等问题,提出一种基于Cascade-RCNN网络改进的多尺度目标检测网络CCBFE-RCNN模型,采用合并卷积层结构和FPN特征金字塔网络提升模型特征提取的尺度范围,增强了模型对于多尺度特征的提取能力;使用BFE特征批量消除网络,随机消除特征图区域,避免多次训练过程中的过拟合问题并强化了特征区域表达,同时对损失函数进行改进,对模型没有准确识别出含缺陷图像加大惩罚. 通过构建并扩充熔焊焊缝X射线图像数据集,对模型进行测试. 结果表明,CCBFE-RCNN缺陷检测模型全类别召回率均值、全类别精确率均值为93.09%和91.92%,与Cascade-RCNN网络模型相比平均召回率提升5.16%,平均精确率提升5.27%. 并使用工业缺陷检测数据集对CCBFE-RCNN模型进行测试,验证了模型的泛化能力,可为焊缝缺陷智能化识别提供算法支撑.

Abstract:In view of the problems of high labor intensity and low detection efficiency in the manual evaluation process of X-ray images, a multi-scale object detection network CCBFE-RCNN model based on the improved Cascade-RCNN network is proposed. The combined convolutional layer structure and FPN feature pyramid network are used to enhance the scale range of model feature extraction, and the model's ability to extract multi-scale features is enhanced; Use BFE features to batch eliminate networks, randomly eliminate feature map regions, avoid overfitting problems during multiple training processes, and enhance feature region expression. At the same time, improve the loss function to increase penalties for models that do not accurately identify images containing defects. The model was tested by constructing and expanding a dataset of X-ray images of fusion welds The results show that the CCBFE-RCNN defect detection model has an average recall rate of 93.09% and an average precision rate of 91.92% across all categories, which is 5.16% higher than the average recall rate and 5.27% higher than the average precision rate of the Cascade-RCNN network model. The CCBFE-RCNN model is tested using an industrial defect detection dataset to verify its generalization ability, which can provide algorithm support for intelligent recognition of weld defects.

-

Keywords:

- defect identification /

- concatnated convolution /

- loss function /

- recall /

- precision

-

0. 序言

奥氏体不锈钢在低温环境中具有优异的强度与韧性组合,使其成为低温工况常用的结构材料之一,目前已用于液氢储运容器结构材料以及国际热核反应试验堆等低温设施[1-3]. 但奥氏体不锈钢焊接接头力学性能通常略逊于母材,尤其冲击韧性随温度降低下降较大,因此,低温冲击韧性成为奥氏体不锈钢焊接接头能否安全应用的关键性能之一.

奥氏体不锈钢在焊接以及后续热处理过程中,焊缝金属易形成σ相、χ相、laves相以及碳化物、氮化物等硬脆的析出相和金属间化合物,造成焊接接头低温韧性急剧降低,严重影响低温结构的安全性[4-8]. 以往对焊缝金属中析出物的研究多集中于热处理过程中的析出行为以及对力学性能的影响,而缺乏用于低温工况的焊态焊缝金属中析出物对焊接接头韧性降低作用的研究[9-11]. 焊接接头组织和性能取决于熔焊过程焊缝金属的化学成分和凝固速度,因此,通过合理调整焊材成分可减轻或避免析出物对性能的不利影响.

在对所研制低温奥氏体不锈钢焊条的性能试验中,焊态焊缝金属性能出现了急剧降低现象,此现象将严重影响低温焊接结构的安全服役. 因此使用可获得成分及组织相似的焊条,并采用SMAW方法获得焊缝金属,进而进行对比研究焊态焊缝金属性能变化. 通过光学显微镜(optical microscope,OM)、扫描电子显微镜(scanning electron microscope,SEM)和电子背散射衍射(electron back scatter diffraction,EBSD)等方法分析了焊缝金属微观组织和析出物特征. 同时对焊缝金属的力学性能进行了系统的研究,并探讨了其显微组织对断裂行为的影响.

1. 试验方法

试验采用直径4.0 mmE316LMn-15焊条进行施焊,焊条采用同种焊芯,仅焊条药皮成分存在微小差异. 母材和垫板采用Q235,并在焊前使用同类型焊条堆焊过渡层以抑制元素扩散和焊缝开裂,母材尺寸为300 mm × 300 mm × 20 mm,对接焊缝坡口配置,如图1所示. 制备的焊条在经过350 ℃/1 h烘干后进行施焊,采用低热输入以避免奥氏体不锈钢焊缝过热而可能发生的裂纹等缺陷,并严格控制道间温度在100 ℃以下,详细焊接参数见表1. 试验所得4组焊缝金属化学成分见表2,其中S1和S4的Mo含量较低,而S2和S3的Mo含量高达3.5%.

表 1 焊接工艺参数Table 1. Welding process paraments电流类型 焊接电流

I / A电弧电压

U / V焊接速度

v /(mm·min−1)道间温度

T /℃DCEP 140~150 24~30 ≥150 ≤100 表 2 焊缝金属化学成分(质量分数,%)Table 2. Chemical compositions of weld metals编号 C Si Mn S P Cr Ni Mo Fe S1 0.030 0.55 6.20 0.0088 0.018 18.60 14.51 2.87 余量 S2 0.033 0.64 6.60 0.0069 0.012 19.02 14.60 3.44 余量 S3 0.039 0.63 5.98 0.0063 0.012 18.99 15.23 3.57 余量 S4 0.031 0.46 5.98 0.0041 0.015 19.41 15.34 2.16 余量 拉伸试样在焊缝中心平行于焊接方向制取,平行段长度60 mm,直径 10 mm,试验按照国家标准GB/T 228.1—2021《金属材料 拉伸试验第1部分:室温试验方法》使用WAW-300微机控制电液伺服万能试验机在室温下进行,位移控制为0.036 mm/s. 冲击试样沿焊接接头横截面切割,试样尺寸为55 mm × 10 mm × 10 mm,V形缺口加工在焊缝金属中心,冲击试样取样,如图2所示. 根据国家标准GB/T 229—2020《金属材料 夏比摆锤冲击试验方法》要求,试样在液氮中充分冷却至−196 ℃后,在5 s内转移至PTM2302摆锤式冲击试验机上并完成冲击试验,对每个焊缝金属进行3次夏比冲击试验.

焊缝金属中铁素体含量使用FICHER FMP30铁素体仪进行检测,金相试样自焊缝金属横截面进行切割,经机械研磨和抛光后,在10%铬酸溶液中进行电化学腐蚀并采用OLYMPUS GX53光学显微镜、ZEISS EVO18扫描电子显微镜对焊缝金属微观组织和冲击断面微观形貌进行观察,并通过EBSD进一步研究了焊缝金属及断面附近组织,EBSD断面试样垂直于冲击试验断后试样中心取样,采集步长为0.16 μm.

2. 试验结果与分析

2.1 焊缝金属室温拉伸及低温冲击性能

S1 ~ S4焊缝金属室温拉伸试验结果和−196 ℃平均冲击吸收能量,如图3所示. 室温拉伸试验中S1 ~ S4焊缝金属强度与塑性均良好,但S2和S3抗拉强度和屈服强度明显高于S1和S4,其中S2和S4屈服强度相差95 MPa,抗拉强度相差达120 MPa,而S2和S3抗拉强度和屈服强度仅分别相差25 MPa和30 MPa. 性能差异同样也表现在−196 ℃冲击试验结果中,S1和S4低温平均冲击吸收能量分别为51 J和51.33 J,S2和S3平均冲击吸收能量降低超85%,平均值均降至6.33 J. 强度的升高以及低温韧性下降可能是焊接过程中析出物的出现所导致的性能变化[12-13].

2.2 焊缝金属微观组织

奥氏体不锈钢焊缝金属组织一般由γ-奥氏体和一定量δ-铁素体组成,但δ-铁素体在−100 ℃以上就已发生韧—脆转变,造成焊接接头低温韧性劣化,因此,少量或不含δ-铁素体的焊接接头的低温韧性较好. E316LMn-15焊条可获得低铁素体的高韧性焊缝金属,铁素体仪测量S1 ~ S4中铁素体含量分别为0.6,0.9,0、0.4和S1 ~ S4典型光学显微组织,如图4所示,虽然S3试样中未检测出铁素体,但在图4(c)中仍观察到枝晶间δ-铁素体. S1 ~ S4凝固行为均符合奥氏体—铁素体(AF)凝固模式,在凝固过程中首先形成γ-奥氏体,而富含δ-铁素体形成元素的剩余液相在枝晶间形成δ-铁素体,显微组织由γ-奥氏体枝晶以及随机分布于枝晶间的δ-铁素体组成. 此外,在图4(b)和图4(c)中可明显观察到γ-奥氏体枝晶间和晶界处(见椭圆标记处)存在区别于δ-铁素体的连续条状或岛状金属间化合物,且图4(c)中金属间化合物分布密度小于图4(b).

为进一步观察焊缝金属中金属间化合物,对S2和S3进行SEM表征,如图5所示,图5(a)、图5(b)为S2中条状金属间化合物在枝晶间区域的分布和形貌. 图5(c)和图5(d)为S3金属间化合物形貌,枝晶间金属间化合物呈现片层状结构. 图5(b)、图5(d)中标记点的EDS分析结果见表3,与奥氏体基体相比,金属间化合物存在高Cr、高Mo而Ni含量较低区域,根据其成分及形貌推断枝晶间存在多种结构的混合相,包括σ相和δ-铁素体.

表 3 图5中标记点EDS分析结果(质量分数,%)Table 3. EDS analyses of the points marked in Fig. 5标记点 C Si Cr Mn Fe Ni Mo A 1.32 0.72 23.60 7.54 49.34 11.42 6.06 B 1.53 0.69 26.24 6.60 47.97 9.00 7.97 2.3 S2和S3断面形貌

S2和S3低温冲击断面形貌与冲击韧性变化具有极强相关性,如图6所示,图6(a)和图6(d)中宏观断面平直明亮且几乎无变形,表明S2和S3焊缝金属脆性断裂特征. 在较高应变速率的冲击载荷作用下,相较于韧性γ-奥氏体,由于枝晶间析出相的出现,脆硬的析出相与基体界面更容易产生裂纹,冲击试样微观断面图6(b)、图6(e)均呈现枝晶间脆性断裂特征,断面沿析出相发生,表明枝晶间区域是冲击载荷作用下的薄弱部位,可以推断枝晶间析出的σ相是裂纹源. 对断面进一步放大可更加清晰地发现图6(c)、图6(f)中断面底部分布着大量微裂纹,枝晶间区域的σ相与基体界面成为裂纹形核与扩展的场所,最终在冲击载荷下发生脆性断裂.

2.4 σ相析出机理分析

奥氏体不锈钢焊缝金属AF凝固模式以γ-奥氏体作为初生相,凝固顺序为:L→L + γ→L + γ + δ→γ + δ. 凝固组织为γ-奥氏体基体以及随机分布在枝晶间不同数量δ-铁素体. S1和S4组织完全符合这种凝固模式,而S2和S3组织中存在的析出相说明σ相形成还存在其他原因.

使用JMatPro计算了S2和S3在100 ℃/s冷却速率下的凝固路径,如图7所示. S2和S3中先凝固相γ-奥氏体的凝固温度分别为

1386.1 ℃和1388.63 ℃,接着分别在1274.2 ℃和1277.83 ℃通过共晶反应形成σ相,最终形成γ-奥氏体及σ相组织,S2和S3的计算凝固路径可归结为:L→L + γ→L + γ + σ→γ + σ,但在γ-奥氏体形成之后的冷却过程中,组织中并无δ-铁素体形成,计算结果与金相组织观察不符,说明在S2和S3凝固过程中σ相存在其他形成机制.σ相在奥氏体不锈钢凝固过程中形成方式有两种:第一种是在凝固后期,由于Mo在液相中的高度偏析,通过共晶反应形成;另一种是在δ-铁素体共析分解过程中通过固态相变形成[14]. 奥氏体不锈钢焊缝金属凝固过程液相中溶质偏析非常严重,S2和S3中Mo含量较高,而Mo在凝固过程中的再分配已被证明是这类材料性能和微观组织变化的主要原因[15-16]. 初生γ-奥氏体中Mo的偏析会导致枝晶核处Mo的贫化以及枝晶间的富集,较高浓度的Mo会在凝固结束时促进富Mo金属间化合物σ相的形成从而降低力学性能,并通过延长凝固温度范围来促进热裂. 区别于共晶反应以及时效过程中在奥氏体中直接析出的σ相,图8中枝晶间存在多种相混合结构,包括σ相、δ相以及未识别的白色区域,σ相与部分未分解的δ-铁素体,证实了S2和S3中σ相是由δ-铁素体在焊接过程中通过共析分解而形成的. 这一结果与MARIN等人[14]通过定向凝固试验证实的δ-铁素体在

1210 ℃共析分解为σ相和γ′相一致.焊接过程中,强铁素体形成元素可导致δ-铁素体快速形成,这意味着当Si,Cr,Mo在δ-铁素体中有效扩散时,可以加速δ-铁素体向σ相共析分解的发生. 在LEE等人[17]的研究中Si的添加显著增加了焊缝中σ相的体积分数和平均尺寸,而在此4组焊态焊缝金属成分中Si含量变化较小,Mo含量的增加成为σ相共析形成的主要原因. 同样的现象也出现在PERRICONE等人[18]的研究中,超过2.5%的Mo含量以A和AF模式凝固的焊缝金属枝晶间出现了σ相. 凝固过程中,σ相形成元素Mo在AF模式凝固的焊缝金属中随凝固过程的进行产生强烈偏析,γ-奥氏体形成后,由于δ-铁素体中Mo的溶解度更高,并且具有较高的扩散率,枝晶间富Mo液相凝固成为亚稳δ-铁素体,在较低的温度下共析分解为σ相以及具有与初生γ-奥氏体相不同成分的二次γ′相:δ→γ′ + σ. δ-铁素体的分解取决于其成分和冷却速率,低的冷却速率有利于γ′/σ共析结构的形核和生长,焊接厚板时,焊接热循环同样会促进高Mo亚稳δ-铁素体分解,而诸如激光焊接等高冷却速率的焊接工艺在一定程度上可以避免共析分解的发生,导致亚稳δ-铁素体相冷却后的保留[18]. 亚稳δ-铁素体共析分解的早期阶段σ相一般沿着γ/δ界面形成,导致δ-铁素体中Mo在边界处局部损耗,这促进了γ′的形核,然后σ相以某种形式与γ′相耦合生长[19]. 而δ-铁素体不完全固态转变结构在枝晶间仍然保留,这使得S2和S3的凝固顺序表现为包含共析分解的凝固模式:L→L + γ→L + γ + δ→γ + δ→γ + δ + σ + γ′. 相较于图4(b)和图4(c)展示存在于枝晶间的多种相混合结构,具有较低Mo含量的S1和S4,在焊接过程中并未发生δ-铁素体向σ和γ′相的共析转变,微观组织仅显示γ-奥氏体和极少量δ-铁素体,从而表现出较高的低温冲击韧性.

2.5 S2和S3焊缝金属断裂机理

研究冲击过程中σ相析出对焊缝金属断裂过程的影响,对断裂试样靠近断面的纵向进行切割并通过EBSD进行观察,如图9所示. 根据IPF图显示,试样存在大量孔洞多集中在枝晶间和晶界,相图中显示混合相与基体间的界面几乎全部发生断裂,孔洞周围仍保留的一定数量碎裂的δ-铁素体也证实了冲击试验前σ相的存在以及σ相在断裂过程中的作用. 图9(c)和图9(f)的KAM图被用于分析表征冲击断面附近的位错密度变化以及应变分布,S2和S3中位错高度集中于枝晶间混合相引起的裂纹和孔洞上且周边沿线的位错密度较高,而γ-奥氏体内的塑性应变较小. 焊缝金属本就存在的δ-铁素体以及通过共析分解形成的σ相,在低温冲击载荷下,脆硬的σ相以及δ-铁素体相使得局部应力更容易集中于混合相所在的位置,σ相导致不同界面位错缠结并阻碍位错运动,导致界面剥落和开裂,σ相周围出现裂纹,最终导致韧性的急剧降低,出现脆性断裂的结果.

裂纹的扩展与裂纹尖端的塑性应变有关. 在冲击载荷作用下,σ相的钉扎作用导致位错缠结和裂纹萌生,裂纹首先在σ相晶粒内形核. σ相在冲击过程中碎裂以及与δ-铁素体界面形成裂纹,为裂纹的扩展提供了优先位置,裂纹产生后向γ-奥氏体扩展,被γ-奥氏体阻断或被转至σ相边界,由于广泛分布的析出相位点使得裂纹扩展较短,微裂纹容易连接而导致断裂. 在此过程中,基体的塑性变形能力下降,导致冲击韧性急剧下降,最终表现为S2和S3光亮平直的宏观冲击断面形貌.

S2和S3中的σ相由δ-铁素体共析分解形成,σ相数量与δ-铁素体计算值相关. 而S3的Creq/Nieq大于S2,可以认为S3中σ相含量相较S2少,图9(b)和图9(e)中孔洞的密度也证实了S3中σ相较小的含量,而S2和S3平均冲击吸收能量均为6.33 J,这一结果说明即使焊缝金属中σ相的含量少,仍然会对低温冲击韧性造成极大破坏. 虽然在−196 ℃下,δ-铁素体已发生了韧—脆转变,但从S1和S4超过50 J的平均冲击吸收能量来看,以AF模式凝固的焊缝金属中少量的铁素体相并未对冲击韧性造成过大的降低作用,其韧性仍保持在较高的水平.

3. 结论

(1) 以AF模式凝固的高Mo含量焊缝金属,Mo元素在凝固后期易富集于枝晶间而形成亚稳δ-铁素体,在低速率冷却过程中发生共析分解而形成σ相和γ′相,并与未分解的δ-铁素体在枝晶间组成混合相.

(2) 枝晶间δ-铁素体共析分解形成的σ相在低温冲击载荷作用下碎裂,σ相枝晶间较高的分布密度削弱奥氏体基体协调变形能力,裂纹容易连接,从而造成焊缝金属低温冲击韧性急剧降低,与仅含有δ-铁素体未发生共析分解的试样对比,σ相造成焊缝金属低温冲击韧性下降超85%.

(3) 低Mo含量含少量铁素体组织在−196 ℃下仍能保持较高冲击韧性,通过降低焊缝金属中的Mo含量以避免枝晶间δ-铁素体共析分解形成σ相,可提高焊缝金属的低温韧性.

-

表 1 Resnet101网络

Table 1 Resnet101 network

卷积层 Resnet101 conv1 conv,7 × 7,64,stride 2

max pool,3 × 3, stride 2conv2 $ \left[ {\begin{array}{*{20}{l}} {{\text{conv}},1 \times 1,64} \\ {{\text{conv}},3 \times 3,64} \\ {{\text{conv}},1 \times 1,256} \end{array}} \right] \times 3 $ conv3 $ \left[ {\begin{array}{*{20}{l}} {{\text{conv}},1 \times 1,128} \\ {{\text{conv}},3 \times 3,128} \\ {{\text{conv}},1 \times 1,512} \end{array}} \right] \times 4 $ conv4 $ \left[ {\begin{array}{*{20}{l}} {{\text{conv}},1 \times 1,256} \\ {{\text{conv}},3 \times 3,256} \\ {{\text{conv}},1 \times 1,1024} \end{array}} \right] \times 23 $ conv5 $ \left[ {\begin{array}{*{20}{l}} {{\text{conv}},1 \times 1,512} \\ {{\text{conv}},3 \times 3,512} \\ {{\text{conv}},1 \times 1,2048} \end{array}} \right] \times 3 $ 表 2 指标计算公式

Table 2 Calculation formula

评价指标 公式 召回率R $ \dfrac{{TP}}{{TP + FN}} $ 精确率P $ \dfrac{{TP}}{{TP + FP}} $ 全类别召回率均值RmAR@0.5 $\dfrac{ {\displaystyle\sum\limits_{j = 1}^c {\sum\limits_{i = 1}^x {R_i} } } }{ {cx} }$ 全类别精确率均值PmAP@0.5 $\dfrac{ {\displaystyle\sum\limits_{j = 1}^c {\displaystyle\sum\limits_{i = 1}^x {P_i} } } }{ {cx} }$ 表 3 不同模型测试结果

Table 3 Results of different models

模型 夹渣 未焊透 气孔 全类别召回率

均值

RmAR@0.5(%)全类别精确率

均值

PmAP@0.5(%)频率

f/(帧·s−1)召回率R(%) 精确率P(%) 召回率R(%) 精确率P(%) 召回率R(%) 精确率P(%) YOLOV5-Tiny 90.23 89.60 83.68 88.71 89.65 86.32 87.85 88.21 61 SSD 85.98 86.33 80.24 85.13 85.07 86.68 83.76 86.05 56 Cascade-RCNN 89.20 87.11 85.26 87.92 89.33 84.92 87.93 86.65 27 SRYOLOV3 88.27 86.99 84.47 87.82 88.67 86.81 87.14 87.21 51 TLMDDNet 92.13 90.45 88.11 90.18 92.67 90.73 90.97 90.45 19 Swin-Cascade-RCNN 93.15 88.42 86.79 88.48 90.26 88.98 90.07 88.99 29 CCBFE-RCNN 93.69 90.63 90.40 93.01 95.20 92.13 93.09 91.92 22 表 4 不同数据集测试结果

Table 4 Test results for different datasets

数据集 全类别召回率均值

RmAR@0.5(%)全类别精确率均值

PmAP@0.5(%)DAGM 92.56 91.84 NEU 95.68 93.58 AITEX 89.34 87.59 -

[1] Li Y W. Research progress of aluminum alloy welding technology[J]. The International Journal of Advanced Manufacturing Technology, 2020, 109(1): 1207 − 1218.

[2] Chen S B. On intelligentized welding manufacturing. In: Robotic welding[C]//Intelligence and Automation: RWIA’2014. Springer International Publishing, 2015: 3 − 34.

[3] Ahmed, Mohamed M Z. Friction stir welding of aluminum in the aerospace industry: the current progress and state-of-the-art review[J]. Materials, 2023, 16(8): 2971. doi: 10.3390/ma16082971

[4] Mohandas T. Welding technologies in aerospace applications[J]. Aerospace Materials and Material Technologies, 2017, 2(1): 65 − 83.

[5] Wang G, Liao T W. Automatic identification of different types of welding defects in radiographic images[J]. Ndt & E International, 2002, 35(8): 519 − 528.

[6] Madhvacharyula, Anirudh Sampath, Pavan, et al. In situ detection of welding defects: a review[J]. Welding in the World, 2022, 66(4): 611 − 628. doi: 10.1007/s40194-021-01229-6

[7] Andrew G, Vignesh S, Sooyoung L, et al. Applications of deep learning for fault detection in industrial cold forging[J]. International Journal of Production Reseach, 2021, 59(16): 4826 − 4835.

[8] Lenka L, Jan S, Renata W. The learning path to neural network industrial application in distributed envisonment[J]. Processes, 2021, 9(12): 2247. doi: 10.3390/pr9122247

[9] Dutta, Sourav. An overview on the evolution and adoption of deep learning applications used in the industry[J]. Wiley Interdisciplinary Reviews:Data Mining and Knowledge Discovery, 2018, 8(4): 1257. doi: 10.1002/widm.1257

[10] 王睿, 胡云雷, 刘卫朋, 等. 基于边缘AI的焊缝X射线图像缺陷检测[J]. 焊接学报, 2022, 43(1): 79 − 84. Wang Rui, Hu Yunlei, Liu Weipeng, et al. Defect detection of weld X-ray image based on edge AI[J]. Transactions of the China Welding Institution, 2022, 43(1): 79 − 84.

[11] 刘欢, 刘骁佳, 王宇斐, 等. 基于复合卷积层神经网络结构的焊缝缺陷分类技术[J]. 航空学报, 2022, 43(S1): 165 − 172. Liu Huan, Liu Xiaojia, Wang Yufei, et al. Weld defect classification technology based on compound convolution neural network structure[J]. Acta Aeronautica et Astronautica Sinica, 2022, 43(S1): 165 − 172.

[12] 任文坚, 王永红, 李春凯, 等. 液体火箭发动机推力室熔焊缝数字化胶片图像缺陷识别方法研究[J]. 电焊机, 2023, 53(1): 9 − 14. Ren Wenjian, Wang Yonghong, Li Chunkai, et al. Research on automatic detection method of DR digital imaging for brazing seam defects of thrust chamber body[J]. Electric Welding Machine, 2023, 53(1): 9 − 14.

[13] 程松, 杨洪刚, 徐学谦, 等. 基于YOLOv5的改进轻量型X射线铝合金焊缝缺陷检测算法[J]. 中国激光, 2022, 49(21): 136 − 144. Cheng Song, Yang Honggang, Xu Xueqian, et al. Improved lightweight X-ray aluminum alloy weld defects detection algorithm basedon YOLOv5[J]. Chinese Journal of Lasers, 2022, 49(21): 136 − 144.

[14] 杨会敏, 李春棚, 袁新安, 等. 基于SSD的交流电磁场缺陷智能识别方法[J]. 无损检测, 2022, 44(8): 25 − 30. Yang Huimin, Li Chunpeng, Yuan Xin’an, et al. Defects intelligent recognition method of ACFM based on SSD[J]. Nondestructive Testing, 2022, 44(8): 25 − 30.

[15] Zhang Z, Zhang Y, Wen Y, et al. Intelligent defect detection method for additive manufactured lattice structures based on a modified YOLOv3 model[J]. Journal of Nondestructive Evaluation, 2022, 41(1): 1 − 14. doi: 10.1007/s10921-021-00836-z

[16] Wei X, Wei D, Suo D, et al. Multi-target defect identification for railway track line based on image processing and improved YOLOv3 model[J]. IEEE Access, 2020, 8(1): 973 − 988.

[17] Dong C, Zhang K, Xie Z, et al. An improved cascade RCNN detection method for key components and defects of transmission lines[J]. IET Generation, Transmission Distribution, 2023, 17(19): 4277 − 4292. doi: 10.1049/gtd2.12948

[18] Redmon J, Divvala S, Girshick R, et al. You only look once: unified, realtime object detection[J]. Computer Vision and Pattern Recognition, 2016, 91(1): 779 − 788.

[19] Bhavya Sree B, Yashwanth Bharadwaj V, Neelima N. An inter-comparative survey on state-of-the-art detectors—R-CNN, YOLO and SSD[C]//Intelligent Manufacturing and Energy Sustainability: Proceedings of ICIMES 2020. Springer Singapore, 2021: 475 − 483.

[20] Cao C Q. An improved faster R-CNN for small object detection[J]. Ieee Access, 2019, 7(1): 106838 − 106846.

[21] Bharati P, Pramanik A. Deep learning techniques—R-CNN to mask R-CNN: a survey[J]. Computational Intelligence in Pattern Recognition:Proceedings of CIPR 2019, 2020(1): 657 − 668.

[22] Cai Z W, Vasconcelos N. Cascade R-CNN: delving into high quality object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recongnition, 2018: 6165 − 6162.

[23] Sun C Y, Hong X J, Shi S, et al. Cascade faster R-CNN detection for vulnerable plaques in OCT images[J]. IEEE Access, 2021(9): 24697 − 24704.

[24] Cai Z W, Vasconcelos Nuno. Cascade R-CNN: high quality object detection and instance segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 43(5): 1483 − 1498.

[25] Feng T, Liu J G, Xia F, et al. A double-branch surface detection system for armatures in vibration motors with miniature volume based on ResNet-101 and FPN[J]. Sensors, 2020, 20(8): 1 − 16. doi: 10.1109/JSEN.2020.2978309

[26] Alshammari A, Chabaan R C. Sppn-Rn101: spatial pyramid pooling network with resnet 101-Based foreign object debris detection in airports[J]. Mathematics, 2023, 11(4): 841. doi: 10.3390/math11040841

[27] Ren K, Huang L, Fan C Q, et al. Real-time traffic sign detection network using DS-DetNet and lite fusion FPN[J]. Journal of Real-Time Image Processing, 2021, 18(6): 1 − 11.

[28] Li Y C, Zhou S L, Chen H, et al. Attention-based fusion factor in FPN for object detection[J]. Applied Intelligence, 2022, 1(1): 1 − 10.

[29] Chen J Y, Liu S P, Zhao L. Small object detection combining attention mechanism and a novel FPN[J]. Journal of Intelligent Fuzzy Systems, 2022, 42(4): 3691 − 3703.

[30] Dai Z Z, Chen M Q, Gu X D, et al. Batch drop block network for person re-identification and beyond [C]// Proceedings of the IEEE Conference on Computer Vision, 2019: 3690 − 3700.

[31] Ye J. Single valued neutrosophic cross-entropy for multicriteria decision making problems[J]. Applied Mathematical Modelling, 2014, 38(3): 1170 − 1175. doi: 10.1016/j.apm.2013.07.020

[32] Chen Y P, Xu K, Zhou P, et al. Improved cross entropy loss for noisy labels in vision leaf disease classification[J]. IET Image Processing, 2022, 16(6): 1511 − 1519. doi: 10.1049/ipr2.12402

[33] 程松, 戴金涛, 杨洪刚, 等. 基于改进型YOLOv4的焊缝图像检测与识别[J]. 激光与光电子学进展, 2022, 59(16): 105 − 111. Cheng Song, Dai Jintao, Yang Honggang, et al. Weld Image detection and recognition based on improved YOLOv4[J]. Laser & Optoelectronics Progress, 2022, 59(16): 105 − 111.

下载:

下载: