Multiview solder joint defect detection based on improved ResNet

-

摘要: 基于卷积神经网络的单视图检测不能有效识别三维形状的缺陷目标,导致在实际应用中,往往是通过只检测某一最具代表性的视图或者依次检测每个面来实现低精度的检测要求,这带来了较大的时间成本和使用限制. 针对这一问题,提出了改进的残差网络(ResNet),并将其应用于三维形状的焊点缺陷检测. 该模型首先会一次性获取焊点的所有视图图像,再通过特征聚合和自适应学习模块,最终获得检测结果. 多视图焊点数据集来自高频电感元件,在所提出方法的识别精度达到了99.48%. 结果表明,改进的残差网络在同等网络层数的情况下有效提升了图像识别精度;对比单视图检测,多视图检测结构仅以较少的时间代价获得了较大的精度提升,能有效完成实际工业生产中的三维形状缺陷目标的检测任务.Abstract: The single view detection based on convolutional neural network cannot effectively identify 3D shape defect targets. As a result, in practical applications, the low-precision detection requirements are often achieved by detecting only one of the most representative views or detecting each face in turn, which brings large time cost and use restrictions. To solve this problem, this paper proposes an improved residual network and applies it to 3D shape solder joint defect detection. The model can firstly obtain all view images of solder joints at one time, and then get detection results through feature aggregation and adaptive learning module. The multi-view solder joint data set was obtained from high frequency inductor element, and the identification accuracy of the proposed method reached 99.48%. The results show that the improved residual network can effectively improve the image identification accuracy under the same number of network layers. Compared with the single view detection, the multi-view detection structure can achieve greater accuracy with less time cost, and can effectively complete the detection task of 3D shape defect targets in actual industrial production.

-

Keywords:

- defect detection /

- multi-view /

- feature fusion /

- solder joint /

- convolutional neural network

-

0. 序言

电子封装已逐渐成为世界上最大的工业领域之一,焊接在电子封装中的作用变得尤为重要[1].然而焊点缺陷在电子封装等领域始终客观存在,目前传统的人工检测仍是众多企业的主要检测手段之一.计算机视觉的不断发展,使这类复杂的缺陷实现自动识别成为可能.传统的图像形态学算法如滤波、二值化和形态学等,只能应对简单的检测场景.随着图像处理和计算机视觉技术的进步,基于内容的产品检测被广泛应用于网上购物、自动结账系统、智能物流等领域[2].现有的产品检测系统主要使用具有固定单视角的检测,而焊点的缺陷形状繁多且呈三维形状,一些缺陷形状甚至需要结合多面才能做出准确的判断,这导致了传统的检测算法出现了较多的误检和漏检,在一定程度上限制了计算机视觉在制造业等领域的发展.

近年来,卷积神经网(convolutional neural networks, CNN)被广泛应用于图像分析中.随着网络的结构不断被改良和创新,ResNet[3]等更高性能的网络在分类、分割和检测等领域成为了更主流的算法选择,其关键在于加入了卷积层的捷径连接,有效解决了网络退化问题.目前大部分的基于CNN的检测方法仍然以单视图检测为主,对于焊点这类三维形状的缺陷来说,单一视图的检测将会不可避免带来漏检,因此目前在面对这类缺陷往往是只检测最具代表性的视图,一般为俯视图,或者通过逐一检测每个视图来达到识别所有表面的目的;但这不仅可能需要对不同的视图做独立的数据集和独立的训练,而且无法准确判断需要依赖多面情况的缺陷类型,这使得该类缺陷检测始终处于程序复杂冗余和精度不稳定的状态.

当前主流的电路元件缺陷检测方法是自动光学检测(automatic optic inspection, AOI),主要分为参考法和非参考法[4].参考法是直接将待检测图像与标准图像的对应像素采用异或、对比矩阵的秩或特征匹配[5]等计算方法,但这些方案对光照等环境稳定性要求高;而采用中值滤波、二值化、边缘检测、模板匹配等图像处理技术[6],则难以处理形状波动较大的目标.近年来,国内外在非参考法方向上的研究较多,文献[7]在Faster R-CNN的基础上提出了TDD-net,使用ResNet101作为网络主干,在电路板等微小缺陷检测中获得了98%的检测精度,但网络过大也带来了检测效率较低的问题;Chi等人[8]根据超声扫描图像的特点,提出了杂波抑制和去噪方法,并利用KSW二维熵对图像进行二值化处理,在单视图下能有效识别微小缺陷;文献[9]在通过在网络中引入轻量级的倒残差结构提出了YOLO-M,减少网络计算量,并成功试验于超低功耗边缘人工智能芯片勘智K210中.

目前大多数关于焊点检测的相关研究主要集中在垂直方向上的单视图检测,然而焊点属于微小型检测目标,且呈三维形状,仅从垂直方向进行的光学检测是无法克服空洞、遮挡等缺陷情况. 针对上述问题,文中提出一种改进残差网络的多视图焊点检测方法.该方法通过多视图拍摄结构获得不同视图的不同语义级别信息,运用改进的捷径连接提升了网络性能,并融合了自适应特征加权聚合的策略,提高了对三维形状焊点缺陷的检测精度. 这不仅有效提高了高频电感元件生产的自动化水平,产生了经济价值,也为同类微小型三维缺陷的识别提供了参考.

1. 网络主干改进设计

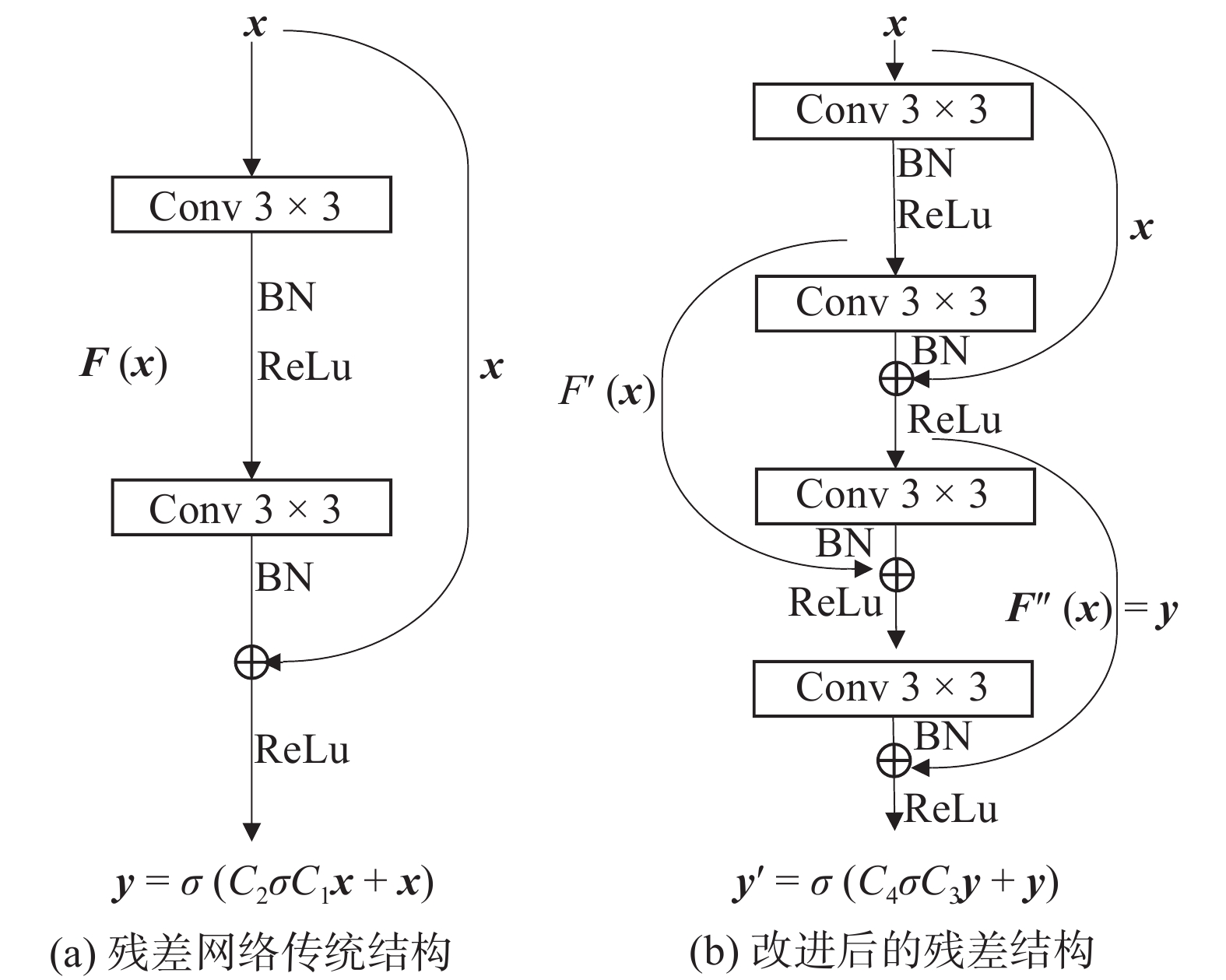

实际工业场景对检测的要求一般是高精度和高速度,而在卷积神经网络中,更高的精度意味着更高的网络层数,而网络层数越高,计算量往往越大,检测速度就越难令人满意,因此对于网络的实用需求一般是层数小并且精度高,这在工业缺陷检测领域的应用十分重要. 早期的卷积神经网络层数很小,如VGG(visual geometry group)网络,这种结构只是隐藏层简单的堆叠,层与层之间只有相邻的层存在联系. 但这种结构随着网络深度的增加,实际训练的精度却越来越越低,这称之为网络的退化,因此VGG网络无法做到更深,而网络层数的上限一定程度上限制了精度的上限,因为低层网络难以学习到更局部的特征,这很大程度上限制了卷积神经网络的应用. 为了应对这个问题,He等人[3]借鉴高速网络的跨层连接思想引出了捷径连接(shortcut connection),在传统的卷积神经网络上进一步提出了ResNet网络,与传统网络不同的是,ResNet在结构上采用残差块的形式堆叠,其网络模块结构如图1所示.图1a中每层卷积后接BN层(batch normalization)和激活函数ReLu,使用该结构代表网络有ResNet18,其中,x为输入向量,经两层卷积得到输出向量y,曲线为捷径连接,ResNet残差网络模块结构定义为

$$ {{{\boldsymbol{y}}}} = \sigma [{{\textit{C}}_2}{\sigma} ({{\textit{C}}_1}{\boldsymbol{x}}) + {\boldsymbol{x}}] $$ (1) 式中: C1和C2分别为第1和第2层卷积(Conv);σ为ReLU激活函数,而

$ F({\boldsymbol{x}},\{ {{\text{C}}_i}\} ) $ 表示要学习的残差映射. 在引入捷径连接前,传统的网络只是卷积等隐藏层简单的堆叠,当最优特征在浅层网络时,训练目标是希望深层网络的训练目标是恒等映射,但大量试验结果表明,传统网络的训练方法在深层网络实现恒等映射并不容易,也就是深层网络不可避免会训练出无效甚至反作用的权重. 残差网络的思路则是通过引入捷径连接实现恒等映射,巧妙跳过了深层网络权重的影响. 实现方法是使每个残差块的输入和输出叠加一次,训练网络的目标就从$F({\boldsymbol{x}},\{ {{\textit{C}}_i}\} ) \to {\boldsymbol{y}}$ 变成$F({\boldsymbol{x}},\{ {{\textit{C}}_i}\} ) + {\boldsymbol{x}} \to {\boldsymbol{y}}$ . 当网络需要向恒等映射方向优化时,只需要对应网络层的权重都趋于0,即训练目标为$ F({\boldsymbol{x}},\{ {{{C}}_i}\} ) \to 0 $ . 残差网络通过主动引入捷径连接实现恒等映射,使浅层网络的输入信号可以直接传播到深层,让网络的收敛方向始终向恒等映射方向发展. 与传统网络相比较,这种结构不仅加快了训练速度,还确保最终训练精度不会因为深度增加而降低,即缓解了网络退化问题.文中的检测目标与常见的缺陷检测任务不同,首先在输入上就需要以多张图像替代原来的单张图像,目前以单张图像作为输入的网络结构并不能直接运用于缺陷三维形、环境复杂的多视图检测任务. 因此基于残差网络思想构建了一个能适应这类任务的模型,提出了改进的残差网络模块结构,如图1b所示,将其定义为

$$ \left\{\begin{array}{l}{{{\boldsymbol{F}}}}{'}=\sigma ({C}_{1}{\boldsymbol{x}})\\ {{{\boldsymbol{F}}}}''=\sigma [{C}_{2}\sigma ({C}_{1}{\boldsymbol{x}}) + {\boldsymbol{x}}]\\ {\boldsymbol{y}}{'}=\sigma [{C}_{4}\sigma ({C}_{3}{\boldsymbol{F}}'' + {\boldsymbol{F}}{'}) + {\boldsymbol{F}}'']\end{array} \right.$$ (2) 式中:x和y′分别为改进后的残差网络的输入、输出向量;F′和F′′为参与捷径连接的中间特征;C3和C4分别为第3和第4层卷积.

一般来说,更深的神经网络,加入非线性激函数后,将拥有更大的假设空间,因此最优解更有可能被包含其中. 文中改进的残差网络结构与两层原始的残差卷积块相比较,卷积层数没有增加,但额外的捷径连接以少量的计算代价获得了更大的假设空间. 为了更直观比较两个残差块的不同,根据集成的思想[10],将提出的新残差网络结构与传统残差网络结构在相同卷积层数下展开对比,如图2所示. 残差网络的传统结构一般如图2a所示,这也是方程(1)的自然表示,图2b为图2a的展开视图. 圆形节点表示加法. 从展开形式看,传统残差网络有O(2n)连接输入输出的隐式路径,n为卷积层数目. 而图2c为文中提出的改进残差网络结构,图2d为图2c的展开视图. 原始的ResNet的两层残差结构图2a有两次捷径连接,展开后图2b有4条隐式路径. 而通过不断试验发现原始的捷径连接方式并不一定带来最佳的训练路径,而一种呈交叉状的捷径连接的残差网络带来更快的收敛和更高的精度,如图2c示,其隐式路径图2d最终增加到了5条. 相比传统的残差网络,改进的残差网络每次进行四次卷积操作才增加一次加法,增加的计算量和参数量是几乎可以忽略的.

为了验证模型改进的有效性,在进行多视图训练前,先将在经典数据集Cifar100上的试验结果作为多视图检测的预试验. 如表1所示,改进后的ResNet网络与相同层数的原始残差网络相比,在计算量几乎不变的情况下,精度得到了有效提升. 这表明网络改进的捷径连接增加了有效的假设空间,促进了浅层网络的性能提升.

表 1 不同模型在Cifar-100上的测试结果Table 1. Evaluation results of various models on Cifar-100模型 Top1错误率

Y E1 (%)Top5 错误率

YE5(%)计算量

YMC (G)参数量

YMP(M)ResNet34 22. 79 6. 11 1. 16 21. 32 ResNet50 22. 01 5. 80 1. 30 23. 71 Ours_ResNet34 22. 55 5. 90 1. 16 20. 39 Ours_ResNet50 21. 28 5. 14 1. 30 22. 68 2. 多视图缺陷检测

三维形状目标的缺陷检测是计算机视觉、多媒体分析和计算机图形学中的一个重要研究领域,最近基于多视图的方法在三维形状识别和检索表现出良好的性能. Ma等人[11]提出了一种新的基于多视图的三维形状识别和检索网络结构,主要是通过将卷积神经网络与长短期记忆人工神经网络相结合,从多个角度挖掘相关信息,该方法在三维形状识别和三维形状检索方面取得了良好的表现. 文献[12]提出了基于X射线技术的双标记平移法和旋转法两种缺陷定位方法检测焊缝缺陷深度. 通过对人工缺陷及实际焊缝缺陷深度测量,较好的实现过渡区域干扰下的缺陷识别,但对于检测系统的机械精度要求较高.

文中提出了一种新的基于改进ResNet的多视图自适应融合学习网络,在焊点缺陷检测上获得了优于传统方法的性能. 待检测目标的各种缺陷类型如图3所示,这是高频电感元件上的提取的焊点. 通常,焊接的目的是为了保证焊件在受到振动时不至脱落、松动以及保持稳定的导电性能. 如果焊点存在不合格,那么焊点作为电子封装中最脆弱的部分,其在使用过程中将很容易出现断路或者元器件性能参数不稳定[13]. 自动焊接的普及推动了焊点缺陷自动检测的需求. 与一般的表面缺陷检测不同,焊点缺陷检测存在几个难点:①金属材料的物理特性,如颜色相近,镜面反射;②缺陷类型繁多,主要有缺焊、虚焊、冷焊、空洞、拉尖、桥接、剥离以及锡量过多或过少[14];③焊点呈三维形状,焊点是否良好,仅从一面判断或者分别判断每个面均是不可行的,这因为存在一些缺陷类型,由于视图原因,它们每个面单独判断呈良好,但综合多个面来看形状却是不合格的,这类焊点缺陷类型称之为多面型缺陷. 然而前两点就使得传统检测方法的实现困难重重,因此文中以多视图整体思路为前提,采用基于卷积神经网络的检测方法,通过特征层聚合自适应学习,让网络在聚合后的特征层学习到不同视图的整体联系.

2.1 数据集

图3的数据集主要是来自于珠海科德电子有限公司的高频电感产品,对这类元件来说,焊接质量对其使用的稳定性有很大影响. 从该类元件中选取了500个焊点,每个焊点都获取左视图、俯视图和右视图,总计获取了1 500张焊点图. 在多视图检测中,同一焊点的3个视图将作为一个输入,以此替代原来的以一张图作为一个输入的单视图检测. 由于数据集形状的较大随机性,总体看来实际获得的数据集仍然较少,因此在数据集预处理阶段便采用了大量的数据增强,如翻转、裁剪、旋转、遮挡和噪声等[15],除此之外,在物理层面上也进行了随机光照强度、随机光照方向、随机偏振角等增强,有效缓解了过拟合等问题.

2.2 多视图自适应融合学习网络

数据集的加载和预处理是以3张作为一个输入,因此网络结构的输入应有3张图像,如图4所示. 3张不同视图图像经过一次相同的卷积操作后分别输入框中的主干网络,中间框中的部分为以改进残差块结构组成的网络主干,类似于ResNet传统的4层结构,主要负责学习图像的全局特征和局部特征. 3张图像通过网络相同的处理,分别形成3个512维度的全连接层,然后3个全连接层通过聚合形成一个1536维度的全连接层,最后通过两次全连接层实现网络对多视图特征的自适应学习和缺陷分类.

3. 试验与分析

3.1 超参数设置

对于所有训练均不采用预训练模型,动量[16]为0.9,权重衰减为1 × 10−4,初始学习率为0.1,学习率在epoch总数的50%和75%除以10,epoch总数设为100,损失函数采用交叉熵,如式(3)所示.

$$ L = \frac{1}{N}\sum\limits_i {{L_i} = - \frac{1}{N}\sum\limits_i {\sum\limits_{c = 1}^M {{y_{ic}}\log ({p_{ic}})} } } $$ (3) 式中:L为总损失值;Li为样本i的损失值;N为样本数目;M为类别数量; yic为符号函数,如果样本i的真实类别等于c, yic取1,否则取0; pic为观测样本i属于类别c的预测概率.

3.2 单视图与多视图对比试验

为了表明多视图的有效性和必要性,文中展示了单视图和多视图的对比试验结果. 为了模拟实际单视图检测过程,图片的标签确立应是依赖于整体而不是局部,对于单视图检测,数据集由每次输入3张变成每次输入一张,但3张图的标签仍然保持分开前的缺陷类型. 另外,在单视图检测网络中将去掉用于多视图特征聚合和自适应学习的全连接层FC2和FC3. 单视图和多视图的最终测试结果如表2所示.

表 2 不同模型上焊点数据集的单视图和多视图的测试错误率 (%)Table 2. Test error rate of single view and multi view of different models on solder joint dataset模型 单视图错误率 YSE 多视图错误率 YME VGG19 7.07 5.09 MobileNet 5.47 3.65 ResNet34 5.02 2.53 ResNet50 4.86 1.34 DLA 4.68 0.60 SENet50 4.23 0.55 Ours_ResNet34 4.93 1.58 Ours_ResNet50 4.35 0.52 3.3 结果与分析

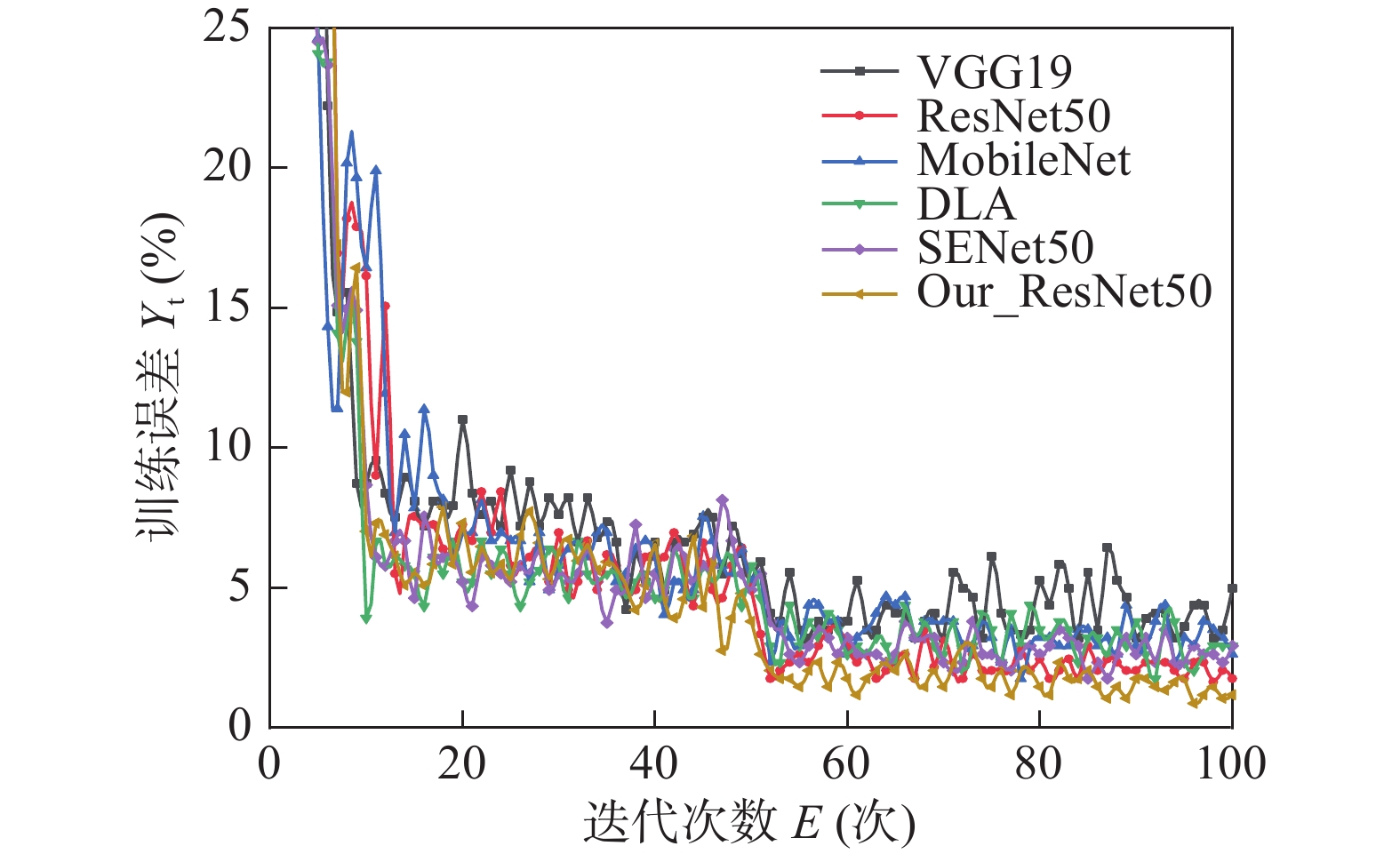

为了评估多视图自适应融合学习网络在实际应用中的性能,文章实现了多个模型在多视图焊点数据集上的训练和测试,训练曲线如图5所示. 在基于改进后的34层和50层残差网络中,焊点数据集通过训练获得了较好的精度. 从表2可知,在相同网络层数下,改进后的ResNet网络的性能是优于原始残差网络的,对比于MobileNet,DLA[17]和SENet[18]同等轻量模型也有一定精度优势,证明网络改进的捷径连接方式对于多视图聚合自适应学习仍是有效的. 在50层时,多视图自适应融合学习网络最小错误率只有0.52%,满足一定的工业应用需求. 此外,相对于单视图训练框架,多视图训练框架带来了显著的性能提升,这是因为单视图保持了3个视图分开前的整体标签,而多视图标签是根据3个视图整体判定的,如图6所示. 这种整体标签虽然是正确的,但存在一些缺陷标签的确定只是取决于某一单面的局部特征,而其它面则可能与良好焊点的单面没有明显差异,因此这对于单视图训练是很难拟合的,甚至可能拟合到毫不相关的特征. 对于检测目标形状呈三维状态,文中提出的多视图融合学习策略是能克服这一问题并完成这类识别任务的.

4. 结论

(1) 通过改进ResNet残差块的捷径连接方案获得了更多更有效的恒等映射路径和假设空间,有效提升了网络的分类性能,能有效识别焊点缺陷.

(2)由于焊点缺陷呈三维形状,通过获取焊点的左视图、俯视图和右视图作为数据集,并将其作为一个整体分别输入多视图自适应融合学习网络,提高了焊点缺陷识别的鲁棒性.

(3)在多视图缺陷检测框架上,高频电感元件的焊点缺陷识别的实际测试精度达99.48%. 试验结果证明了多视图检测框架的有效性和可行性.

-

表 1 不同模型在Cifar-100上的测试结果

Table 1 Evaluation results of various models on Cifar-100

模型 Top1错误率

Y E1 (%)Top5 错误率

YE5(%)计算量

YMC (G)参数量

YMP(M)ResNet34 22. 79 6. 11 1. 16 21. 32 ResNet50 22. 01 5. 80 1. 30 23. 71 Ours_ResNet34 22. 55 5. 90 1. 16 20. 39 Ours_ResNet50 21. 28 5. 14 1. 30 22. 68 表 2 不同模型上焊点数据集的单视图和多视图的测试错误率 (%)

Table 2 Test error rate of single view and multi view of different models on solder joint dataset

模型 单视图错误率 YSE 多视图错误率 YME VGG19 7.07 5.09 MobileNet 5.47 3.65 ResNet34 5.02 2.53 ResNet50 4.86 1.34 DLA 4.68 0.60 SENet50 4.23 0.55 Ours_ResNet34 4.93 1.58 Ours_ResNet50 4.35 0.52 -

[1] Su S, Akkara F J, Thaper R, et al. A state-of-the-art review of fatigue life prediction models for solder joint[J]. Journal of Electronic Packaging, 2019, 141(4): 040802. doi: 10.1115/1.4043405

[2] Wang Q, Liu X, Liu W, et al. MetaSearch: incremental product search via deep meta-learning[J]. IEEE Transactions on Image Processing, 2020, 29: 7549-7564.

[3] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, America, 2016: 770-778.

[4] Zhang Z, Wen G, Chen S. Weld image deep learning-based on-line defects detection using convolutional neural networks for Al alloy in robotic arc welding[J]. Journal of Manufacturing Processes, 2019, 45: 208 − 216.

[5] 王中任, 王小刚, 刘德政, 等. 基于焊枪轮廓特征提取的焊接偏差测定方法[J]. 焊接学报, 2020, 41(7): 59 − 64. doi: 10.12073/j.hjxb.20191026002 Wang Zhongren, Wang Xiaogang, Liu Dezheng, et al. Welding eviation measurement method based on welding torch contour feature extraction[J]. Transactions of the China Welding Institution, 2020, 41(7): 59 − 64. doi: 10.12073/j.hjxb.20191026002

[6] 肖文波, 何银水, 袁海涛, 等. 镀锌钢GMAW焊缝成形特征与焊枪方向同步实时检测[J]. 焊接学报, 2021, 42(12): 78 − 82. doi: 10.12073/j.hjxb.20201021001 Xiao Wenbo, He Yinshui, Yuan Haitao, et al. Synchronous real-time detection of weld bead geometry and the welding torch in galvanized steel GAMW[J]. Transactions of the China Welding Institution, 2021, 42(12): 78 − 82. doi: 10.12073/j.hjxb.20201021001

[7] Ding R, Dai L, Li G, et al. TDD-net: a tiny defect detection network for printed circuit boards[J]. CAAI Transactions on Intelligence Technology, 2019, 4(2): 110 − 116. doi: 10.1049/trit.2019.0019

[8] Chi Dazhao, Gang Tie. Defect detection method based on 2D entropy image segmentation[J]. China Welding, 2020, 29(1): 45 − 49.

[9] 王睿, 胡云雷, 刘卫朋, 等. 基于边缘AI的焊缝X射线图像缺陷检测[J]. 焊接学报, 2022, 43(1): 79 − 84. Wang Rui, Hu Yunlei, Liu Weipeng, et al. Defect detection of weld X-ray image based on edge AI[J]. Transactions of the China Welding Institution, 2022, 43(1): 79 − 84.

[10] Veit A, Wilber M J, Belongie S. Residual networks behave like ensembles of relatively shallow networks[J]. Advances in Neural Information Processing Systems, 2016, 29: 550 − 558.

[11] Ma C, Guo Y, Yang J, et al. Learning multi-view representation with LSTM for 3D shape recognition and retrieval[J]. IEEE Transactions on Multimedia, 2018, 21(5): 1169 − 1182.

[12] 迟大钊, 李孙珏, 孙昌立, 等. 基于双目视觉的缺陷深度测量方法[J]. 焊接学报, 2016, 37(11): 7 − 10. Chi Dazhao, Li Sunjue, Sun Changli, et al. Binocular visual based defect buried depth testing method[J]. Transactions of the China Welding Institution, 2016, 37(11): 7 − 10.

[13] Jiao Y, Jermsittiparsert K, Krasnopevtsev A Y, et al. Interaction of thermal cycling and electric current on reliability of solder joints in different solder balls[J]. Materials Research Express, 2019, 6(10): 106302. doi: 10.1088/2053-1591/ab366d

[14] Dai W, Mujeeb A, Erdt M, et al. Soldering defect detection in automatic optical inspection[J]. Advanced Engineering Informatics, 2020, 43: 101004. doi: 10.1016/j.aei.2019.101004

[15] Liu Z, Cao Y, Li Y, et al. Automatic diagnosis of fungal keratitis using data augmentation and image fusion with deep convolutional neural network[J]. Computer Methods and Programs in Biomedicine, 2020, 187: 105019. doi: 10.3390/info11020125

[16] He K, Fan H, Wu Y, et al. Momentum contrast for unsupervised visual representation learning[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Anchorage, Alaska, USA, 2020: 9729 − 9738.

[17] Yu F, Wang D, Shelhamer E, et al. Deep layer aggregation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Salt Lake City, USA, 2018: 2403 − 2412.

[18] Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Salt Lake City, USA, 2018: 7132 − 7141.

下载:

下载: