Adaptive edge detection of molten pool based on coarse-grained regularization in restricted solution space

-

摘要: 边缘检测是熔池图像处理的关键步骤. 鉴于熔池区域弧光变化剧烈,依赖人为设置阈值的边缘检测方法难以适应弧光的动态变化过程,文中提出了一种基于深度学习的熔池边缘提取模式. 首先对原始熔池图像进行像素级标注和数据增广以构建数据集;其次结合先验知识提出了一种受限解空间下的粗粒度正则化方法(coarse grained regularization method in restricted solution space, CGRRSS)以增强边缘特征;最后从定量和定性两方面将所提方法与传统方法进行了对比. 结果表明,所提方法对边缘点的召回率较高,所获熔池边缘更连续且对伪边缘具有更好的抑制作用. 单幅图像检测时间6.2 ms,可满足在线监测需求.Abstract: Edge detection is a key step in the image processing of the molten pool. In view of the sharp changes in the arc in the molten pool area, the edge detection method that relies on artificially setting the threshold is difficult to adapt to the dynamic change of the arc. This paper proposes a deep learning-based edge extraction mode of the molten pool. Firstly, pixel-level annotation and data augmentation are performed on the original molten pool image to build a dataset. Secondly, a coarse-grained regularization method in restricted solution space (CGRRSS) is proposed to enhance edge features. Finally, the proposed method is compared with the traditional methods in both quantitative and qualitative aspects. The results show that the proposed method has a higher recall of edge points, the obtained molten pool edge is more continuous and has a better suppression effect on false edges. The detection time of a single image is 6.2 ms, which can meet the needs of online monitoring.

-

Keywords:

- molten pool image /

- deep learning /

- edge detection /

- regularization /

- coarse-grained

-

0. 序言

熔焊是重要的焊接方式. 鉴于熔池的形态可以直接反映焊接质量,熟练的焊接工人可以通过眼睛观察熔池的形态变化来实时调整焊接工艺. 因此基于视觉的熔池在线监测方法得到了广泛的研究[1-3]. 在针对熔池图像的研究中,传统的思路往往遵循原图-滤波-增强-阈值分割-二值化-边缘提取-特征提取的技术路线[4-6]. 在这条技术路线中,边缘作为熔池图像的关键特征对于获取准确的熔池特征尺寸至关重要.

传统的熔池边缘提取方法主要是采用一阶或二阶微分算子来寻找灰度突变的地方. 根据这个思路构造了很多经典的边缘检测模板,如Soble[7],Canny[8],Prewitt[9],形态学算子[10]等. 但是该类方法存在检测出的边缘连续性差、以及对伪边缘的检测能力差等不足. 另一点不足之处是在实现边缘检测的技术路线中会涉及阈值操作,而阈值的设定则依赖人为经验. 由于熔池区域弧光变化剧烈,人为设置阈值不但存在主观性,而且也难以适应弧光的动态变化过程以至于无法获得良好的边缘.

针对以上问题,提出了一种端到端(熔池图像到边缘图像)的熔池边缘自适应提取模式. 深度学习技术的出现为开展该研究提供了一种思路. 在基于深度学习的图像边缘检测研究中,代表性的工作有HED[11],RCF[12],CASENet[13],DeepEdge[14]等. 其中HED网络采用VGG16作为模型基础,其核心思想是对每一组卷积的侧边输出进行深度监督;RCF网络则考虑每一层卷积的输出以获取更丰富的边缘信息;CASENet网络引入了残差模块并结合空洞卷积来增加感受野;DeepEdge采用Canny算子提取出的候选边缘作为高级边缘先验信息. 综观这些方法,网络的模型架构均十分庞大,而焊接领域内的已标注数据比较少且数据标注过程费时费力. 因此,如何从焊接领域内的小样本中提取丰富的熔池边缘特征并防止基于深度学习的边缘检测模型过拟合是研究的关注点. 在防止模型过拟合的方法中,数据增广和参数正则化是最基本且可解释性最强的,文中将从这两方面着手,并针对卷积神经网络的特点设计特定的参数正则化方法以获取更丰富的特征.

1. 方法

1.1 总体架构

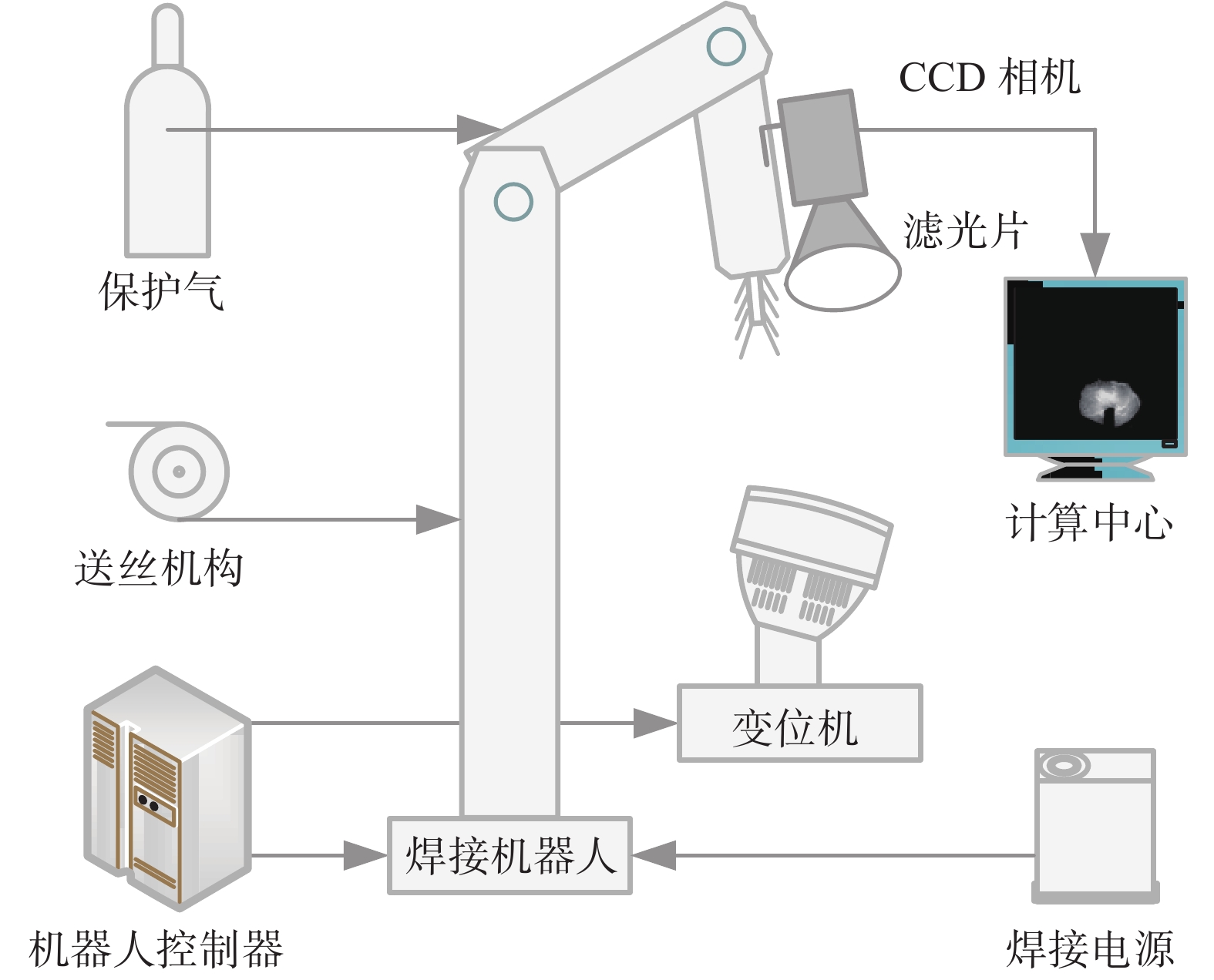

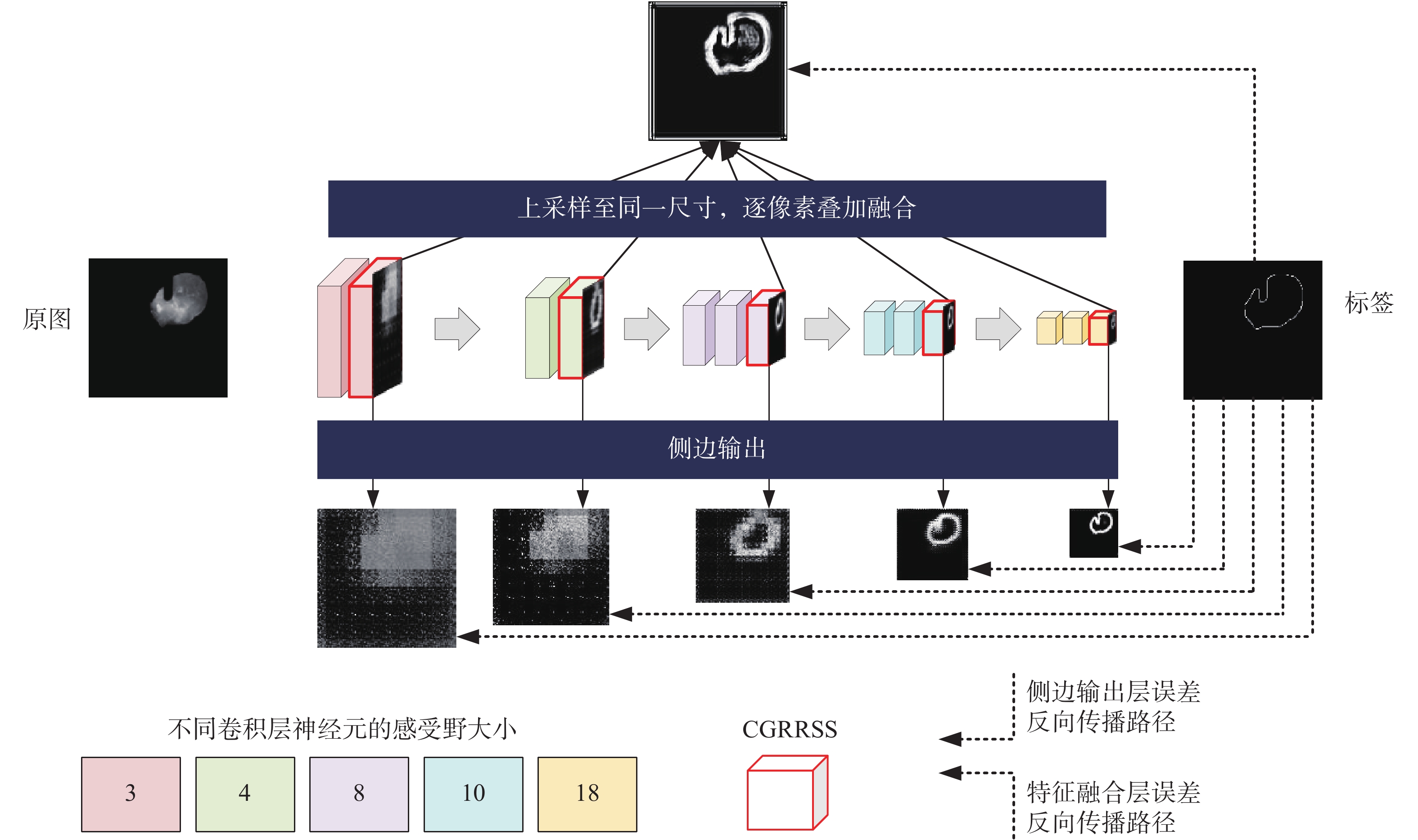

文中设计的基于深度学习的边缘检测方法的总体框架如图1所示. 该方法以文献[11]中的HED边缘检测模型为基础,从中可以看出该网络在每一组卷积之后均插入侧边输出层. 针对每个侧边输出均由手工标注的边缘标签进行深度监督,以此引导网络往边缘检测的方向被训练. 此外,由于HED模型的骨干网络是VGG16,因此HED模型的不同侧边输出具有多尺度特性. 随着侧边输出尺寸的减小,神经元的感受野(输出特征图上的像素点在输入特征图上映射的区域大小)也相应变大. 因此,在侧边特征融合层首先将不同侧边的输出上采样至同一尺寸,然后进行逐像素叠加融合,此融合结果仍由边缘标签进行监督. 为了防止在模型过拟合的基础上提高卷积层的特征提取能力,在侧边输出卷积层加入一种受限解空间下的粗粒度正则化方法(coarse grained regularization method in restricted solution space, CGRRSS),该方法由基于L2正则化的解空间限制模块和基于粗粒度正则化的特征提升模块组成. 整个网络在训练过程的误差则是通过融合层和5个侧边层进行反向传播.

1.2 构建数据集

在数据集的构建方面,文中首先采用图2所示的焊接机器人系统获取原始熔池图像. 鉴于边缘标签需要逐像素的标注,这一过程极其费时费力. 在获取原始熔池图像后仅对其中一部分熔池图像进行人工标注,然后通过数据增广的方式来扩充数据集. 常用的数据增广方法主要有基本变换法、弹性变换法[15]、插值法[16]、生成对抗网络法[17]等. 其中弹性变换、插值、生成对抗网络这三类方法的总体思想是用不同的方式对原始数据的分布进行建模并据此生成新数据. 由于这三类方法本身还处于研究当中,文中采用基本变换法对数据集进行扩充. 常用的基本变换法包括放缩、旋转、镜像等基本几何操作. 为了保证熔池图像的完整性,不采用剪切和平移的操作.

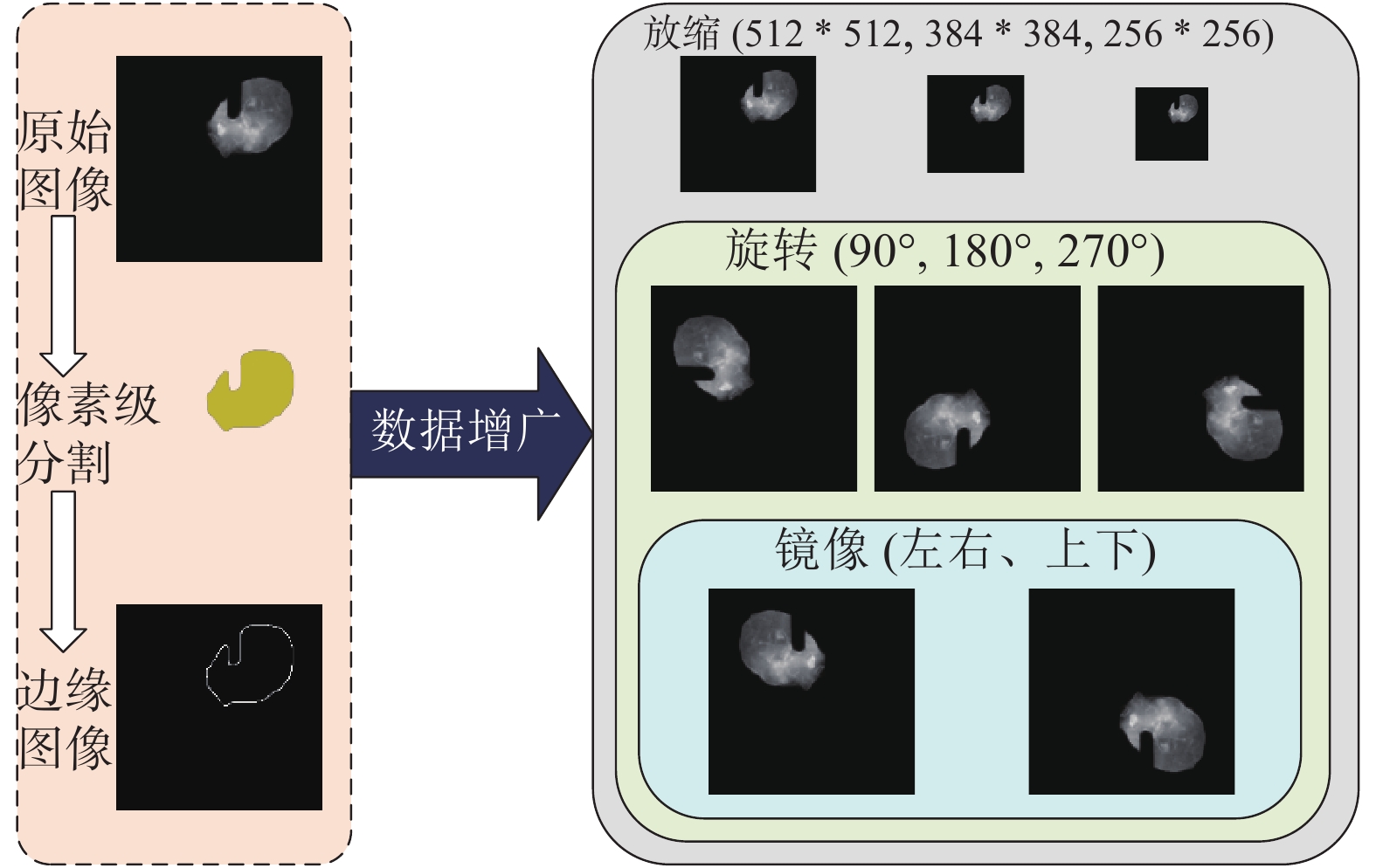

面向基于深度学习的熔池图像边缘检测任务的数据集构建过程如图3所示. 首先对原始图像进行像素级分割以获取精确的熔池区域,其次采用Canny算子提取分割图像中的熔池图像边缘并进行细化得到最终的边缘图像. 共计手工标记150幅尺寸为768*768的原始熔池图像. 在数据增广方面,首先将原始图像放缩至512*512,384*384,256*2563个尺度;其次在每个尺度下分别将图像沿中心点逆时针旋转90 °,180 °,270 °;最后在任一尺度及旋转角度下对图像进行左右和上下两个方向的镜像操作. 因此,最终得到的数据集共包含7 200组,每一组包含一张熔池图像和对应的边缘标签图像.

1.3 受限解空间下的粗粒度参数正则化方法

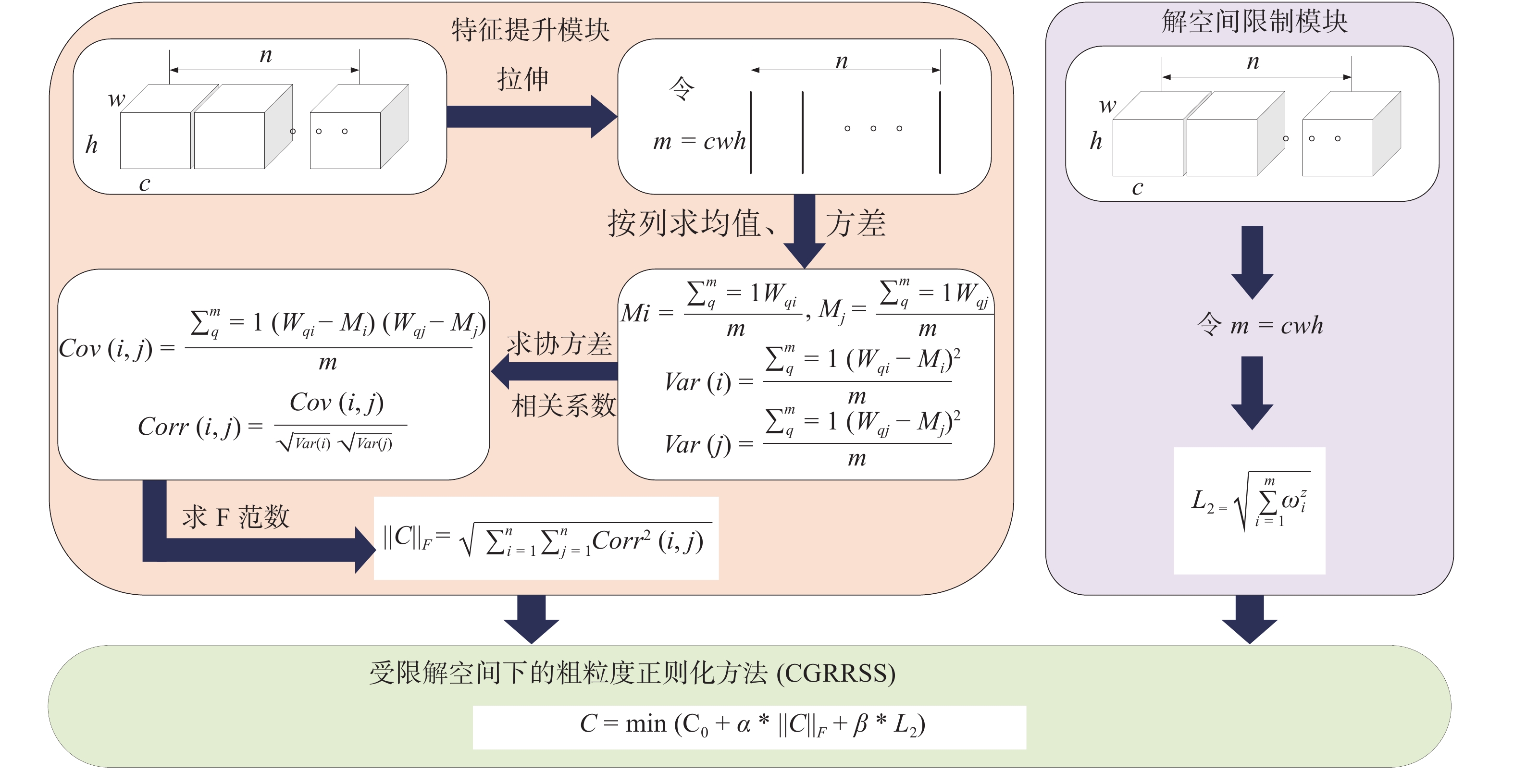

传统的参数正则化方法(L1,L2)可以通过缩小解空间来防止模型过拟合,其中L1正则化蕴含的先验知识是权重参数符合拉普拉斯分布,L2正则化蕴含的先验知识是权重参数符合高斯分布. 但这两种方法的本质是在特征提取能力和解空间规模之间的一种权衡,因此对深度学习模型的特征提取能力有一定的限制. 这主要是因为L1和L2方法对权重参数不加分别的进行考虑,这是一种细粒度的操作. 而卷积神经网络的权重参数以特定组合存在于卷积核中,卷积核中的参数是具有局部关联的特点. 不同的局部关联构成不同的卷积核,不同的卷积核可以提取出不同的特征. 因此希望能在对解空间进行限制以防止过拟合的前提下尽可能的提高卷积核的特征提取能力. 因此对面向熔池边缘检测任务的卷积神经网络加入以下先验知识:每个侧边输出的那组卷积核应尽可能的不同,从而可以提高卷积层的特征提取能力和鲁棒性. 这就要求在训练的过程中得到侧边输出的那组卷积核之间的差异应往变大的方向被训练. 为了融入上述先验知识,提出了CGRRSS方法,该方法由基于L2正则化的解空间限制模块和基于粗粒度正则化的特征提升模块组成. CGRRSS方法的计算流程如图4所示.

如图4所示,在解空间限制模块直接计算该层次所有卷积核内参数的L2范数. 在特征提升模块首先将三维卷积核拉伸为一维列向量,然后按列求出各向量的均值和方差;其次求出各列之间的协方差和相关系数,最后求此相关系数矩阵的F范数并作为卷积核之间相似性的度量. 最后将两个模块得到的范数分别乘以一个调制系数加入原损失函数. 加入CGRRSS方法之后,在网络的训练过程中解空间限制模块则可以限制解空间的大小以防止模型过拟合;而特征提升模块的存在则可使卷积核向差异变大的方向被训练,从而促使卷积核提取出更丰富的边缘特征.

2. 试验及分析

2.1 试验环境及超参数设定

数值试验的硬件环境为Ubuntu16.04操作系统以及GeForce2080Ti显卡,其显存大小为12G. 编译环境采用Python3.5语言以及Tensorflow1.4.0的深度学习框架. 将5184张图像用于训练,1296张图像用于验证,720张图像用于测试. 在训练过程中将批次大小设置为12、迭代次数设置为200,学习率设置为0.000 1.

在模型方面,将13个卷积层的卷积核依次设置为64,64,128,128,256,256,256,512,512,512,512,512,512个. 此外,将卷积核的尺寸均设置为3*3且卷积步长均为1. 设置池化窗口大小为2*2,且池化步长为2. 在卷积和池化过程中的填充方式均设置为SAME. 在激活函数方面均采用Relu. 最后将特征提升模块和解空间限制模块的调制系数

$ \alpha $ 和$ \;\beta $ 均设置为10−6.2.2 训练过程分析

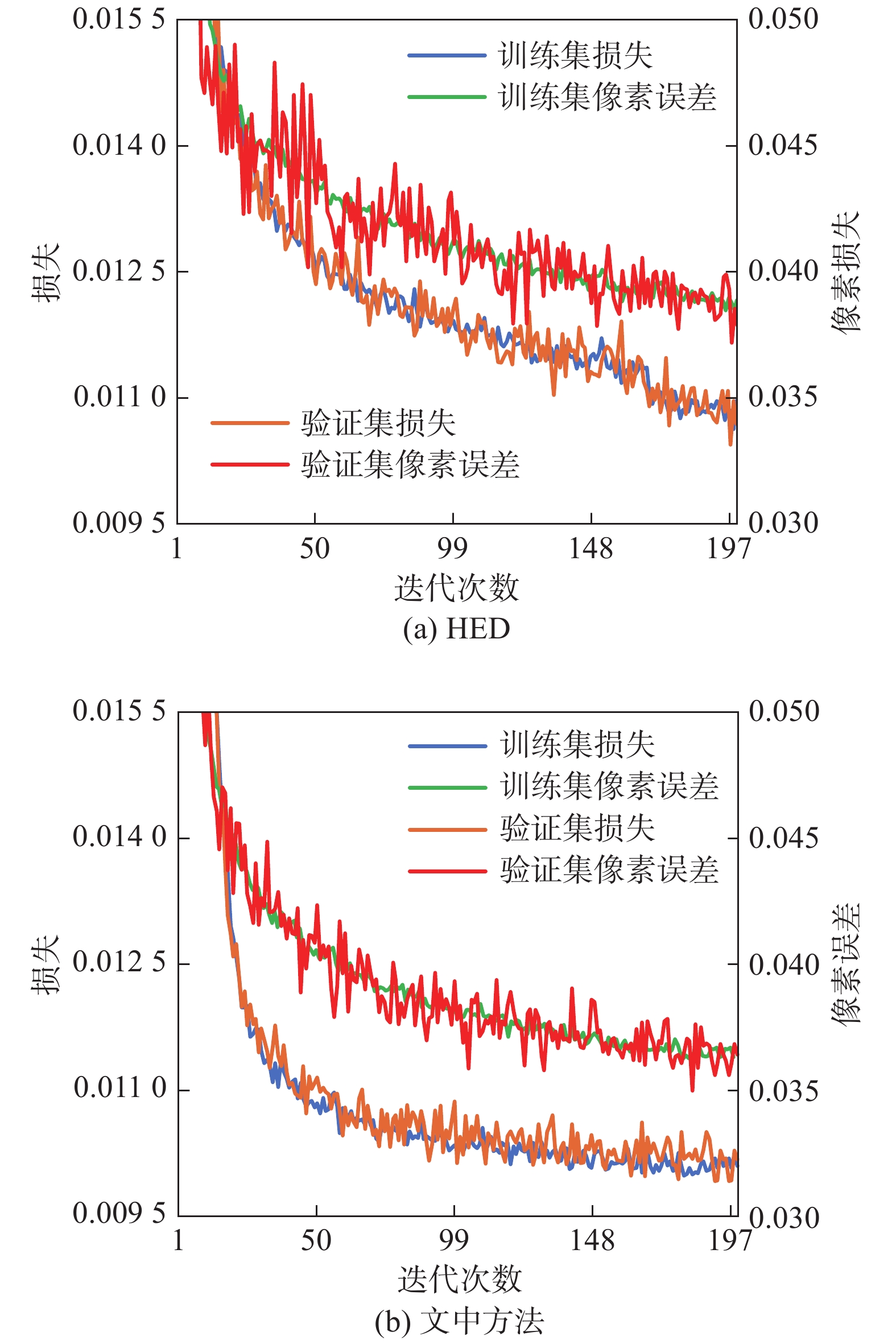

图5显示了传统的HED方法以及文中提出的方法在训练过程中的损失函数和像素误差的变化情况. 从中可以看出,两种方法的损失函数和像素误差随着训练的进行均不断降低. 验证集上的损失和像素误差并没有高出训练集很多,这说明两种方法均没有发生明显的过拟合现象. 但是,传统方法的损失函数在迭代180次左右才能收敛,且最终仅能收敛于0.010 9左右. 在添加了CGRRSS方法后,文中方法的损失函数在迭代150次左右即可收敛,且最终能收敛于0.01左右. 通过像素误差的变化情况可以发现,添加CGRRSS方法后的收敛过程也相对平稳.

2.3 试验结果分析

2.3.1 定量分析

基于深度学习的边缘检测模型的输出是一个概率图,即模型将每一个像素判断为边缘点的概率. 因此需要选取一个阈值把概率图转化为边缘图. 文中采用最优数据集尺度(optimal dataset scale, ODS)的策略,该策略为所有待测试图像设置同一个阈值. 在确定了阈值选择策略之后,采用准确率(accuracy, ACC)、精确率(precise, PRE)、召回率(recall, REC)、F1-score 4个指标对相关方法进行综合评估. 各指标的定义如下.

$$ ACC=\frac{TP+TN}{TP+TN+FP+FN} $$ (1) $$ PRE=\frac{TP}{TP+FP} $$ (2) $$ REC=\frac{TP}{TP+FN} $$ (3) $$ F1-score=\frac{2*PRE*REC}{PRE+REC} $$ (4) 在以上各式中,TP表示某像素实际为边缘点同时被判定为边缘点;TN表示某像素实际为非边缘点同时被判断为非边缘点;FP表示某像素实际为非边缘点同时被判定为边缘点;FN表示实际为边缘点同时被判定为非边缘点. 在确定评价指标后,将所提方法与传统方法在测试集上评估结果列于表1.

表 1 不同方法在测试集上的评估结果Table 1. evaluation results of different methods on test set方法 ACC (%) PRE (%) REC (%) F1-score (%) 测试时间 t/ms Sobel 98.7 5.1 9.4 6.5 12.3 Canny 98.9 8.1 10.5 7.1 7.8 Prewitt 97.1 6.8 38.7 11.1 7.1 形态学 95.7 5.6 49.5 9.7 10.1 HED 98.1 14.9 58.4 22.6 5.3 文中方法 95.9 9.3 78.4 16.3 6.2 由于在制作数据集时将熔池边缘标记为了单像素,所以在标签图像中边缘像素点占极少数而背景像素占极大数. 因此虽然表1所示的各种方法都可以获得较高的总体准确率,但是该指标的参考价值不高. 表1中各方法的精确率、召回率、F1-score均比较低,这是因为表中方法将背景像素当作了边缘像素,而边缘像素点比较少,从而导致FP较大. 根据式(2)~式(4)可知,FP的增大会导致PRE和F1-score的降低. 但是基于深度学习的方法可以得到相对较高的指标值. 此外从表1中可以看出所提方法的REC最高. 这说明针对边缘点而言,文中提出的方法将其正确分类的概率最大. 在时间方面,所提方法检测单幅图像耗时6.2 ms. 针对此结果,从数据获取和结果呈现的角度来说,一般的工业CCD相机采集帧率在几十赫兹的量级,一般的显示器工作频率也大约在50~60 Hz,因此所提方法可以满足在线监测的工业需求.

2.3.2 定性分析

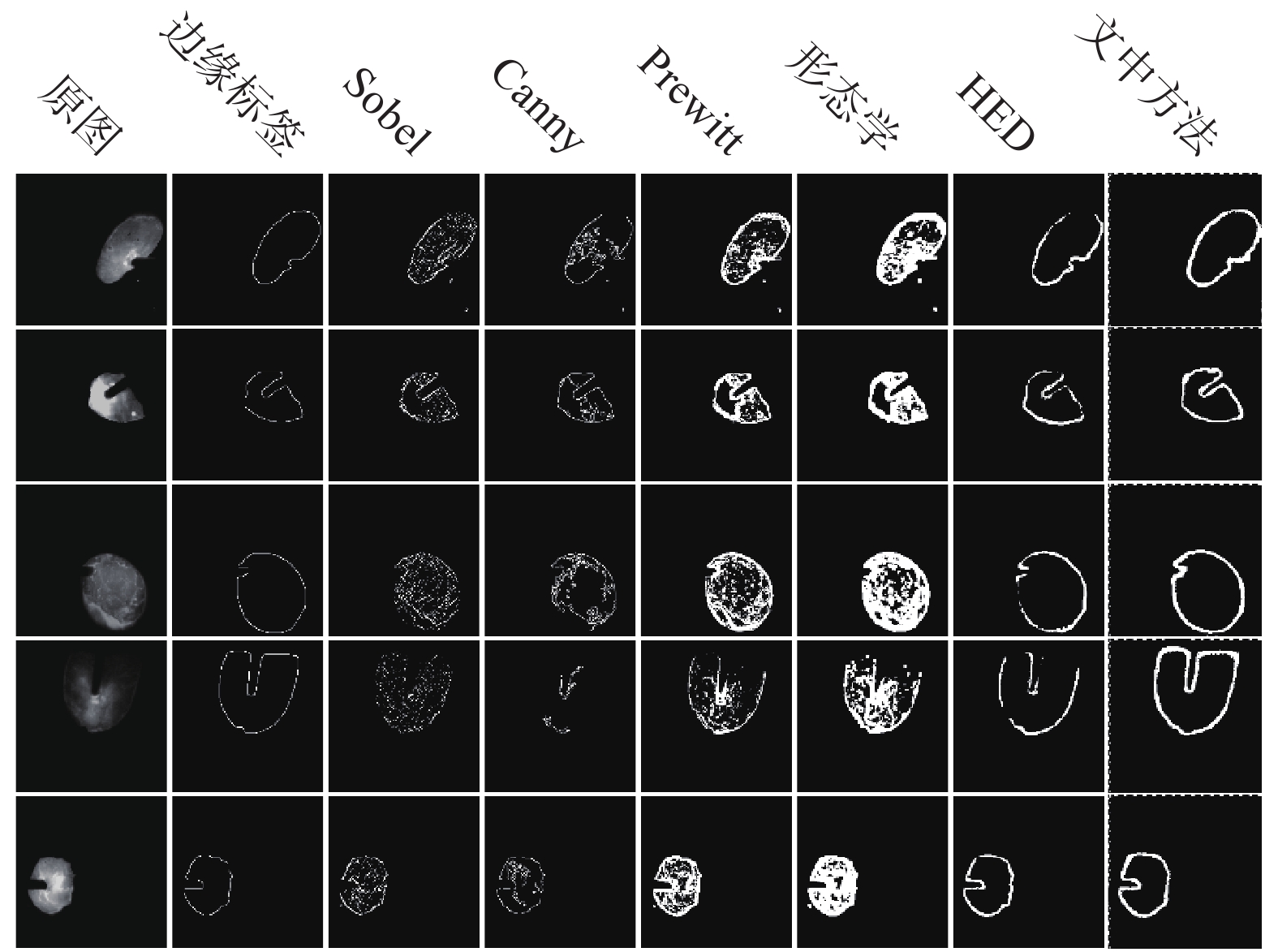

在训练完成后,将模型保存为可测试文件,然后调用该文件即可对熔池图像进行实际的边缘检测. 为了体现所提方法面对灰度变化时的动态适应能力,选择一组灰度变化比较明显的熔池图像进行测试. 图6为不同方法的边缘检测结果.

从图6可以看出:传统方法在处理图像灰度变化剧烈的熔池图像时不但提取到了很多伪边缘,而且熔池边缘的连续性也比较差. 此外传统方法面对灰度分布不一致的熔池图像时所提取的边缘差异也较大. 文中提出的方法在弧光变化剧烈的情况下仍能自适应的提取熔池边缘,且对伪边缘的抑制能力较强,所提取的边缘也更加完整. 通过检测结果和边缘标签的对比可以发现所提方法检测的边缘较粗,这是导致所提方法的各项定量指标不高的原因,但这也说明所提方法检测的最终结果都分布在实际像素周围. 而传统方法的各项指标低的原因则在于将很多非边缘区域检测为了熔池边缘.

所提方法虽然取得了较好的检测结果,但是还存在以下不足. 第一,文中涉及的超参数是根据经验设定的,在以后的应用和研究中还需要进一步针对性的优化;第二,文中方法检测出的熔池边缘比较粗,这不利于后续的熔池特征提取,在今后的研究中需考虑将边缘细化融入深度学习过程,以实现从原始图像到单像素边缘图像的端到端映射.

3. 结论

(1)基于深度学习的熔池边缘方法对弧光剧烈变化的过程具有鲁棒性,该方法可减少人为参与程度,从而实现端到端的熔池图像边缘检测新模式.

(2) CGRRSS方法可在限制模型解空间的基础上提升卷积核对边缘特征的提取能力.

(3) CGRRSS方法抑制伪边缘的能力强,所提取熔池图像的边缘连续性好.

(4) CGRRSS方法在边缘检测过程的总体识别准确率可达95.9%;对边缘像素的召回率可达78.4%;单幅图像处理时间为6.2 ms,可满足在线监测需求.

-

表 1 不同方法在测试集上的评估结果

Table 1 evaluation results of different methods on test set

方法 ACC (%) PRE (%) REC (%) F1-score (%) 测试时间 t/ms Sobel 98.7 5.1 9.4 6.5 12.3 Canny 98.9 8.1 10.5 7.1 7.8 Prewitt 97.1 6.8 38.7 11.1 7.1 形态学 95.7 5.6 49.5 9.7 10.1 HED 98.1 14.9 58.4 22.6 5.3 文中方法 95.9 9.3 78.4 16.3 6.2 -

[1] 侯震, 许燕玲, 黄色吉, 等. 视觉传感技术在机器人焊接中的应用[J]. 上海交通大学学报, 2016, 50(S1): 55 − 58. Hou Zhen, Xu Yanling, Huang Seji, et al. Application status of vision sensing used in robotic welding[J]. Journal of Shanghai Jiaotong University, 2016, 50(S1): 55 − 58.

[2] Liu Y K, Zhang Y M, Kvidahl L. Skilled human welder intelligence modeling and control[J]. Welding Journal, 2014, 93: 46 − 52.

[3] 刘祖明. 受控脉冲穿孔等离子弧焊接背面小孔动态行为的视觉检测与控制[D]. 济南: 山东大学, 2013. Liu Zuming. Vision sensing and control of the backside keyhole dynamic behaviors in controlled-pulse keyholing plasma arc welding process[D]. Jinan: Shandong University, 2013.

[4] 陈子琴, 高向东, 王琳. 大功率盘形激光焊焊缝背面宽度预测[J]. 光学精密工程, 2017, 25(9): 2524 − 2531. doi: 10.3788/OPE.20172509.2524 Chen Ziqin, Gao Xiangdong, Wang Lin. Weld width prediction of weldment bottom surface in high-power disk laser welding[J]. Optics and Precision Engineering, 2017, 25(9): 2524 − 2531. doi: 10.3788/OPE.20172509.2524

[5] 黄军芬, 薛龙, 黄继强, 等. 基于视觉传感的GMAW熔透状态预测[J]. 机械工程学报, 2019, 55(17): 41 − 47. doi: 10.3901/JME.2019.17.041 Huang Junfen, Xue Long, Huang Jiqiang, et al. GMAW penetration state prediction based on visual sensing[J]. Journal of Mechanical Engineering, 2019, 55(17): 41 − 47. doi: 10.3901/JME.2019.17.041

[6] 方吉米, 王克鸿, 黄勇. 高速GMAW驼峰焊道形成过程熔池图像识别[J]. 焊接学报, 2019, 40(2): 42 − 46. Fang Jimi, Wang Kehong, Huang Yong. Weld pool image recognition of humping formation process in high speed GMAW[J]. Transactions of the China Welding Institution, 2019, 40(2): 42 − 46.

[7] 李静, 李芳, 朱伟, 等. 基于被动光的MAG管道打底焊焊缝边缘提取方法[J]. 焊接学报, 2011, 32(10): 69 − 72. Li Jing, Li Fang, Zhu Wei, et al. A new seam location extraction method for pipe-line backing welding of MAG based on passive optical vision sensor[J]. Transactions of the China Welding Institution, 2011, 32(10): 69 − 72.

[8] 董瑶, 李伟超, 刘今越, 等. 用于航空发动机叶片焊接修复的改进Canny算法[J]. 焊接学报, 2018, 39(1): 37 − 40. Dong Yao, Li Weichao, Liu Jinyue, et al. An improved Canny operator used for aero-engine's blade welding and repairing[J]. Transactions of the China Welding Institution, 2018, 39(1): 37 − 40.

[9] 桂楷欽. 焊缝缺陷射线数字成像参考图像研究[D]. 南昌: 南昌航空大学, 2019. Gui Kaiqin. Research on digital reference image of digital radiography for weld defect[D]. Nanchang: Nanchang Hangkong University, 2019.

[10] 刘晓刚, 闫红方, 张荣. 基于形态学多尺度多结构的熔池图像边缘检测[J]. 热加工工艺, 2019, 48(5): 216 − 219. Liu Xiaogang, Yan Hongfang, Zhang Rong. Edge detection of molten pool image based on morphology multi-scale and multi-structuring elements[J]. Hot Working Technology, 2019, 48(5): 216 − 219.

[11] Xie S N, Tu Z W. Holistically-Nested edge detection[J]. International Journal of Computer Vision, 2017, 125(1−3): 3 − 18. doi: 10.1007/s11263-017-1004-z

[12] Liu Y, Cheng M, Hu X, et al. Richer convolutional features for edge detection[C]//IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, HI, USA, 2017: 5872−5881.

[13] Yu Z, Feng C, Liu M, et al. CASENet: Deep category-aware semantic edge detection[C]//IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, HI, USA, 2017: 1761−1770.

[14] Bertasius G, Shi J, Torresan L. DeepEdge: A multi-scale bifurcated deep network for top-down contour detection[C]//IEEE Conference on Computer Vision and Pattern Recognition, Boston, MA, USA, 2015: 4380−4389.

[15] Simard P Y, Steinkraus D, Platt J C. Best practices for convolutional neural networks applied to visual document analysis[C]//International Conference on Document Analysis and Recognition, Edinburgh, UK, 2003: 958 − 963.

[16] Zhang H, Cisse M, Dauphin Y N, et al. Mixup: Beyond empirical risk minimization[C]//International Conference on Learning Representations, Vancouver, BC, Canada, 2018: 1−13.

[17] Goodfellow I J, Pouget A J, Mirza M, et al. Generative adversarial nets[C]//International Conference on Neural Information Processing Systems, Montréal, Canada, 2014: 2672−2680.

-

期刊类型引用(1)

1. 马晓锋,夏攀,刘海生,史铁林,王中任. 全位置焊接熔池的深度学习检测方法. 机械工程学报. 2023(12): 272-283 .  百度学术

百度学术

其他类型引用(0)

下载:

下载: